Hoy, 19 de diciembre de 2025, ha tenido lugar la defensa de la tesis doctoral de D. Iván Antonio Negrín Díaz, titulada “Metaheuristic optimization for the sustainable and resilient design of hybrid and composite frame building structures with advanced integrated modeling”, dirigida por los profesores Víctor Yepes y Moacir Kripka. La tesis ha obtenido la máxima calificación de sobresaliente «cum laude». A continuación, presentamos un breve resumen de la misma.

El cambio climático y la rápida expansión de las áreas urbanas han intensificado el impacto ambiental del sector de la construcción, responsable de cerca del 37 % de las emisiones globales de CO₂ y de más de un tercio del consumo energético mundial. Por tanto, mejorar la sostenibilidad y la resiliencia de las estructuras de edificios se ha convertido en una prioridad esencial, plenamente alineada con los Objetivos de Desarrollo Sostenible de las Naciones Unidas. Esta tesis doctoral aborda este reto mediante el desarrollo de un marco de diseño optimizado que permite obtener soluciones innovadoras, sostenibles y resilientes para estructuras porticadas.

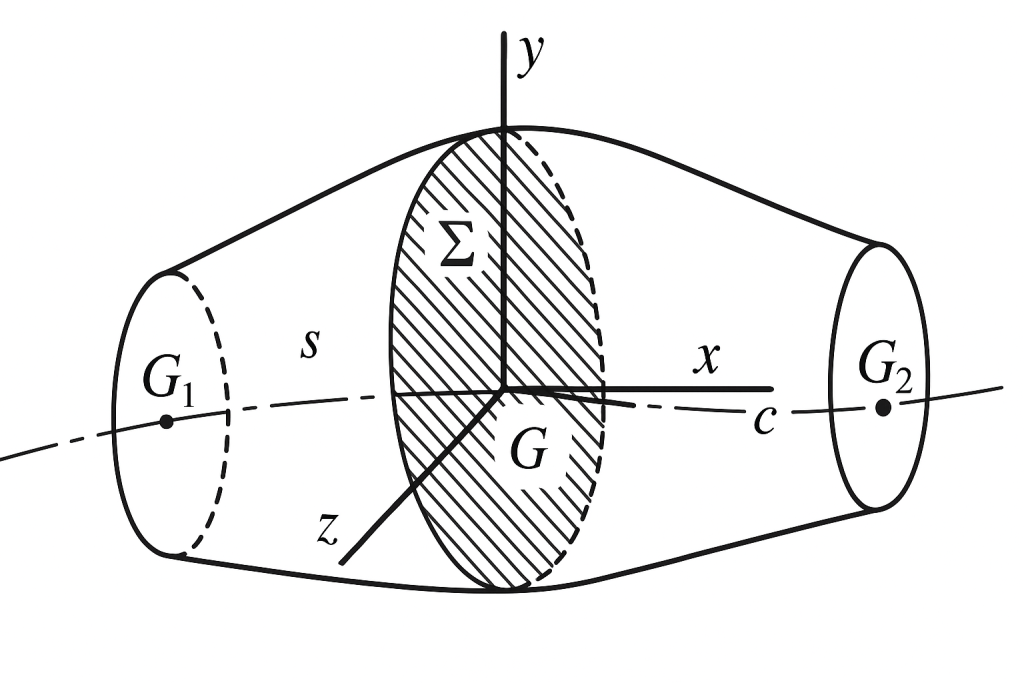

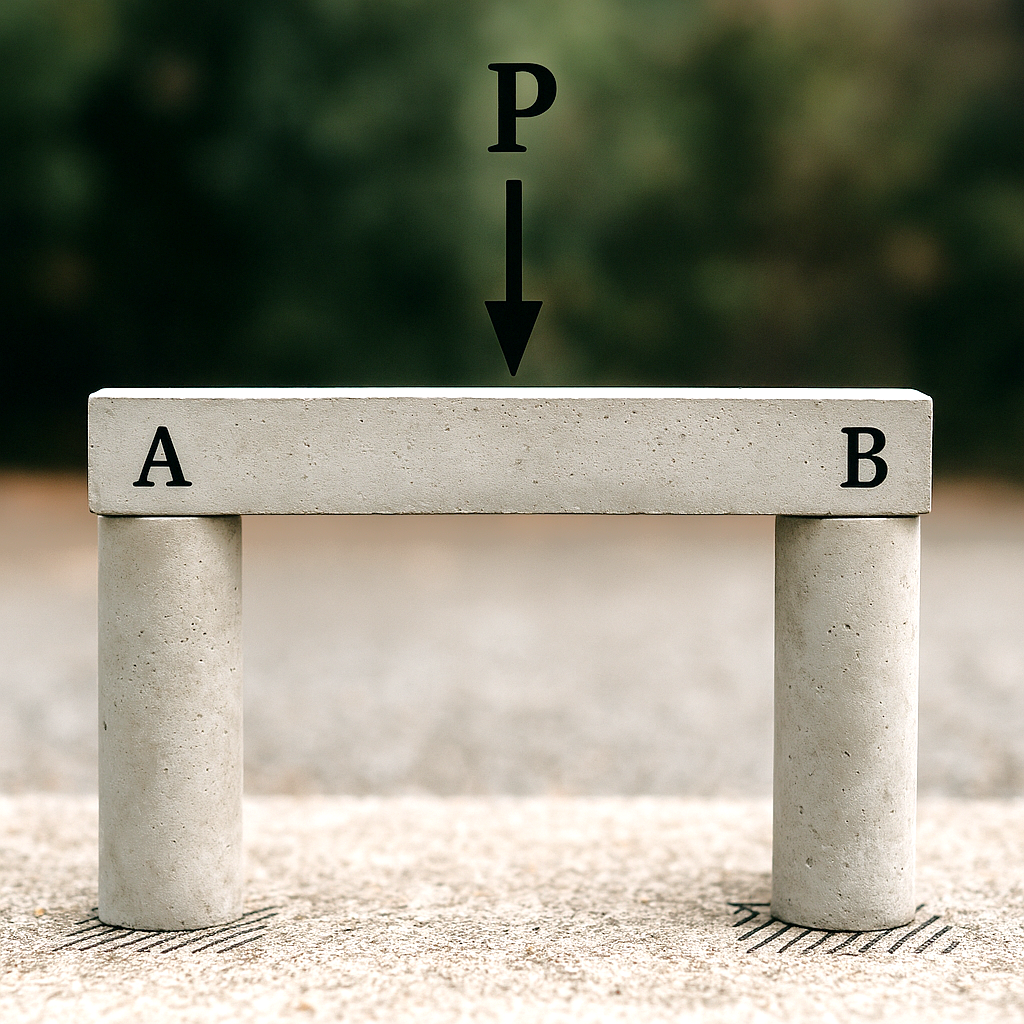

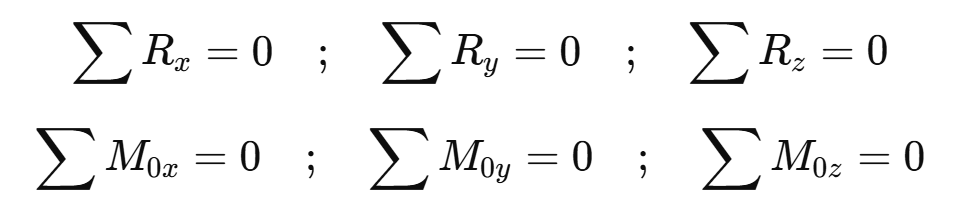

El objetivo principal de la investigación es crear y validar metodologías avanzadas que integren tipologías estructurales híbridas y mixtas con estrategias de optimización de vanguardia apoyadas en modelos estructurales de alta fiabilidad. Para ello, se formulan problemas de optimización que consideran conjuntamente criterios económicos, ambientales, constructivos, de durabilidad y de seguridad estructural, e incorporan, además, aspectos frecuentemente ignorados, como la interacción suelo-estructura, la robustez frente al colapso progresivo y el desempeño ambiental a lo largo del ciclo de vida de la estructura. Entre los objetivos específicos, destacan los siguientes: evaluar metaheurísticas avanzadas y técnicas de optimización asistida por metamodelos; cuantificar los riesgos de modelos estructurales simplificados; integrar la resiliencia como restricción de diseño; valorar los beneficios de tipologías híbridas y mixtas; explorar estrategias de optimización multiobjetivo; y comparar enfoques de diseño basados en fases iniciales y en el ciclo de vida.

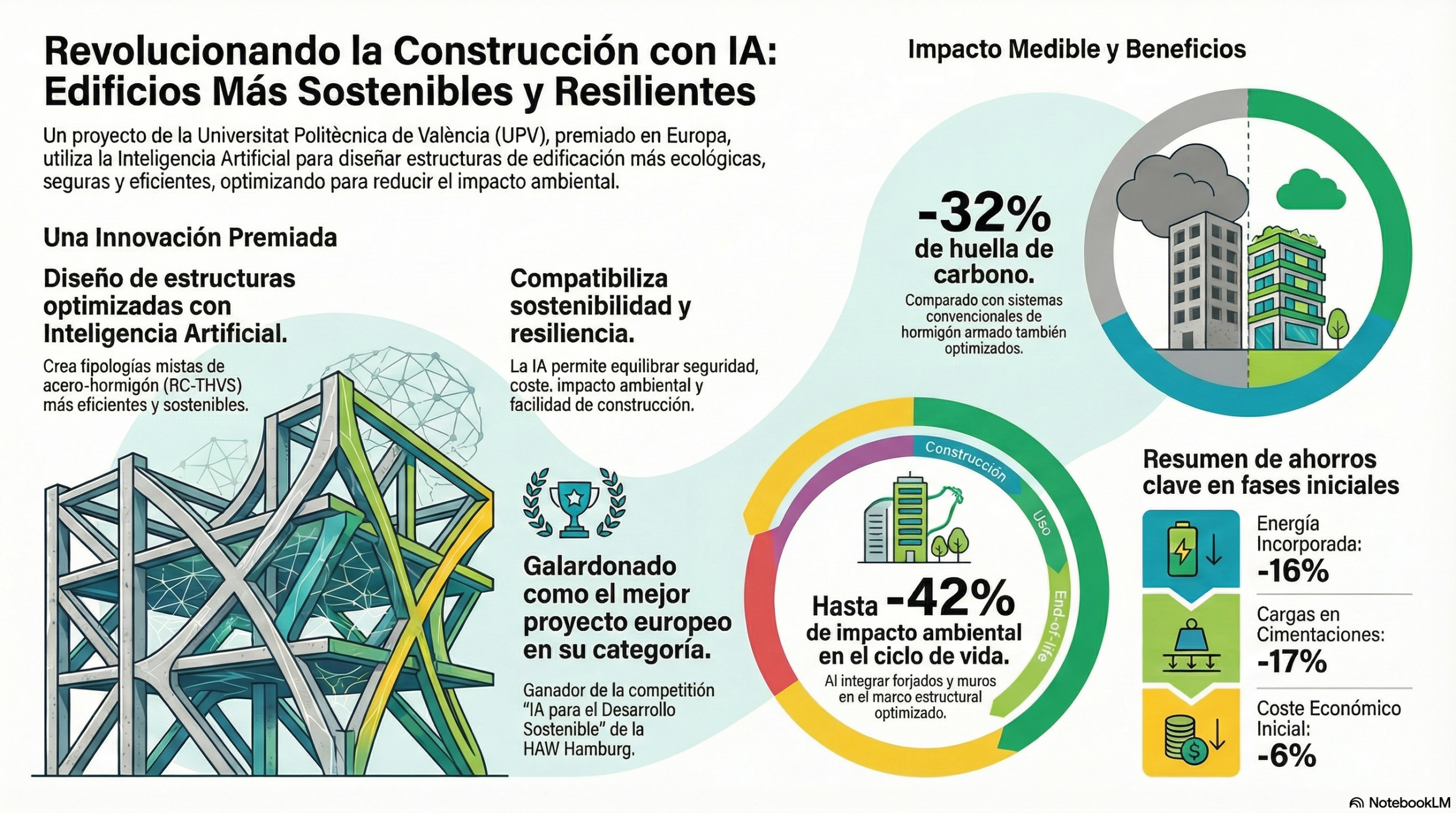

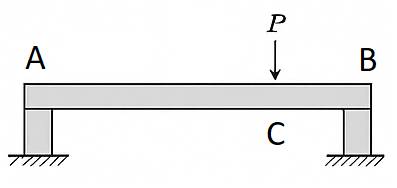

Los resultados muestran que las estrategias metaheurísticas avanzadas y asistidas por metamodelos (como BBO-CINS, enfoques basados en Kriging y Optimización Escalarizada de Pareto) superan claramente a los algoritmos tradicionales, ya que logran reducciones de hasta el 90 % en el coste computacional en problemas de un solo objetivo y mejoras de hasta el 140 % en la calidad del frente de Pareto en problemas de varios objetivos. Asimismo, se evidencia el riesgo de simplificar en exceso los modelos estructurales: omitir aspectos críticos, como la interacción suelo-estructura o los elementos secundarios (forjados, muros), puede distorsionar el diseño, comprometer la seguridad (por ejemplo, al subestimar la resistencia al colapso) y aumentar los impactos ambientales a largo plazo, debido al deterioro acelerado y a las mayores necesidades de mantenimiento. También se demuestra que, al incorporar la resiliencia como restricción de diseño en lugar de tratarla como un objetivo de optimización, es posible mejorar la robustez frente al colapso progresivo sin perjudicar la sostenibilidad y reducir la carga ambiental del diseño robusto en torno al 11 % al considerar elementos estructurales secundarios.

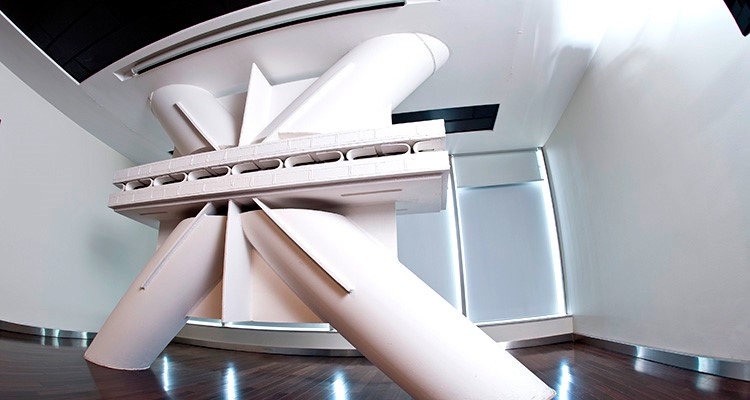

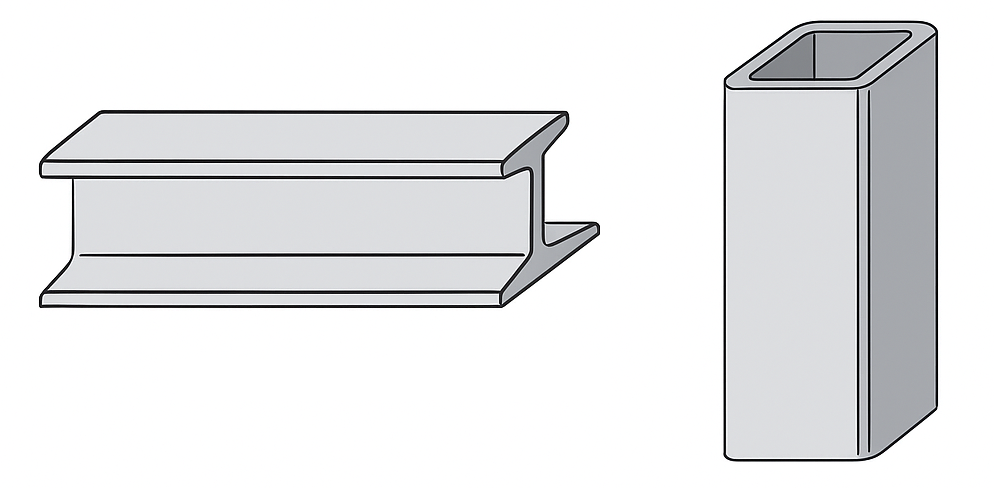

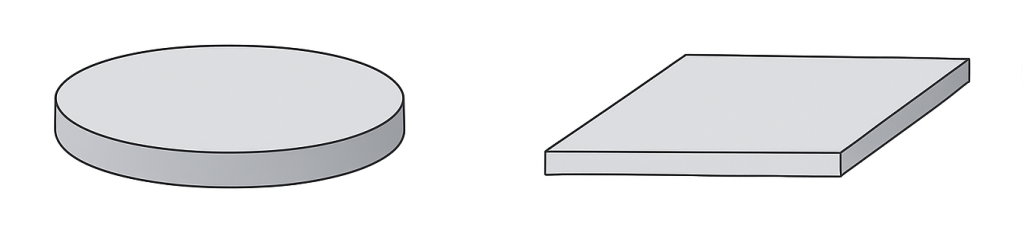

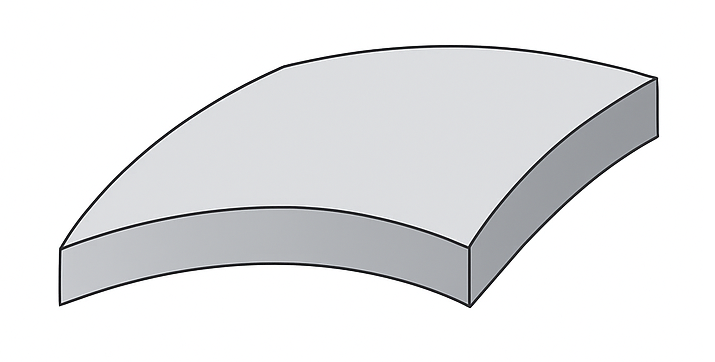

A nivel de componentes estructurales, la optimización de las vigas de acero soldadas confirmó las ventajas de la hibridación y de las geometrías variables, lo que dio lugar a la tipología Transversely Hybrid Variable Section (THVS), que reduce los costes de fabricación hasta en un 70 % respecto a las vigas I convencionales. Su integración en pórticos compuestos de hormigón armado y elementos THVS proporcionó mejoras adicionales en sostenibilidad, con reducciones del 16 % en emisiones y del 11 % en energía incorporada en las fases iniciales de diseño, y hasta un 30 % en emisiones de ciclo de vida en comparación con los sistemas tradicionales de hormigón armado. La inclusión de forjados y muros estructurales amplificó estos beneficios, reduciendo los impactos del ciclo de vida hasta en un 42 % respecto a configuraciones de pórticos en las que solo el esqueleto trabaja estructuralmente (omitiendo forjados y muros).

En conjunto, esta tesis demuestra que las metodologías de diseño basadas en la optimización, apoyadas en modelos estructurales realistas y en estrategias computacionales avanzadas, permiten concebir edificios que, al mismo tiempo, son más sostenibles y resilientes. Al resaltar las ventajas de las tipologías híbridas y mixtas e integrar la resiliencia sin comprometer la sostenibilidad, la investigación establece un marco claro para el diseño contemporáneo. Además, al enfatizar la optimización a lo largo de todo el ciclo de vida, ofrece una base metodológica sólida para impulsar una nueva generación de edificaciones alineadas con los objetivos globales de sostenibilidad y de acción climática.

Referencias:

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2025). Life-cycle environmental impact optimization of an RC-THVS composite frame for sustainable construction. Engineering Structures, 345, 121461. DOI:10.1016/j.engstruct.2025.121461

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2025). Manufacturing cost optimization of welded steel plate I-girders integrating hybrid construction and tapered geometry. International Journal of Advanced Manufacturing Technology, 140, 1601-1624. DOI:10.1007/s00170-025-16365-2

- NEGRÍN, I.; CHAGOYÉN, E.; KRIPKA, M.; YEPES, V. (2025). An integrated framework for Optimization-based Robust Design to Progressive Collapse of RC skeleton buildings incorporating Soil-Structure Interaction effects. Innovative Infrastructure Solutions, 10:446. DOI:10.1007/s41062-025-02243-z

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2025). Design optimization of a composite typology based on RC columns and THVS girders to reduce economic cost, emissions, and embodied energy of frame building construction. Energy and Buildings, 336:115607. DOI:10.1016/j.enbuild.2025.115607

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2025). Metamodel-assisted design optimization of robust-to-progressive-collapse RC frame buildings considering the impact of floor slabs, infill walls, and SSI implementation. Engineering Structures, 325:119487. DOI:10.1016/j.engstruct.2024.119487

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2024). Optimized Transverse-Longitudinal Hybrid Construction for Sustainable Design of Welded Steel Plate Girders. Advances in Civil Engineering, 2024:5561712. DOI:10.1155/2024/5561712.

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2023). Multi-criteria optimization for sustainability-based design of reinforced concrete frame buildings. Journal of Cleaner Production, 425:139115. DOI:10.1016/j.jclepro.2023.139115

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2023). Metamodel-assisted meta-heuristic design optimization of reinforced concrete frame structures considering soil-structure interaction. Engineering Structures, 293:116657. DOI:10.1016/j.engstruct.2023.116657

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2023). Design optimization of welded steel plate girders configured as a hybrid structure. Journal of Constructional Steel Research, 211:108131. DOI:10.1016/j.jcsr.2023.108131

- TERREROS-BEDOYA, A.; NEGRÍN, I.; PAYÁ-ZAFORTEZA, I.; YEPES, V. (2023). Hybrid steel girders: review, advantages and new horizons in research and applications. Journal of Constructional Steel Research, 207:107976. DOI:10.1016/j.jcsr.2023.107976.

- NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2023). Metamodel-assisted design optimization in the field of structural engineering: a literature review. Structures, 52:609-631. DOI:10.1016/j.istruc.2023.04.006