¿Cómo es posible que una viga de hormigón, un material intrínsecamente frágil en lo que respecta a la tracción, soporte el paso de miles de vehículos en un viaducto sin colapsar ni agrietarse? La respuesta no radica en el grosor de la estructura, sino en un «secreto invisible»: la precompresión activa. Como ingenieros, no solo vertemos material, sino que diseñamos un estado de tensiones internas que permite a las infraestructuras modernas desafiar los límites de la física.

¿Cómo es posible que una viga de hormigón, un material intrínsecamente frágil en lo que respecta a la tracción, soporte el paso de miles de vehículos en un viaducto sin colapsar ni agrietarse? La respuesta no radica en el grosor de la estructura, sino en un «secreto invisible»: la precompresión activa. Como ingenieros, no solo vertemos material, sino que diseñamos un estado de tensiones internas que permite a las infraestructuras modernas desafiar los límites de la física.

Aunque ya he escrito varios artículos sobre este tema en el blog, a continuación, se presentan las cinco claves técnicas que convierten el hormigón en una herramienta de ingeniería de alta precisión.

No se trata solo de soporte, sino de resistencia activa.

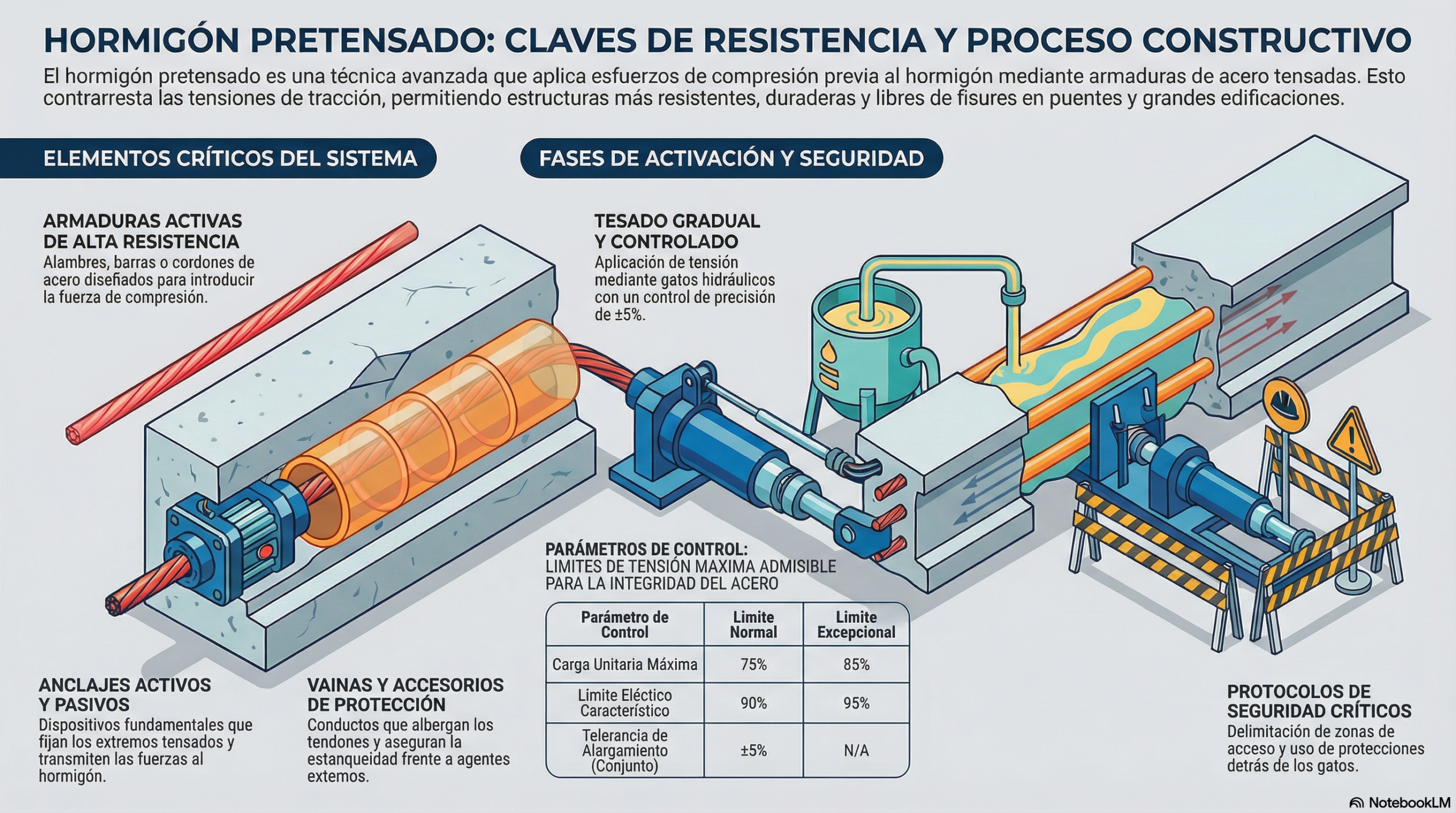

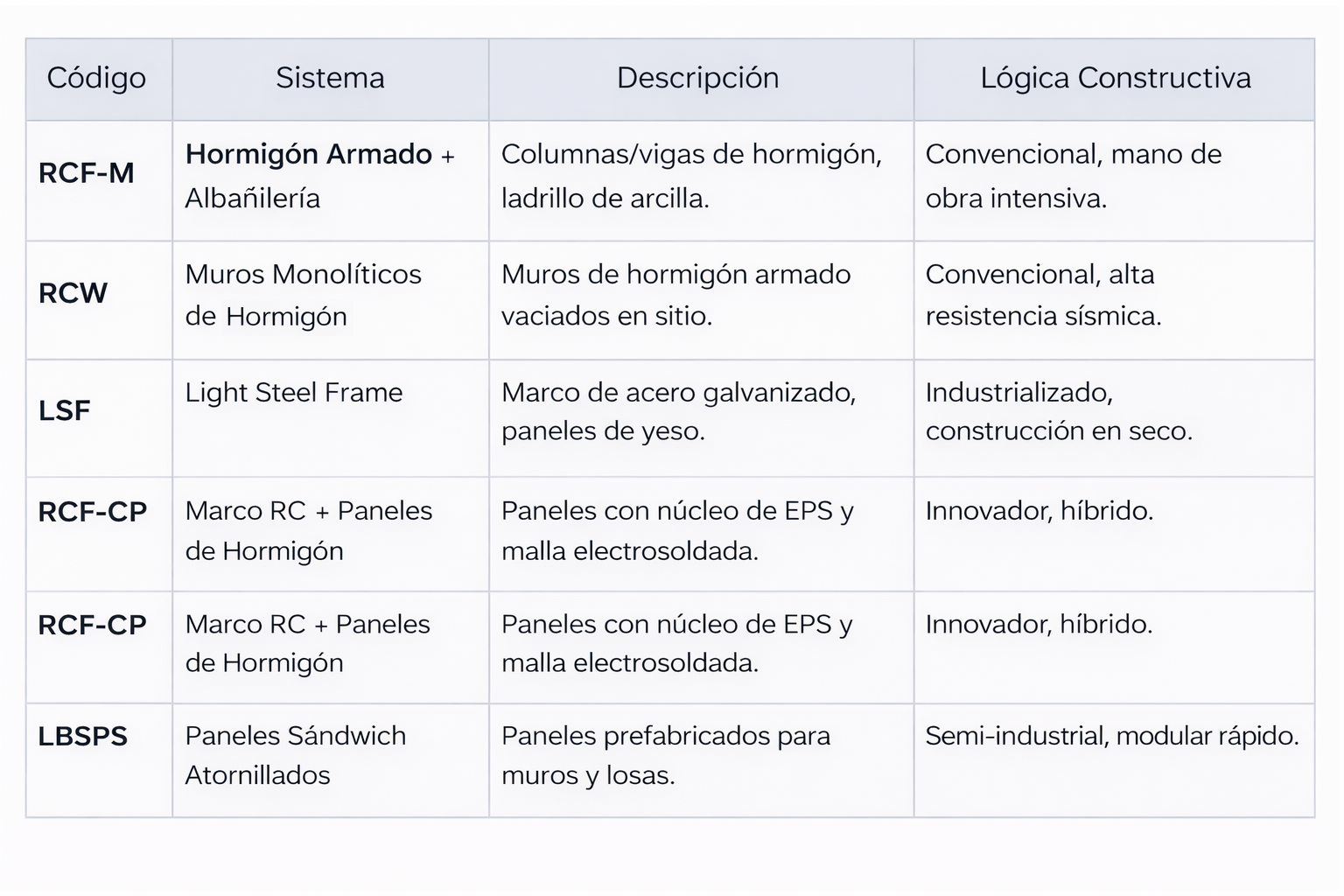

El cambio de paradigma fundamental es que el hormigón pretensado no «espera» a recibir la carga para trabajar. Mediante esta técnica, sometemos al material a un esfuerzo de compresión previo que contrarresta las tracciones que sufrirá durante su vida útil. Esto lo convierte en un sistema dinámico.

Para que esta «fuerza interna» sea efectiva, incluso el almacenamiento de los materiales se rige por estrictas normas de ingeniería. Por ejemplo, los alambres de alta resistencia no pueden enrollarse de cualquier manera: su diámetro de bobinado nunca debe ser inferior a 250 veces el diámetro del propio alambre, a fin de evitar deformaciones permanentes que puedan afectar su capacidad elástica. Como bien define la normativa técnica:

«El pretensado es una técnica que aumenta la capacidad de resistencia del hormigón a las cargas al someterlo previamente a esfuerzos de compresión».

El acero como un «músculo» en tensión.

Las denominadas armaduras activas son el alma de la estructura. No nos referimos al acero corrugado convencional, sino a elementos de alta resistencia que actúan como músculos sometidos a una tensión constante. En función del diseño, el ingeniero selecciona diferentes configuraciones:

- Alambres: suministrados en rollos, son fundamentales para el control de la deformación.

- Barras: se suministran en tramos rectos para garantizar su integridad y evitar daños durante el transporte.

- Cordones: trenzados de dos, tres o siete alambres. Para garantizar su «fuerza vital», los cordones de dos o tres alambres requieren rollos de al menos 600 mm de diámetro, mientras que los de siete alambres exigen bobinas de 750 mm de diámetro.

Para evitar la corrosión y mantener la adherencia, estas armaduras deben guardarse en lugares ventilados, lejos de la humedad y libres de grasas o polvo, que podrían alterar la longitud de transmisión necesaria para transferir el esfuerzo al hormigón.

La coreografía de la precisión: gatos y anclajes.

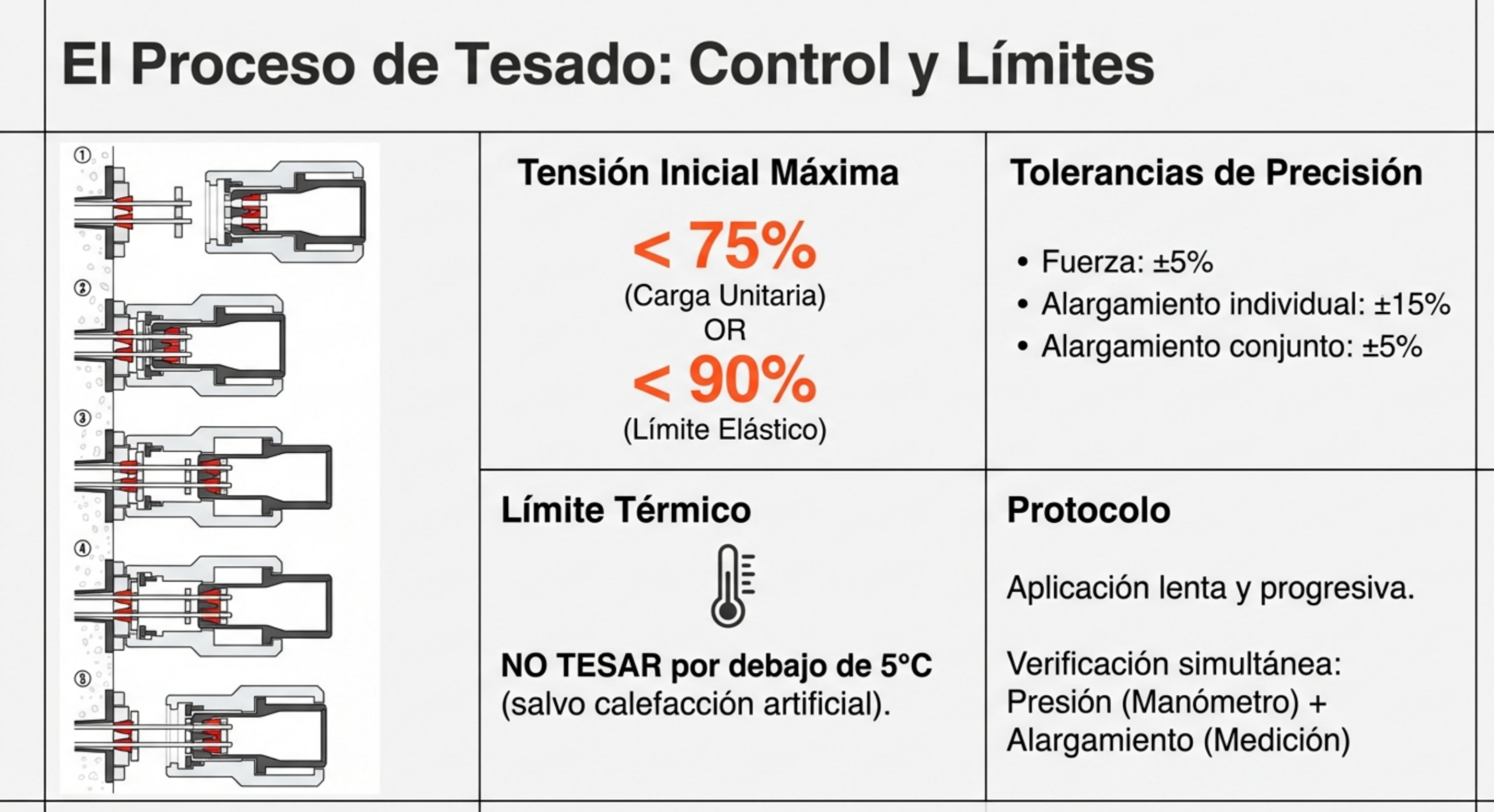

El proceso de tensado es una coreografía lenta y progresiva en la que la fuerza bruta se gestiona con precisión milimétrica. Utilizamos gatos hidráulicos y centrales de presión para aplicar la carga sobre los anclajes, que se clasifican según su función: el anclaje activo (tipo L) se encuentra en el extremo de tensado, mientras que el anclaje pasivo (tipo S) en el extremo fijo.

En obra, la precisión no es negociable. La fuerza aplicada debe mantenerse dentro de un margen de ±5 % respecto al valor del proyecto. Controlamos los alargamientos con tolerancias muy estrictas: un máximo de ±15 % para un tendón individual, pero solo de ±5 % para el conjunto de tendones de la misma sección. Además, como ingenieros sénior, sabemos que el termómetro manda: está prohibido iniciar el tesado por debajo de 5 °C sin medidas especiales. Es una máxima del sector que

«Cualquier fallo en el tensado o en los materiales puede afectar a la integridad estructural del proyecto».

Vainas de inyección: mucho más que un relleno.

Las vainas no son simples tubos, sino conductos que garantizan la durabilidad. En los sistemas postensados, tras el tensado, inyectamos una lechada técnica que debe cumplir con estrictos parámetros químicos. Utilizamos cemento Portland CEM-I con una relación agua/cemento (a/c) entre 0,4 y 0,5 para garantizar una porosidad mínima y una protección óptima.

La inyección es un proceso crítico:

- Velocidad y longitud: La lechada debe avanzar de forma constante entre 5 y 15 m/min, sin superar nunca una longitud de inyección de 120 m.

- Control térmico: La temperatura de la mezcla jamás debe exceder los 30 °C para evitar fraguados prematuros dentro de la vaina.

- Puntos de purga: El éxito se confirma en los respiraderos o tubos de purga. La operación solo termina cuando la lechada rebosa por ellos con la misma consistencia y densidad que la mezcla original.

La seguridad en entornos de altas energías.

Un tendón de pretensado que acumula tensión es, en esencia, un resorte gigante con una energía potencial letal. La seguridad no se reduce al sentido común, sino que implica un protocolo de «altas energías». Es obligatorio establecer un perímetro de seguridad estricto y utilizar placas perforadas o envoltorios que actúen como escudo en caso de que una armadura llegara a partirse.

Existen prohibiciones críticas por motivos de seguridad y técnicos: está terminantemente prohibido utilizar aire comprimido para la inyección y, bajo ningún concepto, los operarios deben mirar a través de los tubos o rebosaderos durante el proceso. La ingeniería moderna debe equilibrar una fuerza física inmensa con un control humano absoluto, documentando cada presión y cada alargamiento para garantizar la trazabilidad total de la estructura.

Conclusión: mirando al futuro de la ingeniería.

El hormigón pretensado es la victoria de la inteligencia sobre la debilidad intrínseca de los materiales. Al dominar la presión interna controlada, hemos pasado de construir estructuras pesadas y pasivas a diseñar obras de arte de la ingeniería que, en realidad, son organismos activos en equilibrio.

Al observar la esbeltez de un puente moderno, cabe preguntarse: ¿seremos capaces de diseñar estructuras aún más ligeras y atrevidas ahora que sabemos que la verdadera fuerza reside en la presión interna invisible que las sostiene?

En esta conversación puedes escuchar algunas de las claves del hormigón pretensado.

En este vídeo se resumen las ideas más interesantes de este material.

En este documento se describen las ideas fundamentales:

Hormigón_Pretensado_Técnica_y_Ejecución

Curso:

Curso de fabricación y puesta en obra del hormigón.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.