Introducción: El despertar de una conciencia colectiva.

Introducción: El despertar de una conciencia colectiva.

Durante dos siglos, el modelo industrial funcionó como un motor ciego que ignoraba el agotamiento de su propio combustible. Según la lógica de la Revolución Industrial, el progreso se concebía como una expansión lineal e inagotable, en la que la naturaleza era una reserva infinita de materias primas y un vertedero sin fondo.

La teoría económica tradicional se limitaba a buscar un «equilibrio de mercado» basado estrictamente en el precio, la oferta y la demanda. Sin embargo, este enfoque falló al no considerar los límites biofísicos del planeta. Hoy sabemos que ignorar el capital natural no solo es un error ecológico, sino también una imprudencia financiera y social.

El propósito de este análisis es explorar los puntos de inflexión que nos obligaron a despertar. Desde las advertencias del MIT hasta la Agenda 2030, estos hitos narran cómo la humanidad ha intentado rediseñar su futuro ante la evidencia de que el crecimiento material no puede ser eterno.

El error de Malthus y la trampa de las revoluciones agrícolas.

A finales del siglo XVIII, Thomas Malthus planteó una advertencia: mientras la producción de alimentos avanzaba en progresión aritmética, la población lo hacía en progresión exponencial. Esta brecha, conocida como la «catástrofe maltusiana», sugería que el hambre era el freno inevitable de nuestra especie.

Sin embargo, la Revolución Agraria y la posterior Revolución Verde de los años sesenta introdujeron un arsenal de semillas de alto rendimiento, fertilizantes químicos y riego intensivo. Parecíamos haber «vencido» a Malthus, pero en realidad solo aumentamos el consumo de recursos finitos y de energía.

Desde una perspectiva estratégica, la tecnología actuó como un analgésico que invisibilizó los límites biofísicos del planeta. Al aumentar artificialmente la capacidad de carga del suelo, ocultamos el problema de fondo: seguimos operando bajo un sistema que exige una expansión material infinita en un entorno limitado.

1972: El despertar político y la confirmación de la ciencia.

1972 fue el año en que la diplomacia y el pensamiento sistémico convergieron. Mientras 113 naciones se reunían en la Cumbre de Estocolmo para crear el PNUMA, un think tank pionero, el Club de Roma, publicaba Los límites del crecimiento, un informe del MIT que desafiaba el dogma del progreso ilimitado.

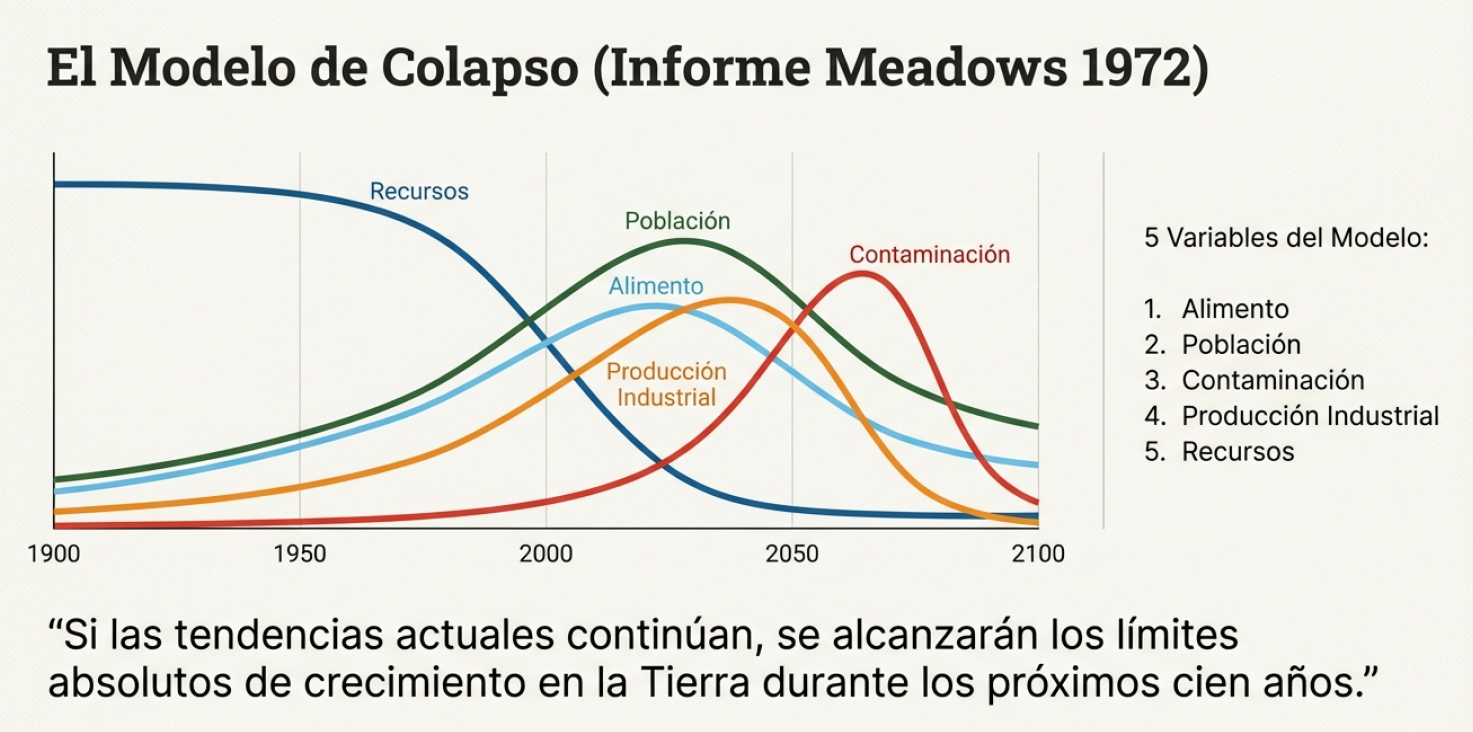

El modelo científico analizó cinco variables críticas: población, producción industrial, alimentos, contaminación y recursos naturales. La conclusión fue un jarro de agua fría para la clase política de la época, ya que por primera vez se introducía la noción de que el crecimiento exponencial colapsaría a corto plazo.

«Si el incremento actual de la población mundial, la industrialización, la contaminación, la producción de alimentos y la explotación de los recursos naturales se mantienen sin variar, se alcanzarán los límites absolutos del crecimiento de la Tierra en los próximos cien años».

Esta tesis resultó disruptiva, pues demostró que no podíamos gestionar el planeta como compartimentos estancos. El año 1972 marcó el inicio de la conciencia política moderna al establecer que la salud de los ecosistemas es la infraestructura básica sobre la que se asienta cualquier economía viable.

La crisis del petróleo: el catalizador de la eficiencia y de la brecha social.

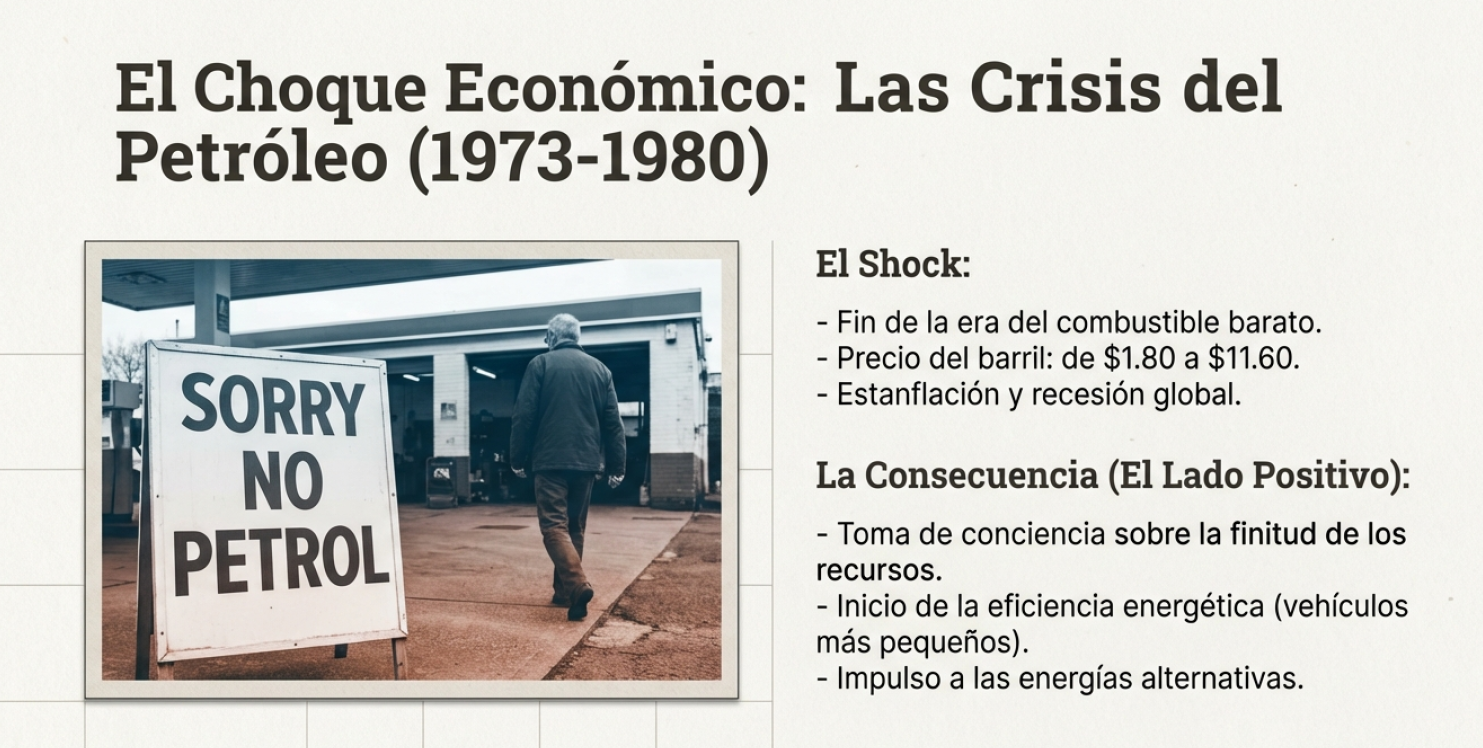

Entre 1973 y 1980, la «edad de oro» de los combustibles baratos llegó a su fin. El precio del barril de crudo aumentó de 1,8 a 11,6 dólares, lo que desencadenó una inflación global que no solo afectó al sector energético, sino que también tuvo profundas repercusiones sociales. La crisis agravó la brecha entre ricos y pobres y provocó recortes masivos en los programas de salud, educación y bienestar.

La recesión y el desempleo en el sector manufacturero obligaron a la industria a reinventarse bajo el lema de la eficiencia. Lo que comenzó como una medida de supervivencia económica terminó sentando las bases de la sostenibilidad energética moderna y del diseño industrial consciente.

- Eficiencia en el transporte: fabricación de vehículos con menor consumo y emisiones.

- Fomento de lo colectivo: impulso estratégico del transporte público frente al vehículo privado.

- Renovables: nacimiento de la industria fotovoltaica y la búsqueda de alternativas al petróleo.

- Geopolítica de la finitud: reconocimiento oficial de que la dependencia de los recursos fósiles constituye una vulnerabilidad estratégica.

Informe Brundtland: redefinición de la calidad del «progreso».

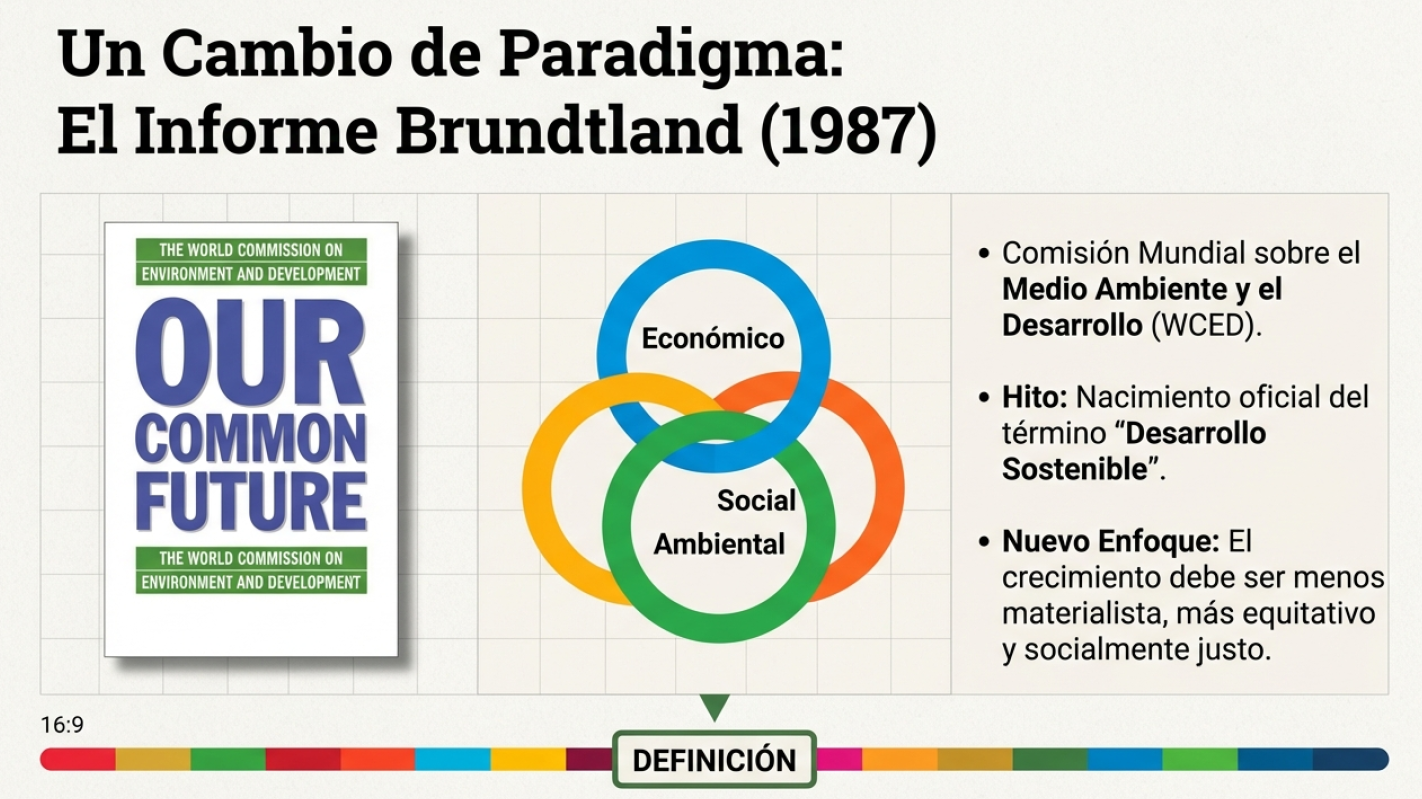

En 1983, la Comisión Brundtland recibió el encargo de replantear un modelo de desarrollo global que estaba devorando su propio entorno. El informe final de 1987, Nuestro futuro común, no proponía dejar de crecer, sino transformar radicalmente la «calidad del crecimiento» para hacerlo menos materialista y menos intensivo en energía.

Este documento consagró la definición que hoy constituye el pilar de nuestra disciplina:

«El desarrollo sostenible es aquel que satisface las necesidades del presente sin comprometer la capacidad de las generaciones futuras para satisfacer las suyas».

El cambio de paradigma fue absoluto: la sostenibilidad dejó de ser una preocupación ambientalista para convertirse en una tríada en la que lo económico, lo social y lo ecológico son interdependientes. La equidad se convirtió en un requisito técnico para el progreso y no solo en una aspiración ética.

De los Objetivos de Desarrollo del Milenio a la Agenda 2030: una evolución necesaria.

Los Objetivos de Desarrollo del Milenio (ODM) de 2000 fueron un intento loable, pero limitado. Se centraron únicamente en los países en desarrollo y fueron diseñados por un grupo reducido de expertos. El resultado fue desigual: a pesar de los esfuerzos realizados, millones de personas (925 millones pasaban hambre) se quedaron fuera del progreso debido a la falta de indicadores claros y de participación local.

En 2015, la transición a los Objetivos de Desarrollo Sostenible (ODS) de la Agenda 2030 corrigió estos fallos. Por primera vez, se creó una agenda de «aplicación universal» mediante consultas públicas y encuestas globales que involucraron a la ciudadanía en la definición de sus propias prioridades y metas.

La diferencia crítica radica en la participación ciudadana y la visión sistémica. Los ODS reconocen que la pobreza en un país y el cambio climático en otro son dos caras de la misma moneda. Esta legitimidad democrática es el factor que faltaba en los intentos anteriores para transformar la sostenibilidad en una misión colectiva.

Conclusión: la pregunta que define nuestra era.

La sostenibilidad no es una moda pasajera ni una concesión estética de las empresas; es la respuesta histórica acumulada ante las crisis de recursos, las desigualdades sociales y los límites científicos que ya no podemos ignorar. En esencia, es nuestra estrategia de supervivencia como civilización.

Nuestra responsabilidad generacional nos obliga a mirar hacia el pasado para comprender que el crecimiento tal y como lo conocimos en el siglo XX es una anomalía histórica. El éxito de la Agenda 2030 dependerá de si somos capaces de aplicar el rigor del pensamiento sistémico a cada decisión económica y política.

Al observar la velocidad a la que consumimos actualmente, es inevitable preguntarse si estamos actuando conforme a los principios de equidad del Informe Brundtland para proteger a las generaciones futuras o si seguimos ignorando deliberadamente los límites físicos que la ciencia nos señaló hace ya más de medio siglo.

En esta conversación puedes escuchar algunas de las ideas más importantes.

El vídeo que os dejo resume bien la historia de la sostenibilidad.

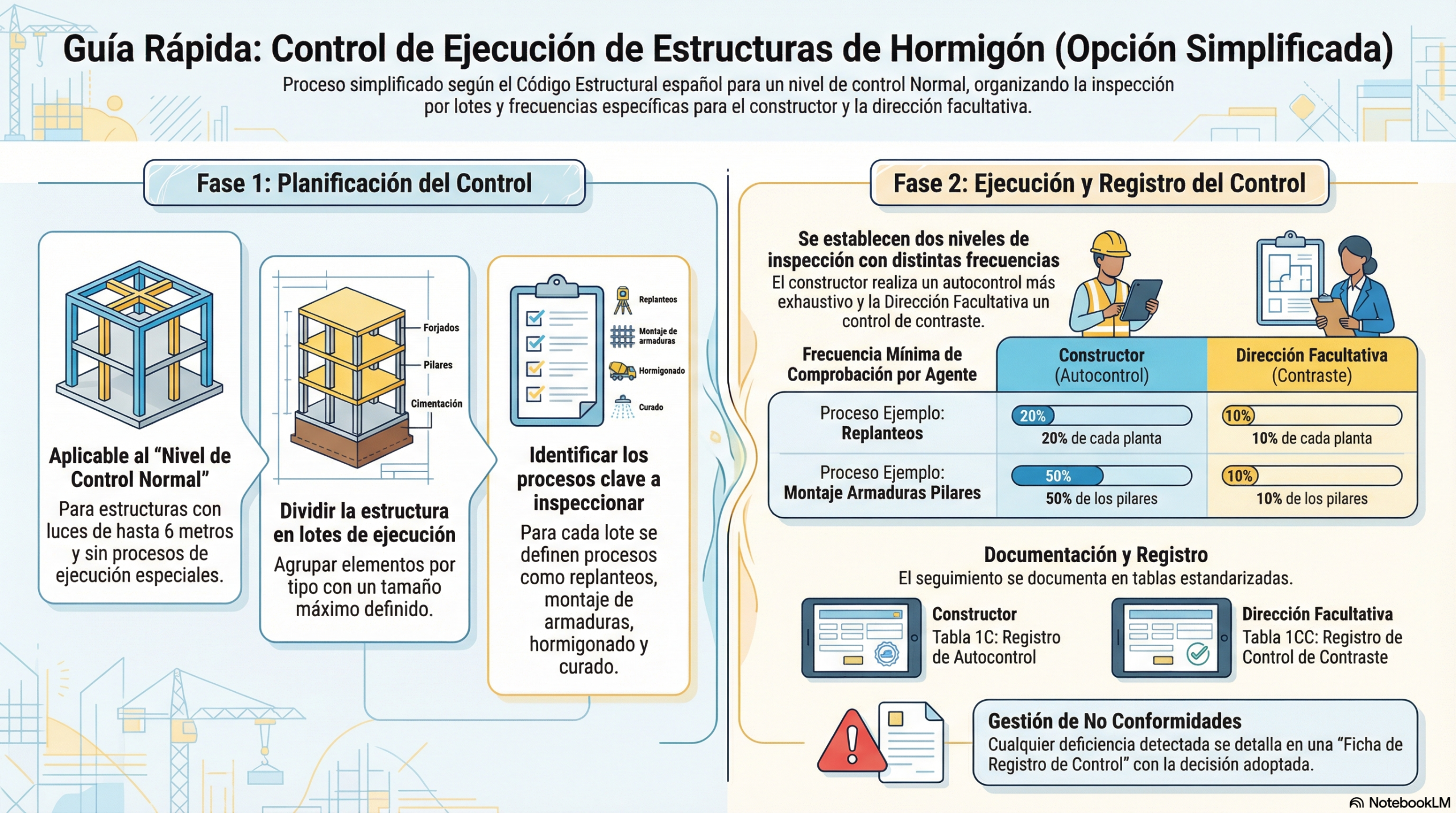

En este documento podéis ver las ideas más relevantes.

Sostenibilidad_De_la_Revolución_Industrial_a_2030

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.