Durante los días 3-4 de julio de 2024 tiene lugar en Jaén (Spain) el 28th International Congress on Project Management and Engineering AEIPRO 2024. Es una buena oportunidad para debatir y conocer propuestas sobre dirección e ingeniería de proyectos. Nuestro grupo de investigación, dentro del proyecto de investigación HYDELIFE, presenta varias comunicaciones. A continuación os paso los resúmenes.

SÁNCHEZ-GARRIDO, A.; GUAYGUA, B.; VILLALBA, P.; YEPES, V. (2024). Ingeniería de proyectos basada en modelos de análisis multivariante. Aplicación al dimensionamiento de losas planas aligeradas. 28th International Congress on Project Management and Engineering, AEIPRO, 3-4 de julio, Jaén (Spain)

Esta investigación propone una metodología para dimensionar losas innovadoras de hormigón armado sin vigas, que permiten el uso eficiente de materiales. Utilizando un enfoque estadístico y modelos de regresión lineal, se proporcionan criterios para calcular el espesor de la losa aligerada con esferas o discos plásticos presurizados, minimizando el número de variables. Este espesor puede estimarse a partir de la luz principal entre apoyos, la altura del disco o el diámetro de la esfera, así como el uso previsto del edificio. El modelo final ajustado logra explicar el 98% de la variabilidad en el espesor de la losa para luces comprendidas entre 5 m y 16 m. Este tipo de forjado contribuye a la reducción del consumo de hormigón y acero, lo que resulta en una disminución del peso y las cargas aplicadas. Esto impacta directamente en los costos y mejora los indicadores ambientales en comparación con los sistemas tradicionales. Se presenta como una alternativa eficiente para edificaciones, permitiendo la combinación de parámetros estructurales, constructivos y sostenibles.

SÁNCHEZ-GARRIDO, A.; YEPES-BELLVER, L.; SAIZ, D.; YEPES, V. (2024). Ingeniería de proyectos en Modernos Métodos de Construcción: El caso de edificios con losas planas mediante elementos aligerantes multiaxiales. 28th International Congress on Project Management and Engineering, AEIPRO, 3-4 de julio, Jaén (Spain)

Los métodos modernos de construcción (Modern Methods of Construction, MMC), o como algunos llaman “construcción inteligente“, constituyen alternativas a la construcción tradicional. Esta nueva forma de construir implica, necesariamente, un cambio en la forma de dirigir los proyectos, que pasan a ser industrializados, donde la eficiencia estructural, constructiva y la sostenibilidad ambiental y social son protagonistas. El objetivo del artículo es identificar los aspectos característicos de estas construcciones innovadoras que influyen en la ingeniería de proyectos, integrando a grupos multidisciplinares como arquitectos, ingenieros estructurales y empresas constructoras. Para ello se realizará un estudio para el caso de edificios construidos con losas planas aligeradas mediante elementos aligerantes multiaxiales. Los resultados muestran que estos diseños permiten integrar el proyecto, la fabricación de elementos y el procedimiento constructivo. El proyecto de estas construcciones permite aligerar y reducir las cuantías de hormigón y acero en aquellas zonas de las losas donde la capacidad portante es insignificante. Además, se ha comparado este diseño con otros tradicionales, destacando una reducción de costes y un aumento de la sostenibilidad a lo largo del ciclo de vida.

YEPES-BELLVER, L.; MARTÍNEZ-PAGÁN, P.; ALCALÁ, J.; YEPES, V. (2024). Análisis del predimensionamiento de tableros óptimos de puentes losa pretensados aligerados y su incidencia en el proyecto estructural. 28th International Congress on Project Management and Engineering, AEIPRO, 3-4 de julio, Jaén (Spain)

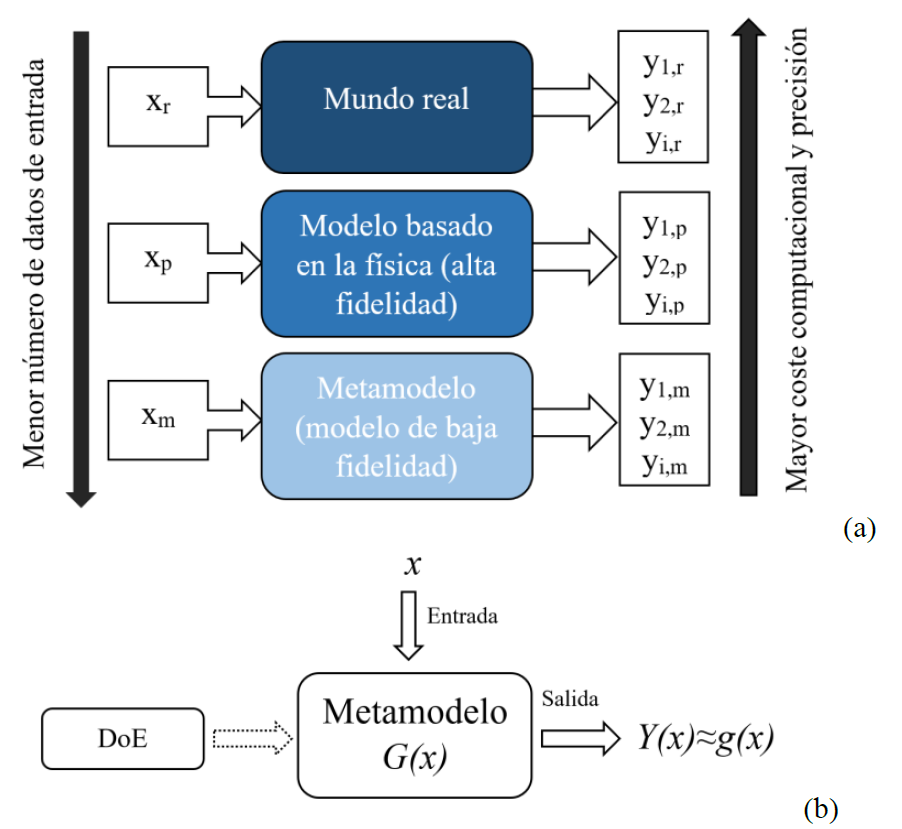

El proyecto estructural normalmente se basa en la experiencia del proyectista. En ocasiones, dicha experiencia se plasma en fórmulas de predimensionamiento que, si bien ofrecen buenos resultados, en ocasiones arrastran ineficiencias cuando se comparan con técnicas actuales de optimización que tenga en cuenta las dimensiones económicas y ambientales. En este artículo se comparan reglas de dimensionamiento previo de estructuras basadas en la experiencia con técnicas de optimización. Se aplica al caso del proyecto de tableros de puentes tipo losa pretensados aligerados. El resultado de la investigación resalta la importancia de aplicar métodos basados en la optimización heurística y en metamodelos para actualizar la experiencia de los proyectistas y proponer nuevas fórmulas de predimensionamiento más ajustadas a la optimización económica y ambiental. Además, en el trabajo se ofrecen nomogramas de predimensionamiento, con el mínimo número de datos posible, que pueden ser de utilidad al proyectista en sus diseños previos.

Os paso el vídeo de presentación del congreso.