Los desastres naturales y humanos ocasionan pérdidas humanas y económicas considerables. Las estructuras dañadas deben diseñarse para recuperar su funcionalidad lo antes posible, lo que implica recursos y emisiones significativas. Por tanto, el diseño y la construcción de estructuras deben enfocarse en la sostenibilidad, la durabilidad, la resistencia múltiple, la resiliencia y la monitorización inteligente del ciclo de vida. Los eventos extremos, junto con errores de diseño, construcción y falta de mantenimiento, suelen provocar daños estructurales locales que pueden desencadenar el colapso progresivo de las infraestructuras. RESILIFE afronta el reto social que suponen el mantenimiento y la reparación de estructuras frente a situaciones extremas, mediante la optimización de los problemas complejos planteados en el ámbito de las decisiones públicas y privadas. La hipótesis de partida es que un diseño óptimo y la construcción con estructuras híbridas basadas en los modernos métodos de construcción, en especial las modulares, son efectivos desde el punto de vista social y ambiental, y resilientes ante eventos extremos. El reto será incorporar mejoras en el diseño para afrontar eventos extremos y equiparar estas estructuras en prestaciones y en seguridad a las estructuras tradicionales. La innovación central consiste en plantear procedimientos explícitos para cuantificar la resiliencia de las estructuras en el contexto de múltiples amenazas y comparar las estructuras y los sistemas en términos de resiliencia. Para ello, se aplicarán técnicas de inteligencia artificial para optimizar la resiliencia, lo que demostrará su eficacia en términos sociales y ambientales frente a eventos extremos. La novedad metodológica radica en la utilización de metaheurísticas híbridas emergentes y Deep Learning en la optimización multiobjetivo, así como de la teoría de juegos, con el fin de lograr la pronta recuperación de su funcionalidad con costes sociales y ambientales reducidos, evitando su colapso progresivo. Además, se pretende profundizar en las técnicas de decisión multicriterio emergentes, como la lógica neutrosófica y otras, como las redes bayesianas. Esto no solo mejora la calidad y la velocidad de cálculo en el diseño, el mantenimiento y la reparación de estructuras, sino que también aborda las incertidumbres del mundo real y propone una optimización resiliente basada en la fiabilidad y en diseños robustos. En este contexto, en el mundo real existen incertidumbres, imperfecciones o desviaciones respecto a los parámetros utilizados en los códigos. Una estructura óptima se encuentra cercana a la región de infactibilidad, por lo que es necesario incorporar las incertidumbres para proporcionar diseños más robustos y fiables. Por otra parte, la fuerte limitación presupuestaria presente en momentos de crisis compromete seriamente las políticas de creación y conservación de las infraestructuras, sobre todo si hay incrementos de costes al introducir la resiliencia en el diseño. Los resultados esperados, tras un análisis de sensibilidad de distintas políticas presupuestarias asociadas a un horizonte temporal, pretenden detallar qué tipologías, actuaciones concretas de reparación y conservación, y alternativas de demolición y reutilización son adecuadas para minimizar los impactos ambientales y sociales considerando la variabilidad.

Los desastres naturales y humanos ocasionan pérdidas humanas y económicas considerables. Las estructuras dañadas deben diseñarse para recuperar su funcionalidad lo antes posible, lo que implica recursos y emisiones significativas. Por tanto, el diseño y la construcción de estructuras deben enfocarse en la sostenibilidad, la durabilidad, la resistencia múltiple, la resiliencia y la monitorización inteligente del ciclo de vida. Los eventos extremos, junto con errores de diseño, construcción y falta de mantenimiento, suelen provocar daños estructurales locales que pueden desencadenar el colapso progresivo de las infraestructuras. RESILIFE afronta el reto social que suponen el mantenimiento y la reparación de estructuras frente a situaciones extremas, mediante la optimización de los problemas complejos planteados en el ámbito de las decisiones públicas y privadas. La hipótesis de partida es que un diseño óptimo y la construcción con estructuras híbridas basadas en los modernos métodos de construcción, en especial las modulares, son efectivos desde el punto de vista social y ambiental, y resilientes ante eventos extremos. El reto será incorporar mejoras en el diseño para afrontar eventos extremos y equiparar estas estructuras en prestaciones y en seguridad a las estructuras tradicionales. La innovación central consiste en plantear procedimientos explícitos para cuantificar la resiliencia de las estructuras en el contexto de múltiples amenazas y comparar las estructuras y los sistemas en términos de resiliencia. Para ello, se aplicarán técnicas de inteligencia artificial para optimizar la resiliencia, lo que demostrará su eficacia en términos sociales y ambientales frente a eventos extremos. La novedad metodológica radica en la utilización de metaheurísticas híbridas emergentes y Deep Learning en la optimización multiobjetivo, así como de la teoría de juegos, con el fin de lograr la pronta recuperación de su funcionalidad con costes sociales y ambientales reducidos, evitando su colapso progresivo. Además, se pretende profundizar en las técnicas de decisión multicriterio emergentes, como la lógica neutrosófica y otras, como las redes bayesianas. Esto no solo mejora la calidad y la velocidad de cálculo en el diseño, el mantenimiento y la reparación de estructuras, sino que también aborda las incertidumbres del mundo real y propone una optimización resiliente basada en la fiabilidad y en diseños robustos. En este contexto, en el mundo real existen incertidumbres, imperfecciones o desviaciones respecto a los parámetros utilizados en los códigos. Una estructura óptima se encuentra cercana a la región de infactibilidad, por lo que es necesario incorporar las incertidumbres para proporcionar diseños más robustos y fiables. Por otra parte, la fuerte limitación presupuestaria presente en momentos de crisis compromete seriamente las políticas de creación y conservación de las infraestructuras, sobre todo si hay incrementos de costes al introducir la resiliencia en el diseño. Los resultados esperados, tras un análisis de sensibilidad de distintas políticas presupuestarias asociadas a un horizonte temporal, pretenden detallar qué tipologías, actuaciones concretas de reparación y conservación, y alternativas de demolición y reutilización son adecuadas para minimizar los impactos ambientales y sociales considerando la variabilidad.

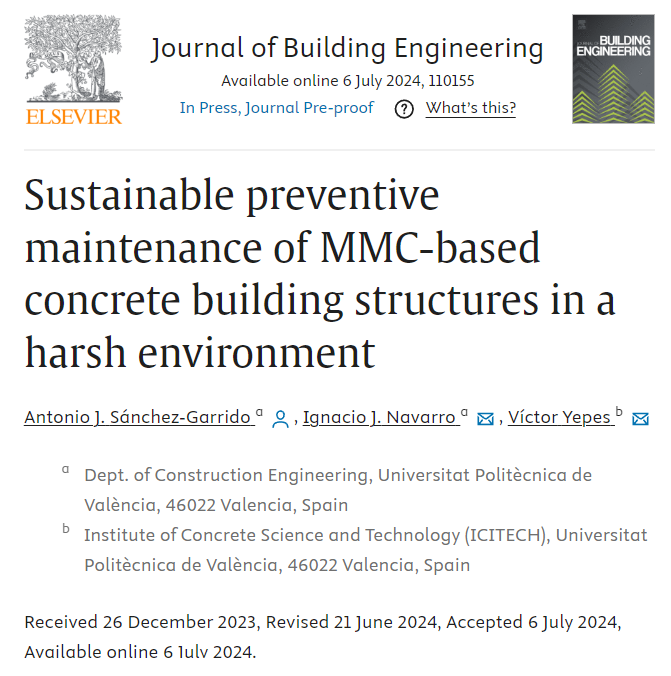

Natural and human disasters cause considerable human and economic losses. Damaged structures must be designed to recover their functionality quickly, which involves significant resources and emissions. Therefore, the design and construction of structures must focus on sustainability, durability, multiple resistance, resilience, and intelligent life-cycle monitoring. Extreme events, design, construction, and lack of maintenance errors often cause local structural damage that can trigger the progressive collapse of infrastructures. RESILIFE addresses the social challenge of maintaining and repairing structures in extreme situations by optimizing the complex problems posed at the level of public and private decisions. The starting hypothesis is that optimal design and construction with hybrid structures based on modern construction methods, especially modular ones, are socially and environmentally effective and resilient to extreme events. The challenge will be to incorporate design improvements to cope with extreme events and to bring these structures on par with traditional structures regarding performance and safety. The central innovation is to develop explicit procedures to quantify the resilience of structures in the context of multiple hazards and to compare structures and systems in terms of resilience. To this end, artificial intelligence techniques will be applied to optimize resilience, demonstrating its effectiveness in social and environmental terms in the face of extreme events. The methodological novelty lies in using emerging hybrid metaheuristics and Deep Learning in multi-objective optimization and game theory to achieve early recovery of its functionality with reduced social and environmental costs, avoiding its progressive collapse. In addition, it is intended to deepen emerging multi-criteria decision techniques, such as neutrosophic logic, and others, such as Bayesian networks. This not only improves the quality and speed of computation in the design, maintenance, and repair of structures but also addresses real-world uncertainties and proposes resilient optimization based on reliability and robust designs. In this context, uncertainties, imperfections, or deviations from the parameters used in the codes exist in the real world. An optimal structure is close to the infeasibility region, so it is necessary to incorporate the uncertainties to provide more robust and reliable designs. On the other hand, the strong budget constraints present in times of crisis seriously compromise infrastructure creation and maintenance policies, especially if there are cost increases when introducing resilience in the design. After a sensitivity analysis of different budgetary policies associated with a time horizon, the expected results aim to detail which typologies, specific repair and conservation actions, and demolition and reuse alternatives are adequate to minimize environmental and social impacts considering variability.

PROYECTO DE INVESTIGACIÓN:

Optimización resiliente del ciclo de vida de estructuras híbridas y modulares de alta eficiencia social y medioambiental bajo condiciones extremas. (RESILIFE). [Resilient life-cycle optimization of socially and environmentally efficient hybrid and modular structures under extreme conditions]. PID2023-150003OB-I00. Investigadores principales: Víctor Yepes y Julián Alcalá.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.