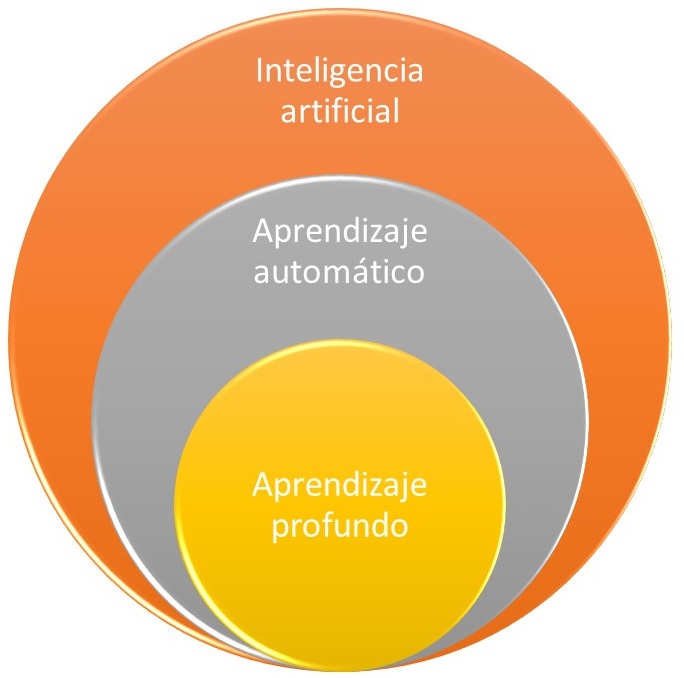

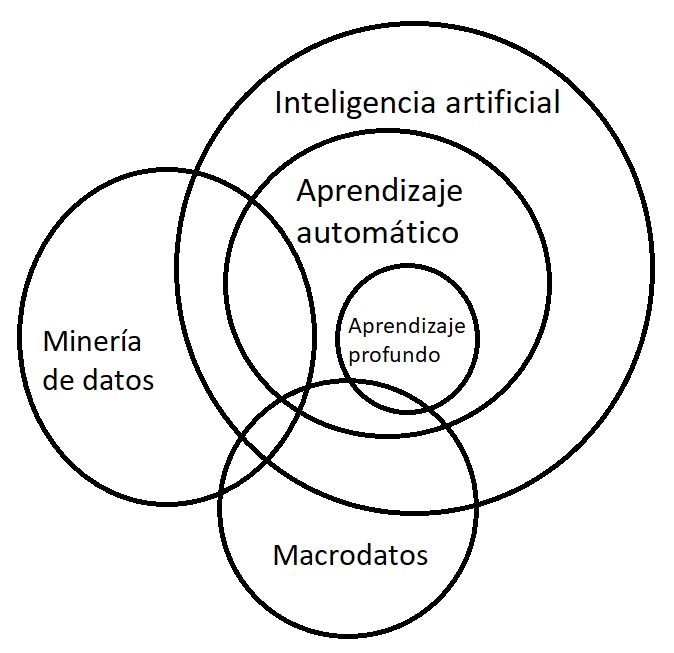

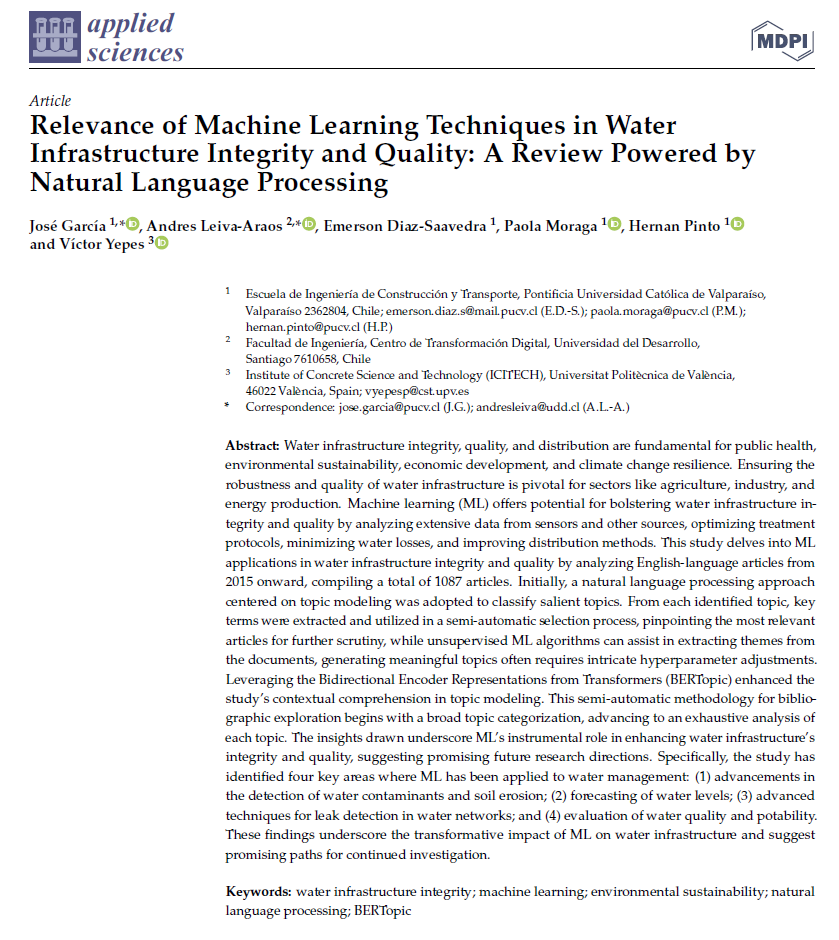

Acabamos de recibir la noticia de la publicación de nuestro artículo en la revista Applied Sciences, la cual está indexada en el JCR. Este estudio explora las diversas aplicaciones del aprendizaje automático (Machine Learning, ML) en relación con la integridad y calidad de las infraestructuras hidráulicas, identificando cuatro áreas clave donde se ha implementado con éxito. Estas áreas abarcan desde la detección de contaminantes en el agua y la erosión del suelo, hasta la predicción de niveles hídricos, la identificación de fugas en redes de agua y la evaluación de la calidad y potabilidad del agua.

Acabamos de recibir la noticia de la publicación de nuestro artículo en la revista Applied Sciences, la cual está indexada en el JCR. Este estudio explora las diversas aplicaciones del aprendizaje automático (Machine Learning, ML) en relación con la integridad y calidad de las infraestructuras hidráulicas, identificando cuatro áreas clave donde se ha implementado con éxito. Estas áreas abarcan desde la detección de contaminantes en el agua y la erosión del suelo, hasta la predicción de niveles hídricos, la identificación de fugas en redes de agua y la evaluación de la calidad y potabilidad del agua.

Cabe destacar que esta investigación se llevó a cabo en el marco de una colaboración fructífera entre nuestro grupo de investigación e investigadores chilenos, liderados por el profesor José Antonio García Conejeros. El proyecto en sí, denominado HYDELIFE, forma parte de las iniciativas que superviso como investigador principal en la Universitat Politècnica de València.

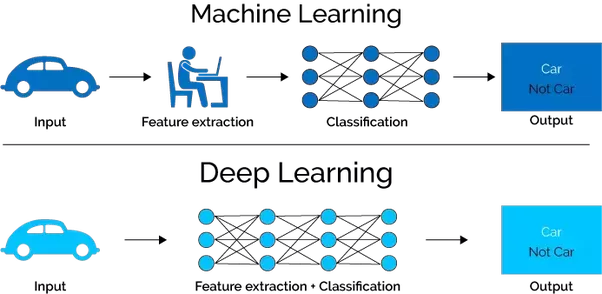

Se realizó un análisis bibliográfico de artículos científicos a partir de 2015, que arrojó un total de 1087 artículos, para explorar las aplicaciones de las técnicas de aprendizaje automático en la integridad y la calidad de la infraestructura hídrica. Entre las contribuciones realizadas por el trabajo, caben destacar las siguientes:

- Se identificaron cuatro áreas clave en las que el aprendizaje automático se ha aplicado a la gestión del agua: los avances en la detección de contaminantes del agua y la erosión del suelo, la previsión de los niveles del agua, las técnicas avanzadas para la detección de fugas en las redes de agua y la evaluación de la calidad y potabilidad del agua.

- Destacó el potencial de las técnicas de aprendizaje automático (Random Forest, Support Vector Regresion, Convolutional Neural Networks y Gradient Boosting) combinadas con sistemas de monitoreo de vanguardia en múltiples aspectos de la infraestructura y la calidad del agua.

- Proporcionó información sobre el impacto transformador del aprendizaje automático en la infraestructura hídrica y sugirió caminos prometedores para continuar con la investigación.

- Empleó un enfoque semiautomático para realizar análisis bibliográficos, aprovechando las representaciones codificadas bidireccionales de Transformers (BERTopic), para abordar las limitaciones y garantizar una representación precisa de los documentos.

- Las técnicas de aprendizaje automático ofrecen una alta precisión, un tiempo de procesamiento reducido y datos valiosos para la toma de decisiones en materia de gestión sostenible de los recursos y sistemas de alerta temprana.

- La colaboración interdisciplinaria, los marcos integrados y las tecnologías avanzadas, como la teledetección y la IoT, son esenciales para avanzar en la investigación sobre la integridad y la calidad de la infraestructura hídrica.

Abstract:

Water infrastructure integrity, quality, and distribution are fundamental for public health, environmental sustainability, economic development, and climate change resilience. Ensuring the robustness and quality of water infrastructure is pivotal for sectors like agriculture, industry, and energy production. Machine learning (ML) offers the potential for bolstering water infrastructure integrity and quality by analyzing extensive data from sensors and other sources, optimizing treatment protocols, minimizing water losses, and improving distribution methods. This study delves into ML applications in water infrastructure integrity and quality by analyzing English-language articles from 2015 onward, compiling 1087 articles. A natural language processing approach centered on topic modeling was initially adopted to classify salient topics. From each identified topic, key terms were extracted and utilized in a semi-automatic selection process, pinpointing the most relevant articles for further scrutiny. At the same time, unsupervised ML algorithms can assist in extracting themes from the documents, generating meaningful topics often requires intricate hyperparameter adjustments. Leveraging the Bidirectional Encoder Representations from Transformers (BERTopic) enhanced the study’s contextual comprehension in topic modeling. This semi-automatic methodology for bibliographic exploration begins with broad categorizing topics, advancing to an exhaustive analysis. The insights drawn underscore ML’s instrumental role in enhancing water infrastructure’s integrity and quality, suggesting promising future research directions. Specifically, the study has identified four key areas where ML has been applied to water management: (1) advancements in the detection of water contaminants and soil erosion; (2) forecasting of water levels; (3) advanced techniques for leak detection in water networks; and (4) evaluation of water quality and potability. These findings underscore the transformative impact of ML on water infrastructure and suggest promising paths for continued investigation.

Keywords:

Water infrastructure integrity; machine learning; environmental sustainability; natural language processing; BERTopic

Reference:

GARCÍA, J.; LEIVA-ARAOS, A.; DÍAZ-SAAVEDRA, E.; MORAGA, P.; PINTO, H.; YEPES, V. (2023). Relevance of Machine Learning Techniques in Water Infrastructure Integrity and Quality: A Review Powered by Natural Language Processing. Applied Sciences, 13(22):12497. DOI:10.3390/app132212497