Una noticia aparecida el 9 de diciembre de 2018 en El País con el siguiente titular “Fomento admite que hay 66 puentes con graves problemas de seguridad” abrió cierta inquietud en la opinión pública sobre la seguridad de nuestros puentes. Esta inquietud irrumpió en agosto de ese mismo año con el derrumbe de un puente en Génova (Italia). Pero los ejemplos no quedan aquí. Podríamos hablar de la sustitución de los cables del puente Fernando Reig, en Alcoy, o del Puente del Centenario, en Sevilla. O del derribo del puente Joaquín Costa, en Madrid. Ejemplos tenemos en todo el mundo. En cualquier caso, estamos hablando de cifras millonarias, de cortes de tráfico, pérdidas humanas, por poner algunas consecuencias sobre la mesa.

Los puentes son componentes críticos de las infraestructuras, pues su correcto funcionamiento es básico para la resiliencia de nuestros entornos urbanos. Sin embargo, un gran número de infraestructuras que están llegando al final de su vida útil al mismo tiempo. De hecho, la vida útil de muchos puentes se espera que sea menor a la proyectada debido al continuo deterioro provocado por el incremento del tráfico y de los impactos ambientales. Esto constituye una auténtica bomba de relojería (Thurlby, 2013), que junto al reto de la reducción de los impactos ambientales, son razones más que suficientes para preocuparnos de mejorar el mantenimiento de nuestros puentes. De hecho, ya hemos comentado en un artículo anterior un concepto totalmente relacionado con éste: la «crisis de las infraestructuras«. Yo me atrevería a afirmar algo que puede parecer muy duro: el derrumbe de nuestra civilización será paralelo al de las infraestructuras que les da soporte.

Hoy día los gestores de las infraestructuras tienen ante sí un reto importante consistente en mantenerlas en un estado aceptable con presupuestos muy limitados. De hecho, la inspección de los puentes, su mantenimiento y reparación constituyen tareas rutinarias necesarias para mantener dichas infraestructuras en buenas condiciones (Tong et al., 2019). Sin embargo, el problema pasa a ser grave cuando una parte significativa del parque de infraestructuras se encuentra cercano al final de su vida útil. Y lo que aún es peor, cuando existen riesgos de alto impacto y de baja probabilidad que pueden afectar gravemente a las infraestructuras. Resolver este problema es complicado, pues no se presta fácilmente a la exploración con los instrumentos analíticos y de previsión tradicionales.

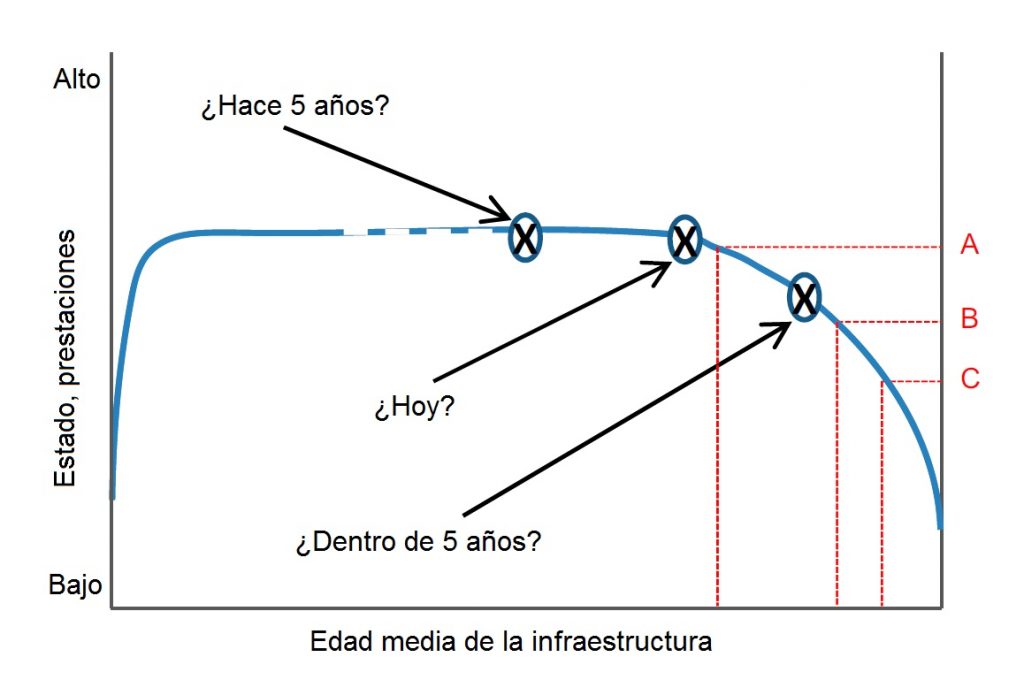

El estado o deterioro de una infraestructura sigue un comportamiento similar, pero invertido, de la llamada «curva de la bañera«, que es una gráfica que representa los fallos durante el periodo de vida útil de un sistema o de una máquina. En este caso, según vemos en la Figura 2, el estado de condición o las prestaciones de la infraestructura permanece alto durante un periodo de tiempo hasta que empieza a decaer. Para los gestores es necesario conocer el comportamiento de las infraestructuras para tomar decisiones. Sin embargo, muchas veces desconocen en qué posición de la curva se encuentran y, lo que es peor, a qué ritmo se va a deteriorar. Por ejemplo, en la Figura 2 podemos ver que la caída en las prestaciones de A a B, o de B a C son similares, pero la velocidad de deterioro es muy diferente. Y lo que es peor de todo, llega un momento que la caída en las prestaciones ocurre de forma muy acelerada, sin capacidad de reacción por parte de los gestores. Por eso se ha utilizado el símil de la «bomba de relojería».

La gestión y el mantenimiento de los puentes está empezando a ser un problema de una magnitud que está empezando a ser más que preocupante. Algunos datos son un ejemplo de ello: en el año 2019, 47000 puentes de los puentes en Estados Unidos, (más del 20% del total) presentan deficiencias estructurales (American Road & Transportation Builders Association, 2019); en Reino Unido, más de 3000 puentes estaban por debajo de los estándares y requerían reparación (RAC Foundation, 2019). Estos son buenos argumentos para aumentar la vida útil de los puentes.

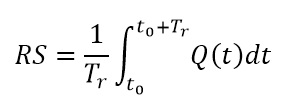

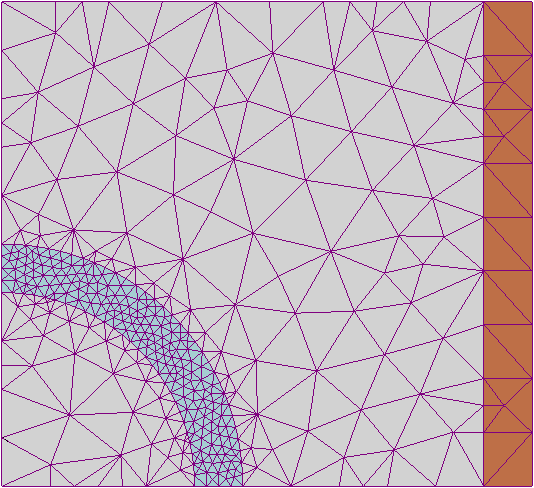

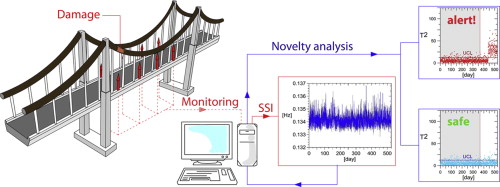

Una de las tecnologías para mejorar la gestión y el mantenimiento de los puentes es la vigilancia de su estado estructural (structural health monitoring, SHM), que trata de mejorar el comportamiento de la estructura mediante el aprendizaje de los datos obtenidos durante su vida útil mediante su monitorización (Figura 3). Estos datos sirven para actualizar los modelos y comprobar el estado en que se encuentra la estructura, lo cual permite minimizar la incertidumbre de los parámetros empleados en los modelos. Sin embargo, aún no se ha resuelto completamente el paso de la obtención de los datos del puente en tiempo real a la toma de decisiones en la gestión y mantenimiento de los puentes.

En un artículo anterior se explicó el concepto de gemelos digitales (digital twins). Estos modelos actualizados constantemente mediante la monitorización del puente, permitirían conocer en tiempo real el estado estructural del puente y también predecir su comportamiento en el caso de que ocurrieran determinadas circunstancias. Esta información sería clave a la hora de tomar decisiones en la gestión y el mantenimiento del puente.

Las preguntas clave que deberíamos responder serían las siguientes: ¿Es el puente seguro?, ¿cuánto tiempo será el puente seguro?, ¿cuál es el comportamiento estructural actual del puente?, ¿cuándo y cómo deberemos intervenir en el puente?

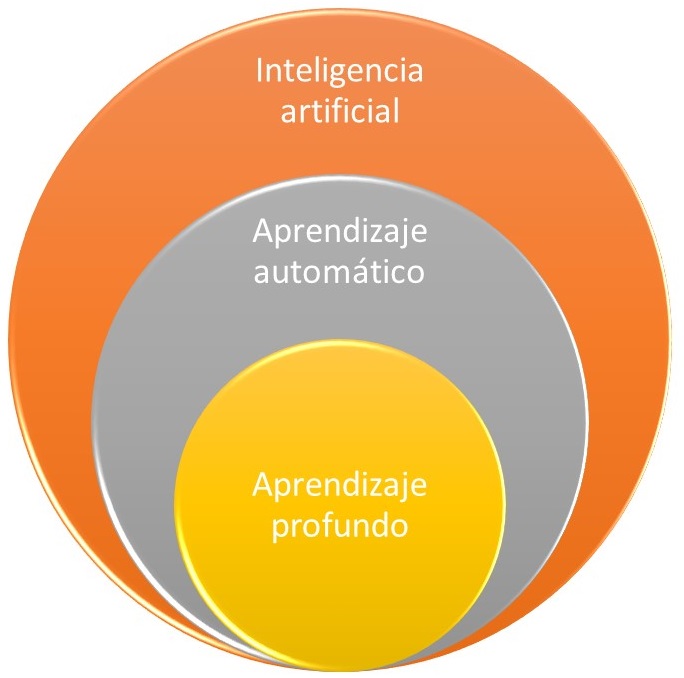

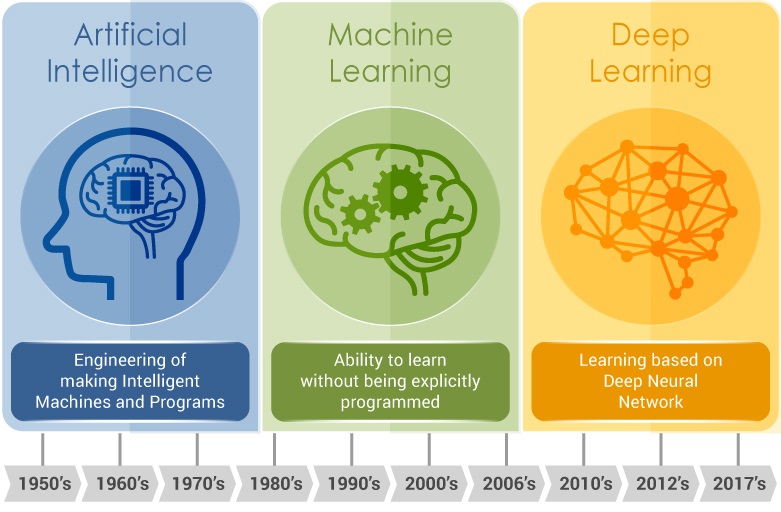

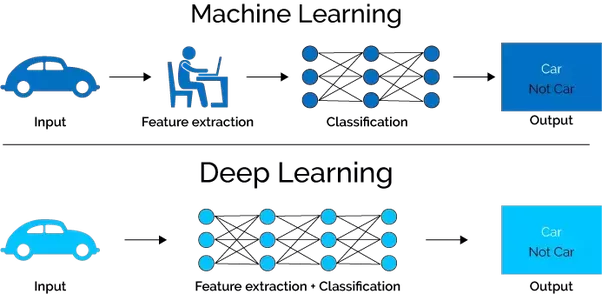

La respuesta a estas preguntas no es tan evidente como pudiera parecer a simple vista. Los gestores de las infraestructuras deberían ser capaces de entender y valorar en su justa medida los resultados estructurales de los modelos cuyos datos se actualizan en tiempo real. La dificultad estriba en conocer no solo los datos, sino las causas subyacentes a los cambios en el comportamiento estructural. Una ayuda son las técnicas procedentes de la inteligencia artificial, como el aprendizaje profundo, que permiten interpretar ingentes cantidades de datos e identificar patrones y correlaciones entre dichos datos. En un artículo anterior hablamos de este tema. Por otra parte, la actualización de los datos procedentes de la vigilancia de los puentes debería ser automática y en tiempo real. Aquí vuelve a cobrar importancia la inteligencia artificial, aunque nunca debería suplantar el conocimiento ingenieril que permite interpretar los resultados proporcionados por los algoritmos.

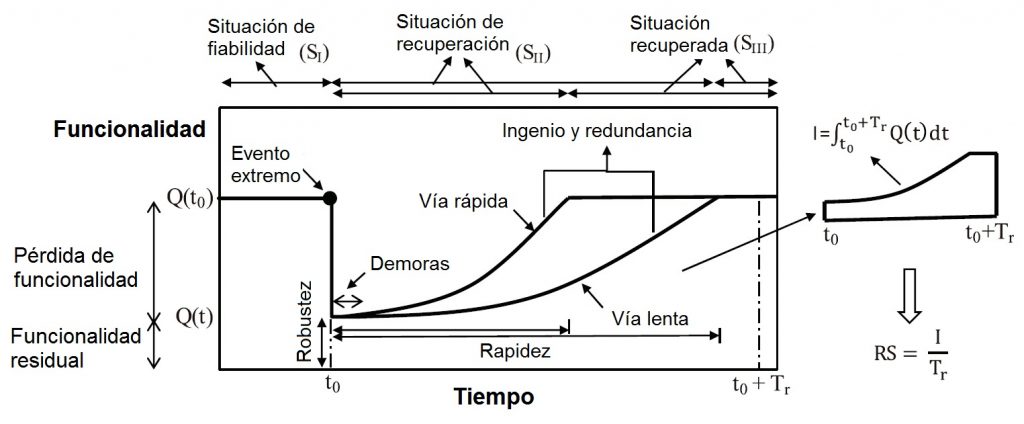

Por otra parte, la modelización del riesgo y la resiliencia es una labor necesaria para entender la vulnerabilidad de las infraestructuras. De esta forma seríamos capaces de desarrollar estrategias de mitigación, que podrían ser complementarias a las estrategias de gestión del deterioro que se han explicado anteriormente.

Por tanto, existe un auténtico salto entre la investigación dedicada a la monitorización en tiempo real de los puentes y la toma de decisiones para su gestión y mantenimiento. Los gemelos digitales apoyados en los actuales desarrollos tecnológicos como el «Internet de las cosas«, deberían permitir el paso de la investigación y el desarrollo a la innovación directamente aplicable a la realidad de la gestión de las infraestructuras.

Referencias:

AMERICAN ROAD & TRANSPORTATION BUILDERS ASSOCIATION (2019). 2019 Bridge Report. https://artbabridgereport.org/

RAC Foundation. (2019). Bridge maintenance table – GB local authorities. https://www.racfoundation.org/media-centre/bridge-maintenance-backlog-grows

THURLBY, R. (2013). Managing the asset time bomb: a system dynamics approach. Proceedings of the Institution of Civil Engineers – Forensic Engineering, 166(3):134-142.

TONG, X.; YANG, H.; WANG, L.; MIAO, Y. (2019). The development and field evaluation of an IoT system of low-power vibration for bridge health monitoring, Sensors 19(5):1222.

YEPES, V. (2020). Computación cuántica y gemelos híbridos digitales en ingeniería civil y edificación. https://victoryepes.blogs.upv.es/2019/10/30/computacion-cuantica-gemelos-digitales/

YEPES, V. (2020). La inteligencia artificial en la ingeniería civil. https://victoryepes.blogs.upv.es/2020/09/08/la-inteligencia-artificial-en-la-ingenieria-civil/

YEPES, V. (2020). El aprendizaje profundo (deep learning) en la optimización de estructuras. https://victoryepes.blogs.upv.es/2020/09/15/el-aprendizaje-profundo-deep-learning-en-la-optimizacion-de-estructuras/

YEPES, V. (2020). La resiliencia de las infraestructuras. https://victoryepes.blogs.upv.es/2020/09/17/la-resiliencia-de-las-infraestructuras/

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.