Como suele ser habitual, nuestro grupo de investigación suele presentar algunos de sus trabajos en la Conferencia Internacional sobre Modelos Mecánicos en Ingeniería Estructural. Estamos ya en la sexta edición, la CMMoST 2021, que se va a desarrollar del 1 al 3 de diciembre de 2021 en Valladolid (España). Se trata de un congreso bianual que, como bien indica su blog de presentación, es una excelente oportunidad para presentar a nivel internacional vuestros proyectos y compartir experiencias en el campo de los modelos mecánicos en la ingeniería estructural. CMMoST 2021 va dirigido tanto a investigadores como a profesionales dedicados al desarrollo y aplicación de modelos mecánicos en la ingeniería estructural. De este modo, ingenieros, arquitectos y otros expertos y profesionales relacionados con los modelos estructurales tienen cabida en este congreso internacional.

Como suele ser habitual, nuestro grupo de investigación suele presentar algunos de sus trabajos en la Conferencia Internacional sobre Modelos Mecánicos en Ingeniería Estructural. Estamos ya en la sexta edición, la CMMoST 2021, que se va a desarrollar del 1 al 3 de diciembre de 2021 en Valladolid (España). Se trata de un congreso bianual que, como bien indica su blog de presentación, es una excelente oportunidad para presentar a nivel internacional vuestros proyectos y compartir experiencias en el campo de los modelos mecánicos en la ingeniería estructural. CMMoST 2021 va dirigido tanto a investigadores como a profesionales dedicados al desarrollo y aplicación de modelos mecánicos en la ingeniería estructural. De este modo, ingenieros, arquitectos y otros expertos y profesionales relacionados con los modelos estructurales tienen cabida en este congreso internacional.

En esta ocasión, nos presentamos con dos comunicaciones que son parte de la investigación realizada en sendas tesis doctorales en marcha. A continuación os paso el resumen de los dos trabajos. Más adelante os pasaré las comunicaciones completas.

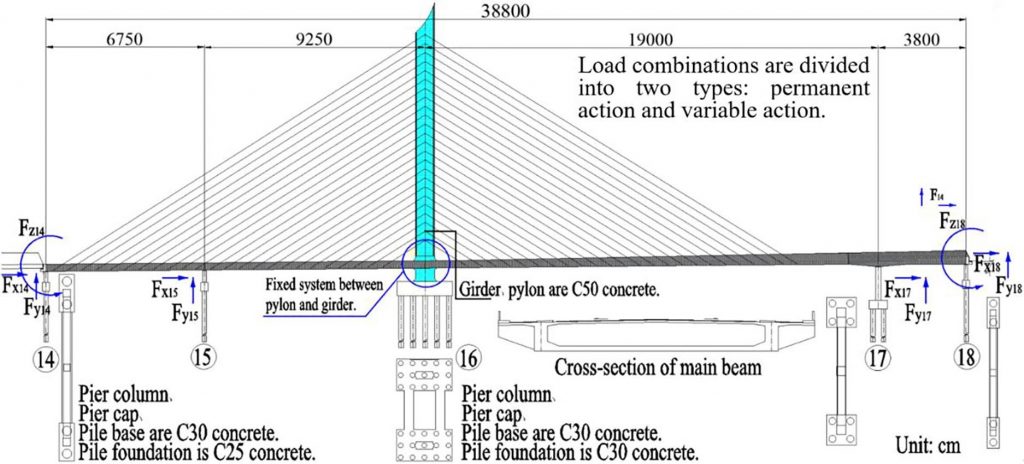

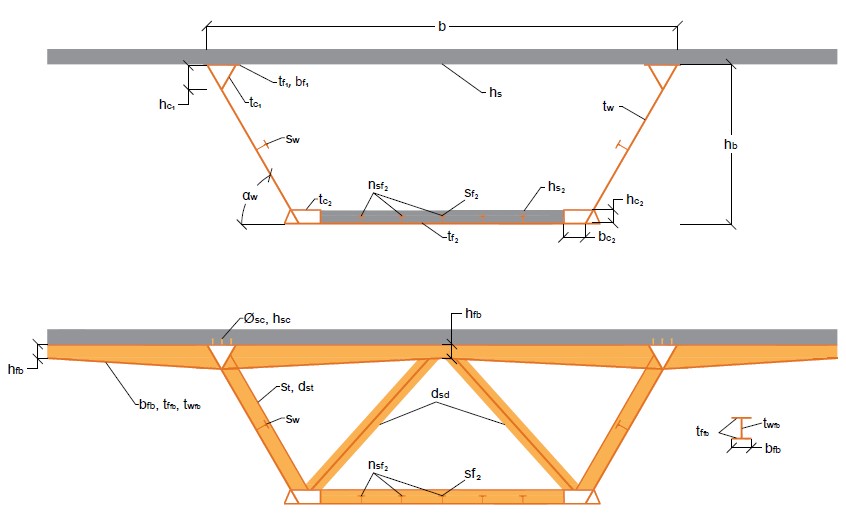

MARTÍNEZ-MUÑOZ, D.; SÁNCHEZ-GARRIDO, A.J.; MARTÍ, J.V.; YEPES, V. (2021). Composite bridge deck optimization with trajectory-based algorithms. 6th International Conference on Mechanical Models in Structural Engineering, CMMoST 2021, 1-3 December, Valladolid, Spain.

MARTÍNEZ-MUÑOZ, D.; SÁNCHEZ-GARRIDO, A.J.; MARTÍ, J.V.; YEPES, V. (2021). Composite bridge deck optimization with trajectory-based algorithms. 6th International Conference on Mechanical Models in Structural Engineering, CMMoST 2021, 1-3 December, Valladolid, Spain.

ABSTRACT

Bridge optimization can be difficult due to the large number of variables involved in the problem. In this work, the optimization of a steel‐concrete composite box girder bridge has been performed considering cost as objective function. To achieve this objective, Simulated Annealing (SA) has been applied as an example of trajectory‐based algorithm for the optimization of the structure. It is observed that the addition of cells to the bridge cross sections improves not only the section behavior but also the optimization results. Finally, it is observed that the proposed double composite‐action design materializing slabs on the bottom flange on supports, allows eliminating the continuous longitudinal stiffeners. This method automatize the optimization process of an initial design of a composite bridge, which has traditionally been based on the technician’s own experience, allowing to reach results in a more efficient way.

Keywords: Optimization, Structures, Composite bridges, Metaheuristics, Trajectory‐based algorithms.

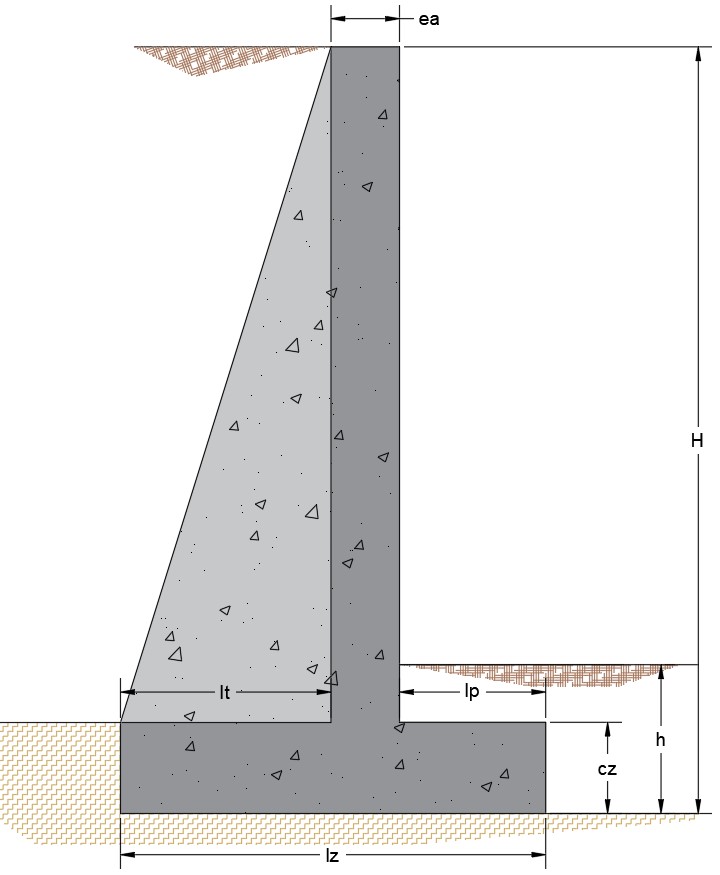

SÁNCHEZ-GARRIDO, A.J.; MARTÍNEZ-MUÑOZ, D.; NAVARRO, I.J.; YEPES, V. (2021). Neutrosophic logic applied to the multi-criteria evaluation of sustainable alternatives for earth-retaining walls. 6th International Conference on Mechanical Models in Structural Engineering, CMMoST 2021, 1-3 December, Valladolid, Spain.

SÁNCHEZ-GARRIDO, A.J.; MARTÍNEZ-MUÑOZ, D.; NAVARRO, I.J.; YEPES, V. (2021). Neutrosophic logic applied to the multi-criteria evaluation of sustainable alternatives for earth-retaining walls. 6th International Conference on Mechanical Models in Structural Engineering, CMMoST 2021, 1-3 December, Valladolid, Spain.

ABSTRACT

The sustainable design of infrastructures is one of the key aspects for the achievement of the Sustainable Development Goals, given the recognized magnitude of both the economic and environmental impacts of the construction sector. Multi-criteria decision methodologies allow addressing the sustainable design of infrastructures, simultaneously considering the impact of a design on the different dimensions of sustainability. This article proposes the use of neutrosophic logic to solve one of the main problems associated with decision making: the subjectivity of the experts involved. Through the neutrosophic approach of the AHP multi-criteria methodology and the use of the VIKOR technique, the economic and environmental impacts associated with four earth retaining wall designs are analyzed. In the present assessment, the most sustainable response over its life cycle has been found to be the gabion wall.

Keywords: Sustainability, Retaining walls, Neutrosophic logic, AHP, Multi-criteria decision making.