Acaban de publicarnos un artículo en Sustainability, revista indexada en el JCR. Se trata de valorar distintas alternativas de puentes de hormigón o mixtos desde el punto de vista de la sostenibilidad social. El trabajo se enmarca dentro del proyecto de investigación HYDELIFE que dirijo como investigador principal en la Universitat Politècnica de València.

Acaban de publicarnos un artículo en Sustainability, revista indexada en el JCR. Se trata de valorar distintas alternativas de puentes de hormigón o mixtos desde el punto de vista de la sostenibilidad social. El trabajo se enmarca dentro del proyecto de investigación HYDELIFE que dirijo como investigador principal en la Universitat Politècnica de València.

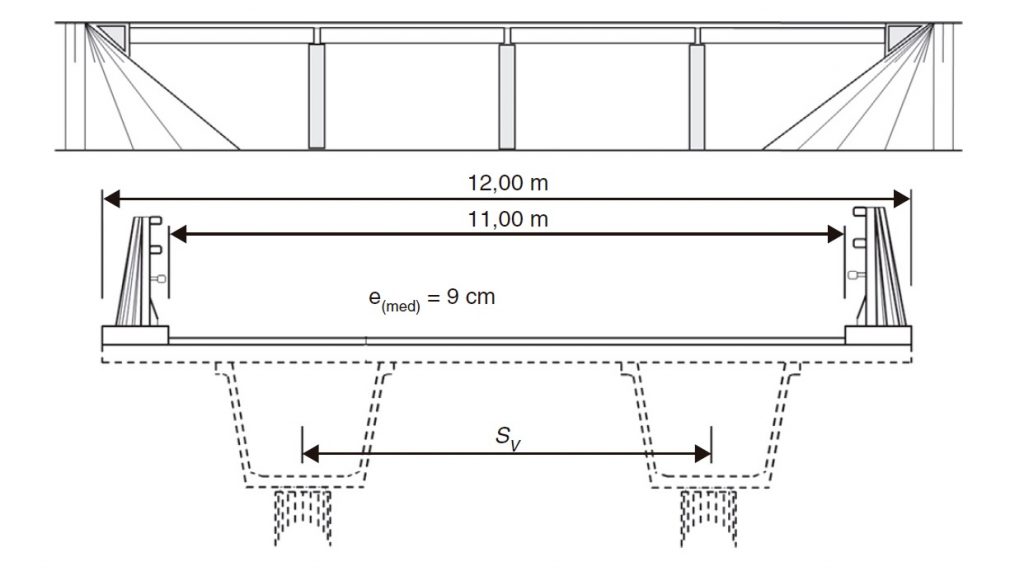

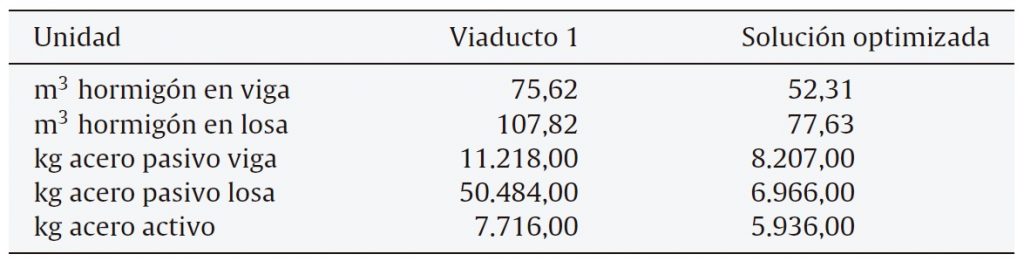

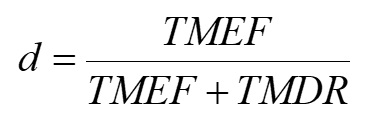

La definición de sostenibilidad incluye tres pilares fundamentales: económico, medioambiental y social. Los estudios sobre el impacto económico en las infraestructuras de ingeniería civil se han centrado en la reducción de costes. No está necesariamente en consonancia con la sostenibilidad económica, pues no se cosideran otros factores económicos. Además, la evaluación del pilar social se ha desarrollado poco en comparación con la económica y la medioambiental. Es esencial centrarse en la sostenibilidad social y evaluar indicadores claros que permitan a los investigadores comparar alternativas. Además, los estudios de evaluación del ciclo de vida de los puentes se han centrado hasta ahora en soluciones de hormigón. Esto ha dado lugar a una falta de análisis del impacto de las alternativas de puentes mixtos. Este estudio se realiza en dos fases. La primera parte evalúa la sostenibilidad social y medioambiental de «la cuna a la tumba» con las bases de datos SOCA v2 y ecoinvent v3.7.1. Esta evaluación se realiza sobre cuatro alternativas de puentes de hormigón y mixtos con luces entre 15 y 40 m. Para obtener los indicadores sociales y medioambientales se ha utilizado ReCiPe y el método de ponderación del impacto social. La segunda parte del estudio compara los resultados obtenidos de la evaluación social y medioambiental de las alternativas variando la tasa de reciclaje del acero. Las alternativas de puente son la losa maciza de hormigón pretensado, la losa aligerada de hormigón pretensado, el cajón-viga de hormigón pretensado y el cajón-viga mixto. Los resultados muestran que las opciones compuestas son las mejores en cuanto al impacto medioambiental, pero las soluciones de viga cajón de hormigón son mejores en cuanto al impacto social. Además, un aumento de la tasa de reciclaje del acero aumenta el impacto social y disminuye el medioambiental.

Abstract

The definition of sustainability includes three fundamental pillars: economic, environmental, and social. Studies of the economic impact on civil engineering infrastructures have been focused on cost reduction. It is not necessarily in line with economic sustainability due to the lack of other economic factors. Moreover, the social pillar assessment has been weakly developed compared to the economic and the environmental ones. It is essential to focus on the social pillar and evaluate clear indicators that allow researchers to compare alternatives. Furthermore, bridge life cycle assessment studies have been focused on concrete options. This has resulted in a lack of analysis of the impact of composite bridge alternatives. This study is conducted in two stages. The first part of the study makes a cradle-to-grave social and environmental sustainability evaluation with the SOCA v2 and ecoinvent v3.7.1 databases. This assessment is carried out on four concrete and composite bridge alternatives with span lengths between 15 and 40 m. The social impact weighting method and recipe have been used to obtain the social and environmental indicators. The second part of the study compares the results obtained from the social and environmental assessment of the concrete and the composite alternatives varying the steel recycling rate. The bridge alternatives are prestressed concrete solid slab, prestressed concrete lightened slab, prestressed concrete box-girder, and steel-concrete composite box-girder. The results show that composite options are the best for environmental impact, but the concrete box girder solutions are better for social impact. Furthermore, an increase in the steel recycling rate increases the social impact and decreases the environmental one.

Keywords

Sustainability; bridges; structures; LCA; ReCiPe; SOCA

Reference:

MARTÍNEZ-MUÑOZ, D.; MARTÍ, J.V.; YEPES, V. (2022). Social Impact Assessment Comparison of Composite and Concrete Bridge Alternatives. Sustainability, 14(9):5186. DOI:10.3390/su14095186.