Introducción: El sistema nervioso invisible de un edificio.

Introducción: El sistema nervioso invisible de un edificio.

Cualquiera que haya pasado junto a una obra habrá visto la escena: grúas que se elevan hacia el cielo, un esqueleto de armaduras de acero esperando el hormigón y un ir y venir constante de los trabajadores. Vemos el progreso físico, la estructura que crece día a día. Pero ¿te has parado a pensar en los procesos invisibles que garantizan que ese gigante de hormigón y acero no solo se mantenga en pie, sino que también sea seguro durante décadas?

Detrás de cada pilar, viga y forjado existe una meticulosa red de control, un sistema nervioso que garantiza la integridad de toda la estructura. En España, el manual que rige estas normas es el Código Estructural. Este reglamento garantiza que la calidad y la seguridad no se dejan al azar, sino que son el resultado de un plan riguroso y sistemático.

Este artículo revela tres aspectos sorprendentes extraídos directamente de los procedimientos de este código. Son tres verdades sobre el control de calidad que cambiarán tu forma de ver los edificios que te rodean y demostrarán que, al igual que un rascacielos, la confianza se construye paso a paso y con una supervisión implacable.

1. El control se realiza mediante dos llaves: el constructor se autovigila y un supervisor lo supervisa.

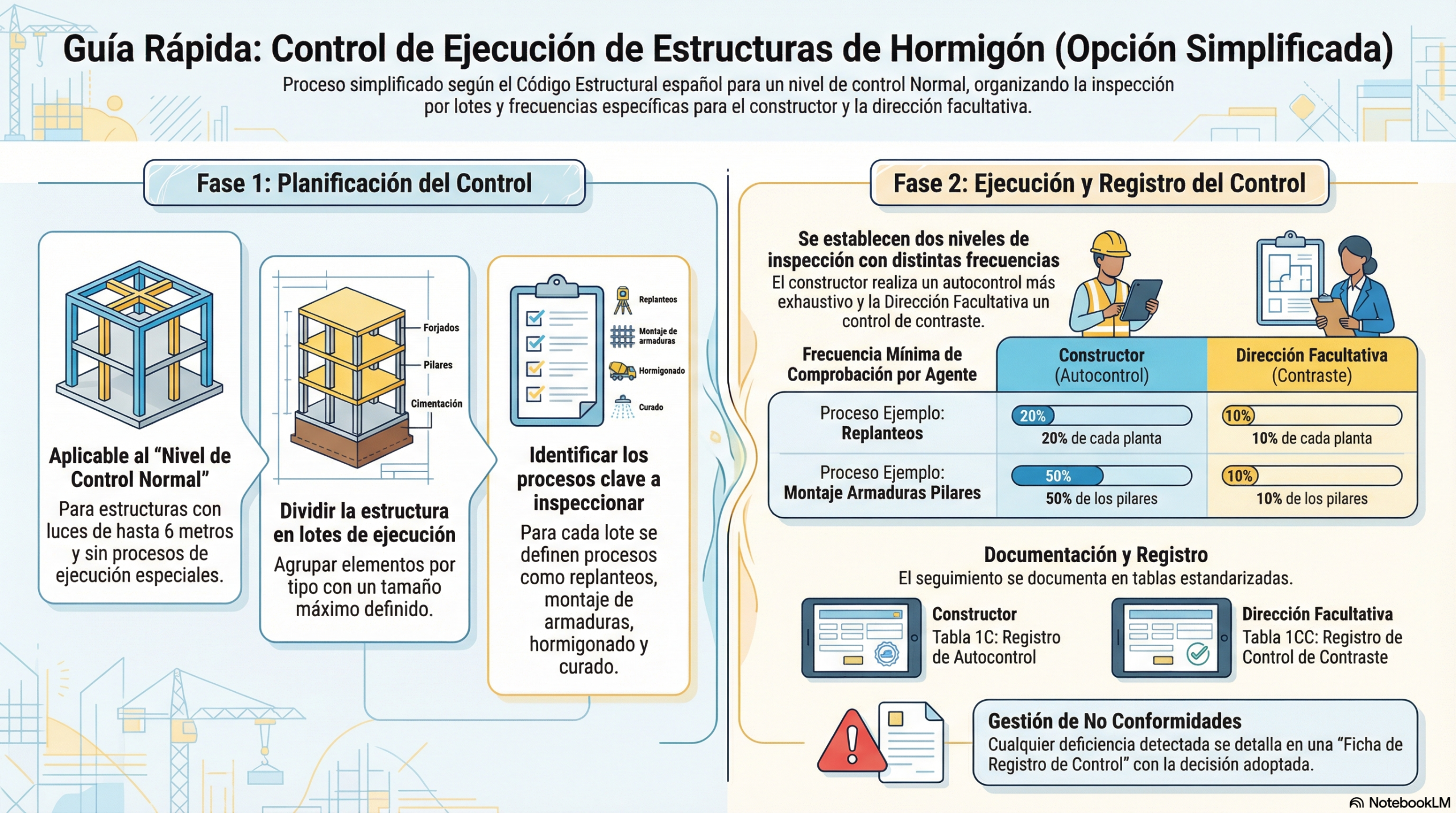

En la construcción de una estructura, la responsabilidad no recae en una sola persona, sino en un sistema de doble verificación. Piénsalo como un sistema de doble llave, en el que se requieren dos validaciones para proceder. El Código Estructural establece un mecanismo de control con dos capas fundamentales que garantizan la máxima fiabilidad.

La primera capa es el «autocontrol» del constructor. La propia empresa constructora tiene la obligación de inspeccionar y registrar de forma sistemática la calidad de su trabajo. No es una opción, sino una exigencia. Deben seguir un plan de inspección y dejar constancia de que cada proceso cumple con las especificaciones del proyecto.

La segunda capa es el «control de contraste», que realiza una entidad independiente: la dirección facultativa (el equipo técnico de arquitectos e ingenieros que dirige la obra y actúa como supervisor en nombre del propietario y de la normativa). Este equipo no da por bueno el trabajo del constructor sin más, sino que realiza sus propias comprobaciones para verificar que el autocontrol se ha llevado a cabo correctamente y que los resultados son conformes.

Para comprender la rigurosidad de este sistema, veamos las frecuencias mínimas de inspección de un elemento como el pilar. Según las tablas de inspección del código, el constructor debe comprobar el 50 % de los pilares de un lote, mientras que la dirección facultativa debe realizar un control de contraste del 10 % de dichos pilares. Esta redundancia no es burocracia, sino una red de seguridad diseñada para que nada importante pase desapercibido. Esta redundancia deliberada no solo sirve para detectar errores, sino que forma parte de una filosofía pragmática que reconoce que, en proyectos de esta complejidad, la perfección es imposible, pero garantizar la corrección es posible.

2. La perfección no existe, pero la corrección sí: los errores forman parte del plan.

Podríamos pensar que el objetivo de un sistema de control tan estricto es evitar cometer errores, pero no es así. Sin embargo, la realidad de una obra es compleja y el Código Estructural adopta un enfoque más pragmático y eficaz: asume que se producirán desviaciones, pero exige un proceso robusto para detectarlas, documentarlas y corregirlas antes de que se conviertan en un problema.

Cada vez que una inspección detecta una «no conformidad» (un aspecto que no cumple con el proyecto), se registra en una «Ficha de registro de control». En esta ficha se detalla el problema y, lo más importante, la «decisión adoptada» para solucionarlo. Los ejemplos extraídos de un proyecto real son muy reveladores:

- Ejemplo 1 (ficha n.º 6): durante una comprobación de cotas, se detectó que el pilar n.º 20 se había hormigonado 7,5 cm por encima de lo especificado. Un error así habría impedido la correcta colocación de las armaduras de acero del forjado superior. La solución fue directa y contundente: se ordenó demoler el hormigón sobrante hasta alcanzar la cota correcta.

- Ejemplo 2 (ficha n.º 3): las barras de acero de espera de un pilar (es decir, las que conectan con el pilar del piso superior) estaban mal posicionadas. Esto comprometía el «recubrimiento», es decir, la capa mínima de hormigón que debe proteger el acero de la corrosión. En este caso, se hizo valer el criterio de ingeniería: en lugar de optar por la demolición, que habría supuesto un enorme coste y un retraso, se tomó una decisión más inteligente. Se aceptó la desviación dentro de las tolerancias y se ordenó modificar la forma final del pilar para garantizar el recubrimiento mínimo y salvar el elemento, sin comprometer en absoluto la seguridad.

- Ejemplo 3 (ficha n.º 4): tras retirar el encofrado de un pilar, se observó una fisura horizontal. Aunque resultó alarmante a primera vista, demostró la importancia de un diagnóstico preciso. La inspección determinó que se trataba de una fisura superficial causada por el «asiento plástico» del hormigón fresco, un fenómeno conocido que no tiene impacto estructural. En lugar de provocar una alarma innecesaria, se aplicó una solución precisa: picar la zona afectada y repararla con un mortero especial.

Este enfoque sistemático de la gestión de errores es lo que construye la verdadera seguridad. No se trata de no cometer nunca un error, sino de tener un plan infalible para corregir cada uno de ellos y dejar un registro completo de cada decisión.

3. Lo que se llama «simplificado» resulta sorprendentemente complejo.

El Código Estructural ofrece una «opción simplificada» para el control de la ejecución en obras de edificación con ciertas características. El nombre puede engañar al sugerir un proceso más laxo o básico. Nada más lejos de la realidad.

Esta modalidad «simplificada» sigue siendo un método extraordinariamente metódico y riguroso. Para empezar, obliga a dividir toda la estructura en «lotes de ejecución». Un lote no es una división arbitraria, sino que está perfectamente definido. Por ejemplo, en el caso de pilares y forjados, un lote equivale a un máximo de 250 m² de superficie construida o dos plantas. De este modo, se asegura una inspección granular y manejable de la obra.

Para cada uno de estos lotes, se despliega un plan de inspección que abarca una larga lista de procesos de ejecución. No solo se comprueba si el hormigón se ha vertido correctamente, sino que el control abarca desde la «gestión de acopios» (verificar que los materiales que llegan a la obra son los correctos) y los «replanteos» (asegurar que cada elemento estructural se ubica en su posición exacta según los planos), hasta el «acabado» final de los elementos.

La clave es que en ingeniería estructural no hay atajos. Incluso el camino «simplificado» es un testimonio de una cultura en la que el rigor metodológico es el estándar mínimo para garantizar la seguridad pública.

Conclusión: una nueva mirada sobre las estructuras que nos rodean.

Detrás del hormigón y el acero que vemos tomar forma en una obra, existe una arquitectura invisible de procesos: una coreografía de comprobaciones, registros y correcciones planificadas. Este sistema nervioso invisible de control y corrección es lo que confiere resiliencia a un edificio, permitiéndole nacer conforme a las reglas más estrictas.

No se trata de la ausencia de errores, sino de la certeza de que se corregirán, lo cual nos da tranquilidad. La próxima vez que entres en un edificio, ¿te acordarás de la inmensa red de controles y decisiones de ingeniería que garantizan que el edificio se mantenga firme y seguro sobre tu cabeza?

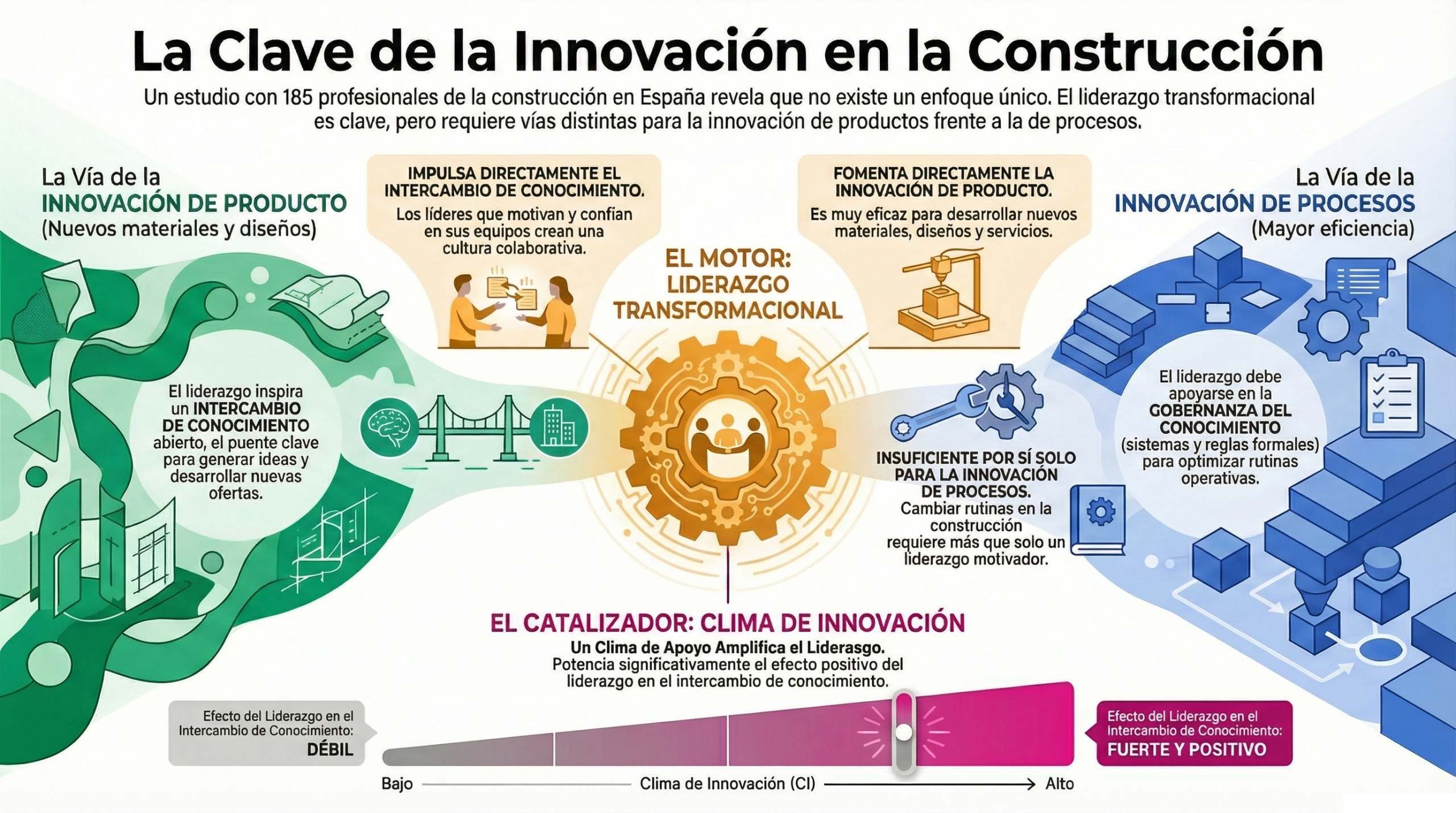

En esta conversación se exponen varias ideas relacionadas con este tema.

Este vídeo condensa los puntos clave de la opción simplificada del control de calidad, tal y como se establece en el Código Estructural.

Aquí os dejo un resumen que creo que os puede ayudar, ya que os será de gran utilidad para resolver vuestras dudas.

La Fundación Musaat ofrece una monografía que podéis descargar a continuación, que creo que es muy útil para adentrarse en los entresijos del Código Estructural en relación con la opción simplificada del control de ejecución de estructuras de hormigón.

Curso:

Curso de fabricación y puesta en obra del hormigón.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.