El diseño estructural de los edificios plantea importantes retos para garantizar su seguridad y sostenibilidad. El colapso progresivo, provocado por eventos extremos como terremotos o explosiones, puede ocasionar daños catastróficos. Para reducir este riesgo, se propone una metodología de diseño apoyada en metamodelos que combina optimización estructural y criterios de seguridad, y que tiene en cuenta elementos que a menudo se pasan por alto, como los forjados, las pantallas de arriostramiento y la interacción suelo-estructura (SSI, por sus siglas en inglés).

El diseño estructural de los edificios plantea importantes retos para garantizar su seguridad y sostenibilidad. El colapso progresivo, provocado por eventos extremos como terremotos o explosiones, puede ocasionar daños catastróficos. Para reducir este riesgo, se propone una metodología de diseño apoyada en metamodelos que combina optimización estructural y criterios de seguridad, y que tiene en cuenta elementos que a menudo se pasan por alto, como los forjados, las pantallas de arriostramiento y la interacción suelo-estructura (SSI, por sus siglas en inglés).

El trabajo se enmarca dentro del proyecto de investigación RESILIFE que dirijo como investigador principal en la Universitat Politècnica de València. También es fruto de la colaboración con investigadores de Brasil y Cuba.

Metodología

Descripción del problema

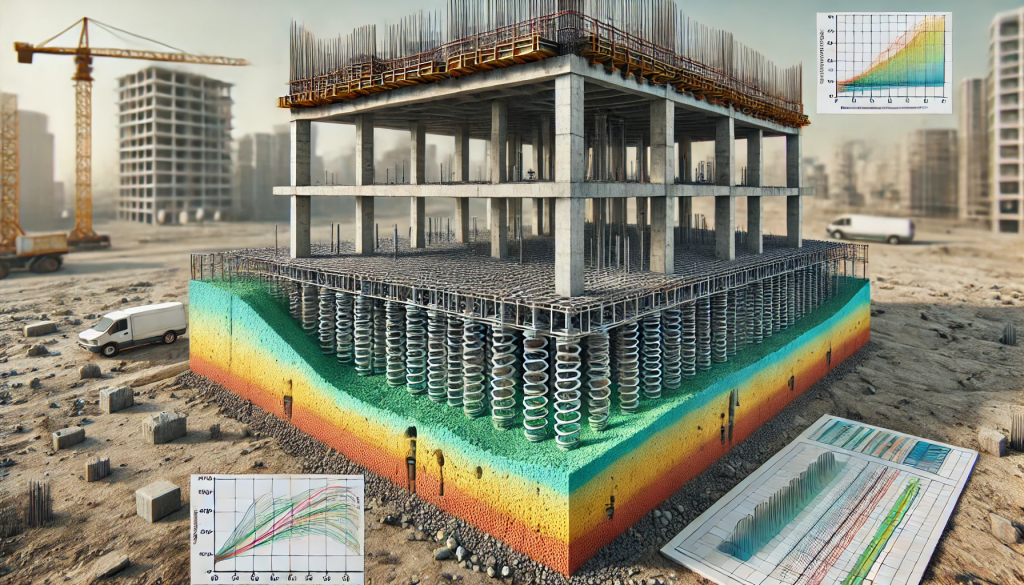

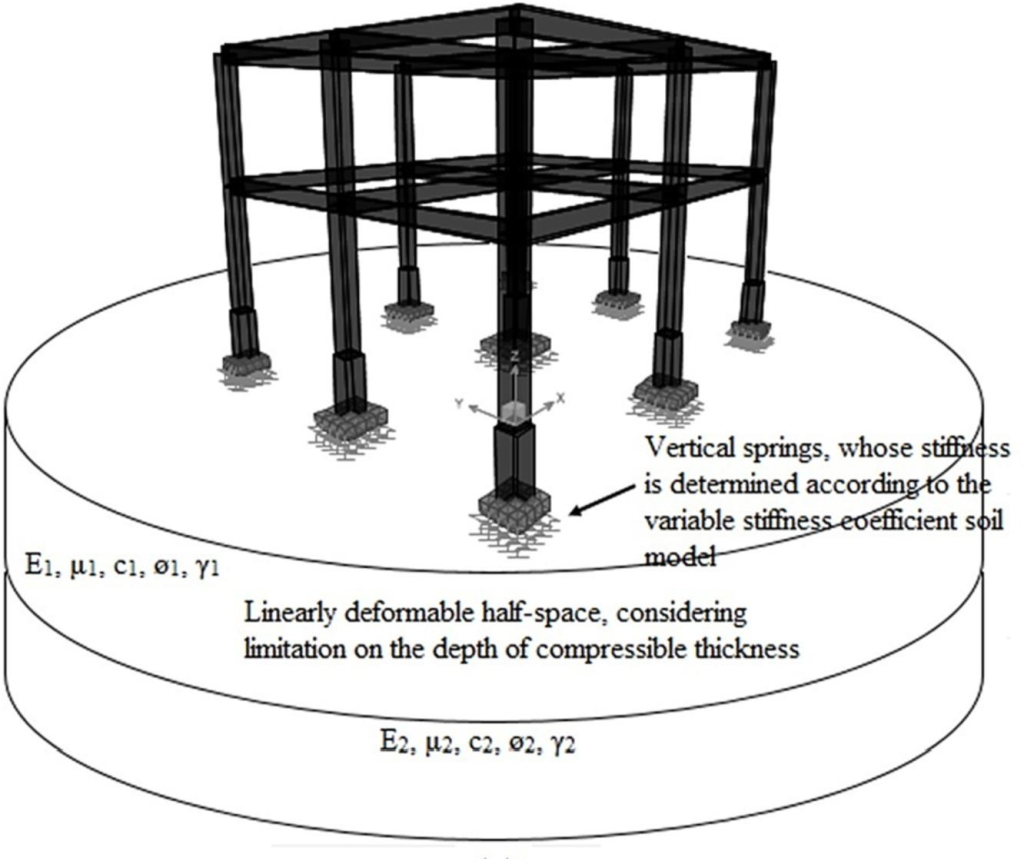

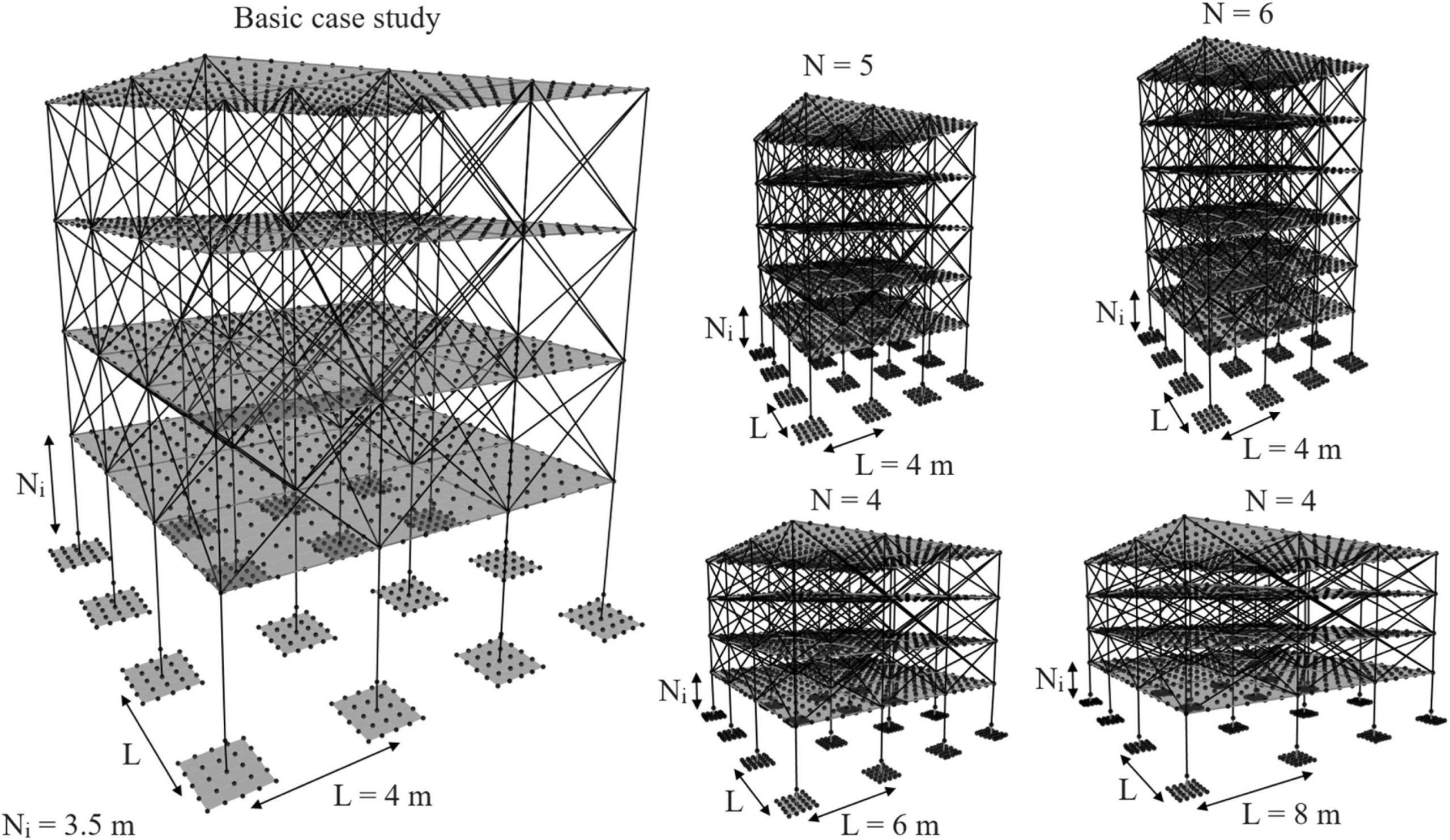

Se estudiaron cinco edificios de pórticos de hormigón armado con diferentes configuraciones de plantas y luces. Las estructuras incluyen vigas, columnas, forjados y pantallas de arriostramiento. Además, se incorporó el diseño optimizado de cimentaciones, considerando la interacción con el suelo mediante modelos de elasticidad lineal. Las dimensiones de los elementos estructurales se ajustaron siguiendo las normas internacionales de diseño y se consideraron distintas combinaciones de carga para evaluar escenarios críticos.

Se realizaron simulaciones numéricas avanzadas que tuvieron en cuenta escenarios de carga extremos, incluyendo la pérdida de columnas críticas en diversas posiciones. En el análisis se tuvieron en cuenta factores de seguridad, límites de servicio y fallos estructurales para determinar los diseños óptimos. También se tuvieron en cuenta criterios de sostenibilidad y se midieron las emisiones de CO₂ asociadas a cada solución.

Optimización basada en un diseño robusto frente al colapso progresivo (ObRDPC)

La metodología ObRDPC se centra en minimizar las emisiones de CO₂ como función objetivo, garantizando simultáneamente la robustez estructural mediante restricciones de seguridad. Para evaluar el colapso progresivo y simular la pérdida de columnas críticas, así como analizar la redistribución de cargas, se empleó el método de camino alternativo (AP). La metodología incluye la verificación de estados límite últimos y de servicio, lo que garantiza el cumplimiento de los requisitos normativos.

El proceso de optimización incluye la definición precisa de las variables de diseño, como las dimensiones de las vigas, columnas y cimentaciones, así como el tipo de hormigón utilizado. Para maximizar la eficiencia estructural y minimizar los costos ambientales, se aplican técnicas de programación matemática.

Modelización de forjados y pantallas de arriostramiento

- Forjados: se modelaron como elementos tipo placa de 12 cm de espesor y se conectaron a las vigas mediante nodos rígidos para asegurar la continuidad estructural. Se realizó una discretización adecuada para representar su comportamiento realista ante cargas verticales y horizontales. El análisis incluyó el comportamiento a flexión, los efectos de cargas concentradas y la interacción con los elementos perimetrales. Se consideraron diferentes configuraciones de refuerzo para maximizar la resistencia y minimizar las deformaciones.

- Pantallas de arriostramiento: representadas mediante diagonales equivalentes elásticas, según las especificaciones normativas. Se definieron sus propiedades mecánicas mediante modelos experimentales previos, incluyendo el módulo de elasticidad y la resistencia a compresión. Se estudiaron distintos tipos de mampostería y su influencia en la resistencia general. Las pantallas de arriostramiento también se evaluaron como elementos activos en la redistribución de cargas después de eventos que provocan la pérdida de soporte, lo que mejora la estabilidad global del sistema estructural.

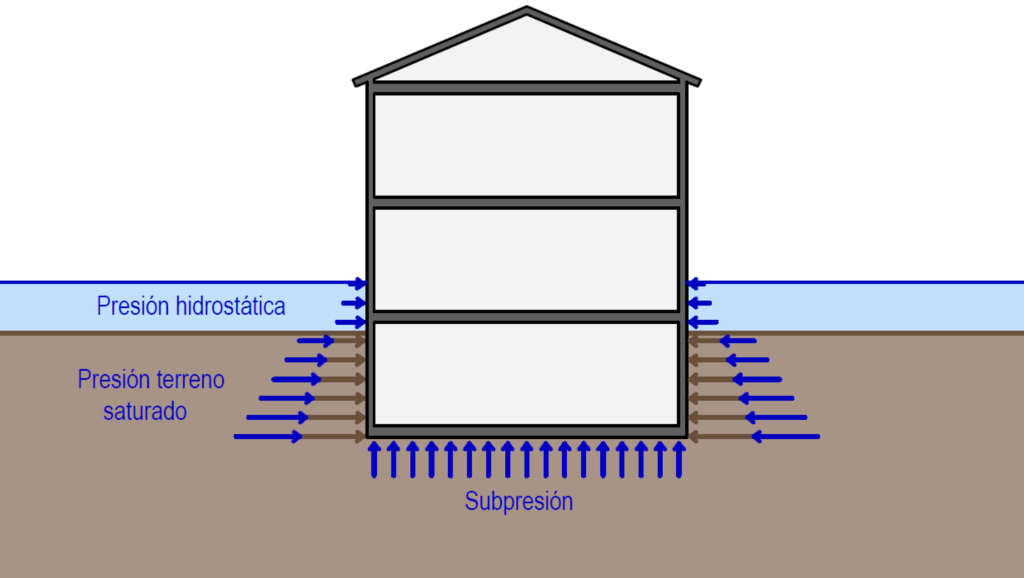

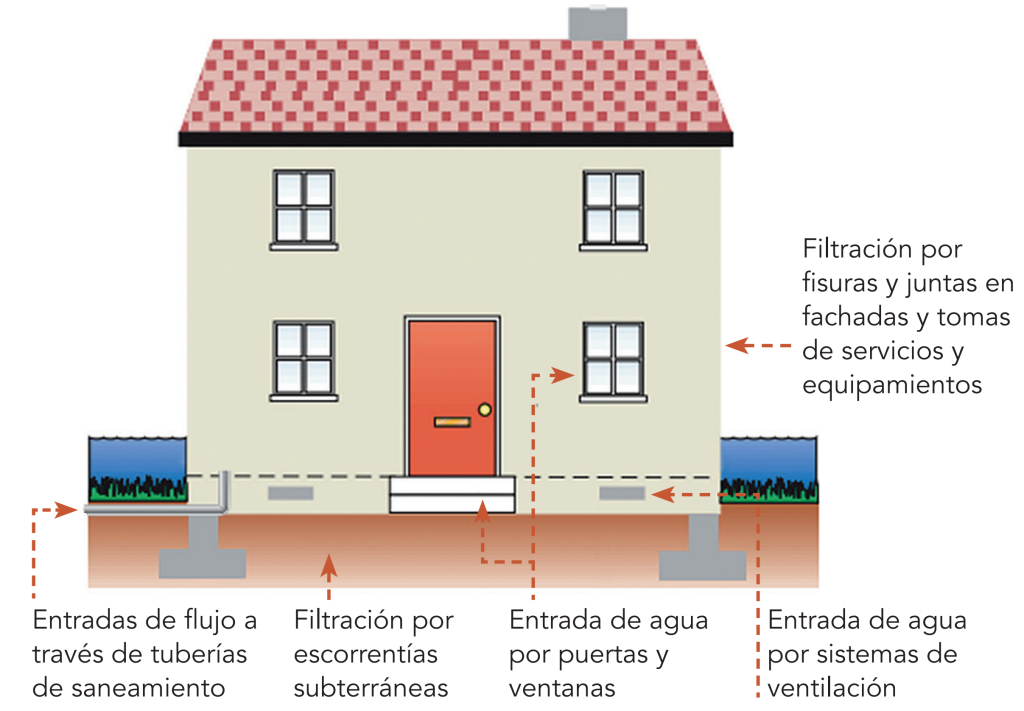

Interacción suelo-estructura (SSI)

Se consideró el asentamiento diferencial de las cimentaciones mediante coeficientes de rigidez calculados según modelos elásticos. El suelo se modeló como un medio elástico semiespacial. En el análisis se incluyó la interacción entre la superestructura y el terreno para capturar los efectos de asentamientos desiguales y su impacto en el estado de esfuerzos y deformaciones.

En el análisis se tuvieron en cuenta diferentes tipos de suelos, desde arcillas de baja resistencia hasta suelos granulares compactados. Se realizaron estudios paramétricos para evaluar la sensibilidad del sistema a variaciones en la rigidez del terreno y el módulo de elasticidad del hormigón.

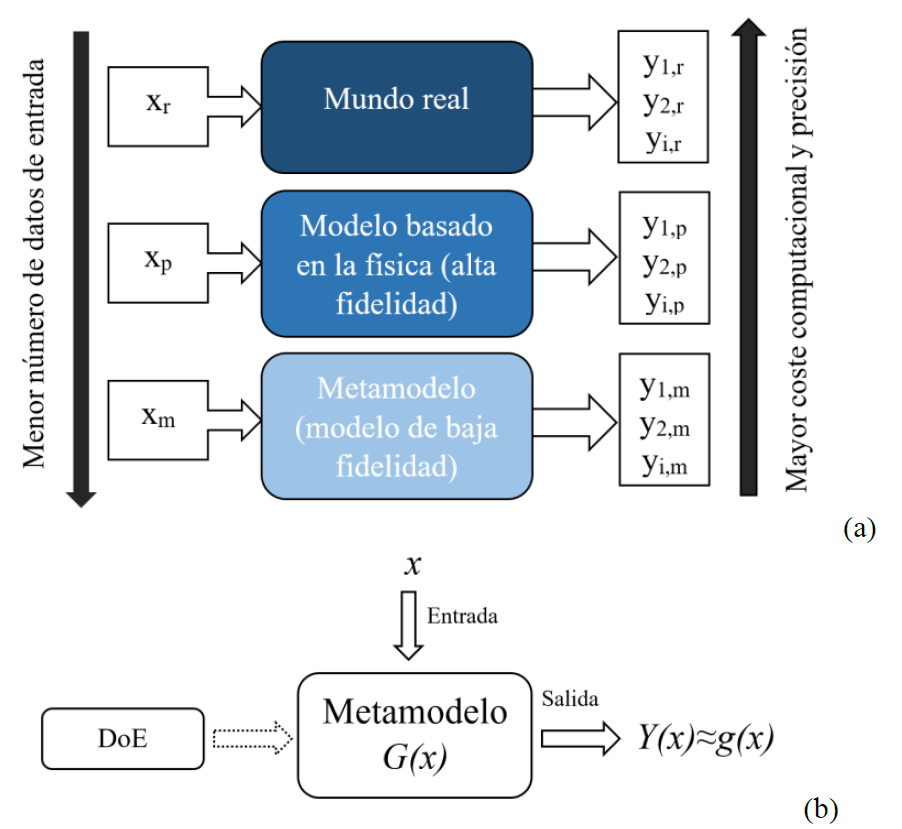

Optimización asistida por metamodelos

Se utilizaron técnicas avanzadas de optimización asistida por metamodelos para reducir la carga computacional. El proceso incluyó un muestreo inicial mediante muestreo hipercúbico latino para cubrir eficientemente el espacio de diseño, seguido de la construcción del metamodelo a través de técnicas de interpolación Kriging para aproximar las respuestas estructurales, evaluando múltiples configuraciones para garantizar la precisión. Posteriormente, se aplicó una optimización global utilizando algoritmos evolutivos, como la Biogeography-based Optimization (BBO), para explorar soluciones factibles y un método iterativo para refinar las soluciones y garantizar su viabilidad en condiciones críticas.

Resultados

Impacto de forjados y pantallas de arriostramiento

La inclusión de forjados y pantallas de arriostramiento mejoró significativamente la redistribución de cargas y la resistencia al colapso progresivo. El análisis mostró una reducción del 11 % en el impacto ambiental para diseños resistentes al colapso, en comparación con modelos que solo consideran vigas y columnas.

Se observó una mejora notable en la capacidad de redistribución de cargas después de la pérdida de columnas críticas. Las pantallas de arriostramiento actuaron como elementos resistentes adicionales, mitigando fallos en los elementos primarios y reduciendo los desplazamientos globales.

Comparación de enfoques de diseño

Se observó que aumentar el número de niveles incrementa la robustez estructural debido a la mayor redundancia de elementos. Sin embargo, el incremento de la longitud de las luces de las vigas reduce esta capacidad, por lo que es necesario utilizar secciones más robustas y aplicar mayores refuerzos.

Los modelos con luces de 8 m presentaron un aumento del 50 % en las emisiones de CO₂ cuando no se incluyeron forjados ni pantallas de arriostramiento. Al incorporarlos, se consiguió reducir este incremento a la mitad.

Recomendaciones prácticas para el diseño estructural

- Incluir forjados y pantallas de arriostramiento: Su integración mejora significativamente la resistencia al colapso progresivo, particularmente en edificios con luces amplias.

- Optimizar secciones estructurales: Diseñar secciones de vigas y columnas equilibrando rigidez y eficiencia económica.

- Evaluar diferentes tipos de cimentaciones: Incorporar análisis de interacción suelo-estructura para definir bases óptimas.

- Aplicar análisis paramétricos: Evaluar la sensibilidad de los diseños a variaciones en la resistencia del hormigón y las condiciones geotécnicas.

- Considerar combinaciones de carga extremas: Simular múltiples fallos para garantizar diseños robustos y seguros.

Conclusión

La optimización basada en un diseño robusto frente al colapso progresivo (ObRDPC) permite diseñar estructuras resistentes al colapso progresivo con menor impacto medioambiental. El uso de metamodelos y la consideración de forjados, pantallas de arriostramiento y la interacción suelo-estructura mejoran significativamente la seguridad estructural y la sostenibilidad del diseño. Se recomienda ampliar esta investigación a otros tipos de estructuras y condiciones geotécnicas complejas para validar y perfeccionar la metodología propuesta.

Referencia:

NEGRÍN, I.; KRIPKA, M.; YEPES, V. (2025). Metamodel-assisted design optimization of robust-to-progressive-collapse RC frame buildings considering the impact of floor slabs, infill walls, and SSI implementation. Engineering Structures, 325:119487. DOI:10.1016/j.engstruct.2024.119487

Como el artículo se ha publicado en abierto, lo podéis descargar aquí: