Acaban de publicarnos un artículo en Materials, revista indexada en el primer cuartil del JCR. En este caso se han optimizado las emisiones de CO₂ de un marco prefabricado articulado, de sección en U, empleando para ello varias metaheurísticas. El trabajo se enmarca dentro del proyecto de investigación HYDELIFE que dirijo como investigador principal en la Universitat Politècnica de València.

Acaban de publicarnos un artículo en Materials, revista indexada en el primer cuartil del JCR. En este caso se han optimizado las emisiones de CO₂ de un marco prefabricado articulado, de sección en U, empleando para ello varias metaheurísticas. El trabajo se enmarca dentro del proyecto de investigación HYDELIFE que dirijo como investigador principal en la Universitat Politècnica de València.

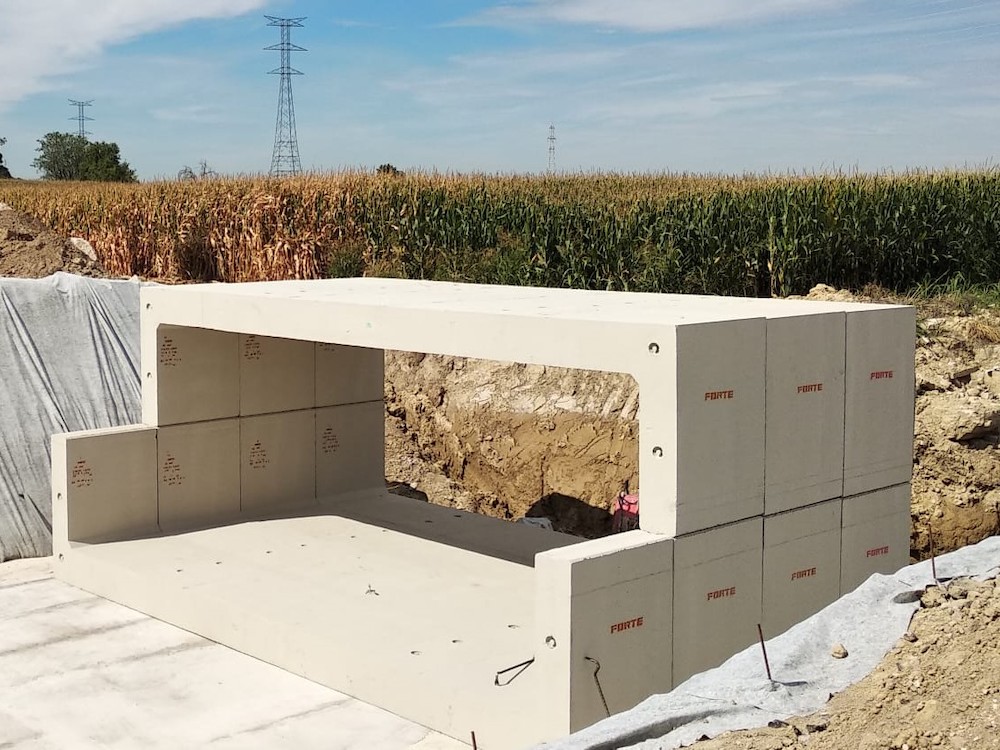

El desarrollo sostenible requiere una mejora en el uso de los recursos naturales. El objetivo principal de este estudio es optimizar el uso de materiales en la construcción de pórticos articulados prefabricados de hormigón armado. Para ello, se desarrolló un software propio en el lenguaje de programación Python. Esto permitió calcular, verificar y optimizar la estructura mediante la aplicación de técnicas metaheurísticas. El coste final es una representación directa del empleo de materiales. Para ello, se aplicaron tres algoritmos para resolver la optimización económica de la estructura. Gracias a los algoritmos de recocido simulado, de aceptación de umbrales y del solterón, se consiguieron diseños sostenibles y no tradicionales. Estos hacen un uso óptimo de los recursos naturales, manteniendo un coste final muy reducido. Para evaluar la mejora del impacto ambiental, se estudiaron las emisiones de dióxido de carbono y se compararon con las de una estructura de hormigón armado in situ de referencia. Los resultados mostraron diseños con una losa superior y muros laterales de menor profundidad y un refuerzo pasivo denso. Con ellos, se consiguió reducir el coste final de la estructura hasta en un 24 %, así como las emisiones asociadas en más de un 30 %.

Abstract:

Sustainable development requires improvements in the use of natural resources. The main objective of the present study was to optimize the use of materials in the construction of reinforced concrete precast hinged frames. Proprietary software was developed in the Python programming language. This allowed the structure’s calculation, verification, and optimization by applying metaheuristic techniques. The final cost is a direct representation of the use of materials. Thus, three algorithms were applied to solve the economic optimization of the frame. By applying simulated annealing, threshold accepting, and old bachelor’s acceptance algorithms, sustainable, non-traditional designs were achieved. These make optimal use of natural resources while maintaining a highly restricted final cost. The carbon-dioxide-associated emissions were studied and compared with a reference cast-in-place reinforced concrete frame to evaluate the environmental impact improvement. The results showed designs with reduced upper slab and lateral wall depth and dense passive reinforcement. These were able to reduce up to 24% of the final cost of the structure, as well as over 30% of the associated emissions.

Keywords:

Reinforced concrete; precast; hinged frame; metaheuristic; optimization; sustainability.

Reference:

RUIZ-VÉLEZ, A.; ALCALÁ, J.; YEPES, V. (2023). Optimal design of sustainable reinforced concrete precast hinged frames. Materials, 16(1):204. DOI:10.3390/ma16010204.