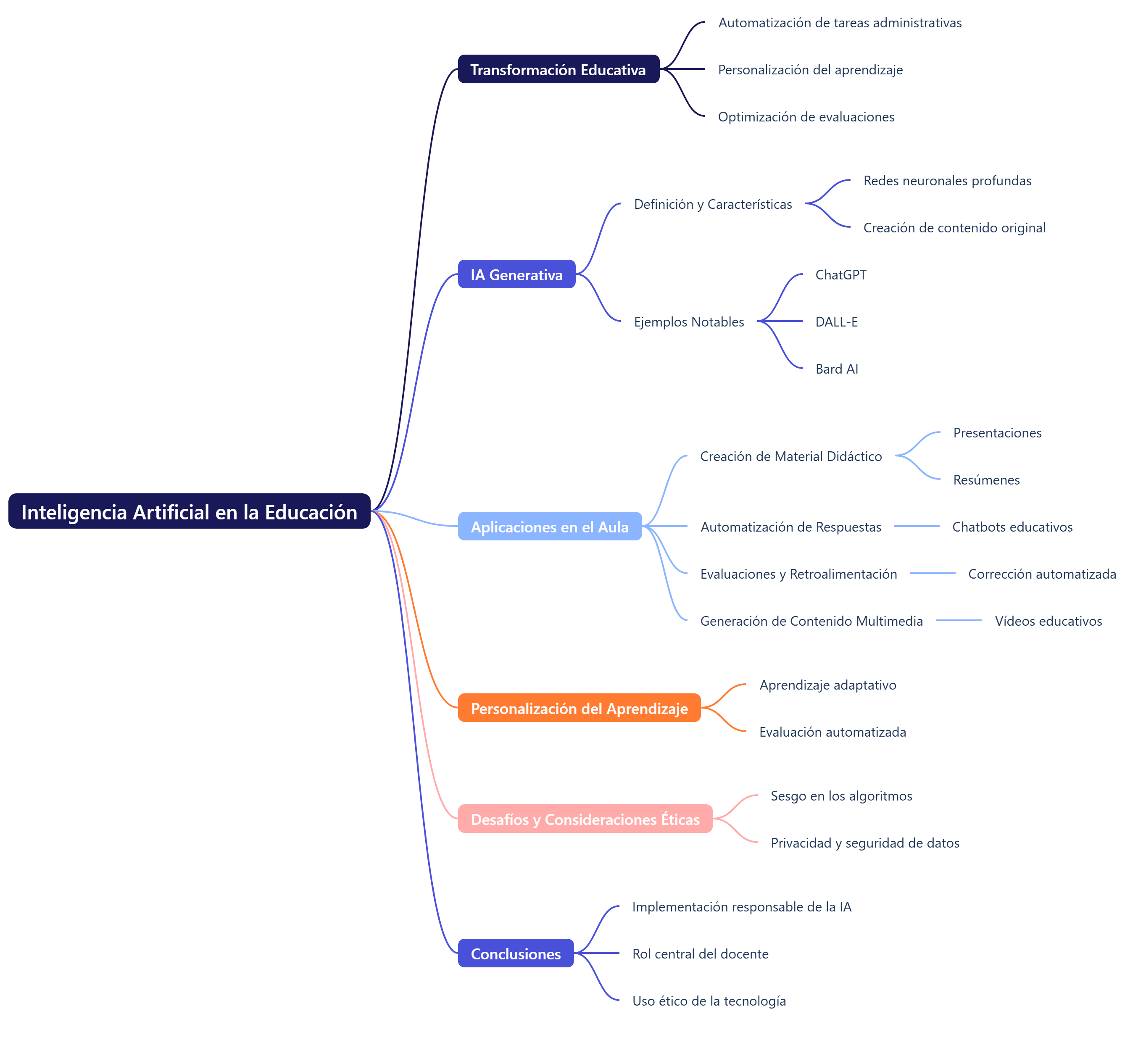

La educación está experimentando una transformación sin precedentes gracias a los avances en inteligencia artificial (IA). La integración de la IA en el ámbito educativo ha traído consigo oportunidades y desafíos que requieren una adaptación rápida por parte de los docentes y los sistemas de enseñanza.

La educación está experimentando una transformación sin precedentes gracias a los avances en inteligencia artificial (IA). La integración de la IA en el ámbito educativo ha traído consigo oportunidades y desafíos que requieren una adaptación rápida por parte de los docentes y los sistemas de enseñanza.

Esta revolución tecnológica ha dado lugar a la automatización de tareas administrativas, la personalización del aprendizaje, la optimización de evaluaciones y el desarrollo de nuevas metodologías de enseñanza que mejoran la eficiencia del aula. Sin embargo, su implementación también genera preocupaciones relacionadas con la equidad, la privacidad de los datos y la ética en la educación.

Este informe explora en profundidad cómo los docentes pueden aprovechar la IA para mejorar sus prácticas pedagógicas y hacer frente a los desafíos emergentes. Se proporcionarán ejemplos detallados, herramientas específicas y estrategias que permitirán a los educadores integrar esta tecnología de manera efectiva y responsable en sus aulas.

1. Inteligencia artificial generativa y su aplicación en la docencia

1.1. Definición y características

La inteligencia artificial generativa es una rama avanzada de la IA que emplea redes neuronales profundas para crear contenido original en formato de texto, imágenes, audio y vídeo. Este tipo de IA puede proporcionar respuestas personalizadas y adaptadas a distintos contextos de aprendizaje, lo que la convierte en una herramienta muy útil en el ámbito educativo.

Algunos ejemplos notables de IA generativa son ChatGPT, que puede generar respuestas detalladas en múltiples idiomas; DALL-E, que crea imágenes a partir de descripciones textuales, y Bard AI, que ofrece información en tiempo real a partir de consultas específicas.

El uso de estas herramientas en la docencia permite mejorar la interacción con los estudiantes, proporcionar materiales personalizados y fomentar un aprendizaje más dinámico. Además, la IA generativa puede ayudar en la corrección de textos, la generación de pruebas automatizadas y la creación de contenidos visuales para reforzar los conceptos enseñados en el aula.

1.2. Aplicaciones en el aula

Las aplicaciones de la inteligencia artificial (IA) generativa en la enseñanza son diversas y pueden utilizarse en diferentes áreas del conocimiento. Entre las más destacadas se encuentran:

- Creación de material didáctico: la IA permite generar rápidamente presentaciones, resúmenes y documentos de apoyo para los estudiantes. Herramientas como Canva AI o Tome AI facilitan la producción de diapositivas atractivas con contenido relevante.

- Automatización de respuestas: los docentes pueden utilizar chatbots educativos como PersonalChat para responder de manera inmediata a las dudas recurrentes de los estudiantes.

- Evaluaciones y retroalimentación: plataformas como Gradescope permiten corregir exámenes de manera automatizada, lo que reduce la carga de trabajo de los docentes y asegura una evaluación más objetiva.

- Generación de contenido multimedia: con herramientas como Runway AI y Pictory, los docentes pueden crear vídeos educativos personalizados y mejorar la experiencia de aprendizaje.

Un ejemplo concreto de su aplicación es el uso de ChatGPT en universidades para ayudar a los estudiantes en la redacción de ensayos, proporcionando estructuras sugeridas y correcciones gramaticales detalladas. Esto no solo mejora la calidad de los trabajos académicos, sino que también fomenta la autonomía y la autoevaluación de los estudiantes.

2. Personalización del aprendizaje y evaluación con IA

2.1. Aprendizaje adaptativo

Uno de los mayores beneficios de la inteligencia artificial (IA) en la educación es su capacidad para personalizar el aprendizaje en función del nivel y el ritmo de cada estudiante. Gracias al análisis de datos, los algoritmos de IA pueden identificar fortalezas y debilidades de los alumnos y ajustar los contenidos educativos en tiempo real para optimizar su rendimiento académico.

Algunas plataformas que utilizan este enfoque son:

- Khan Academy con IA ofrece ejercicios personalizados según el nivel de conocimiento del estudiante.

- Duolingo AI: adapta la dificultad de los ejercicios de idiomas en función del progreso del usuario.

- Carnegie Learning ofrece tutorías de matemáticas con IA, que adaptan las preguntas al rendimiento del estudiante.

Este enfoque permite que los estudiantes reciban una educación más centrada en sus necesidades individuales, lo que reduce las brechas de aprendizaje y mejora la retención del conocimiento.

2.2. Evaluación automatizada

Otro aspecto crucial de la IA en la educación es la optimización del proceso de evaluación. Tradicionalmente, corregir exámenes y tareas supone un gran esfuerzo para los docentes. Gracias a herramientas como Gradescope y ZipGrade, ahora es posible evaluar pruebas de manera instantánea, proporcionar retroalimentación detallada y reducir el margen de error.

Además de la corrección automatizada, la IA puede utilizarse para analizar el rendimiento de los estudiantes a lo largo del tiempo y predecir posibles dificultades académicas. Por ejemplo, la plataforma Edsight AI recopila datos sobre las respuestas de los alumnos y genera informes personalizados con recomendaciones para mejorar su rendimiento.

A pesar de sus ventajas, la evaluación automatizada debe complementarse con métodos tradicionales para garantizar una comprensión profunda de los conceptos por parte de los estudiantes y evitar depender exclusivamente de algoritmos para medir los conocimientos.

3. Desafíos y consideraciones éticas

3.1. Sesgo en los algoritmos

Uno de los principales desafíos de la IA en la educación es la presencia de sesgos en los modelos de aprendizaje. Dado que las IA se entrenan con grandes volúmenes de datos históricos, pueden reflejar prejuicios existentes en la sociedad, lo que podría afectar negativamente a la equidad de la enseñanza.

Para minimizar estos riesgos, es fundamental que los docentes supervisen el contenido generado por IA y utilicen diversas fuentes para contrastar la información. Además, se recomienda fomentar el pensamiento crítico entre los estudiantes para que evalúen la veracidad y la imparcialidad de los datos proporcionados por estos sistemas.

3.2. Privacidad y seguridad de datos

El uso de la IA en la educación implica la recopilación y el análisis de grandes volúmenes de datos sobre los estudiantes. Para proteger su privacidad, es crucial que las instituciones educativas implementen regulaciones estrictas sobre el almacenamiento y uso de la información personal.

Algunas estrategias recomendadas son:

- Utilización de plataformas con altos estándares de seguridad, como Microsoft Copilot y Google AI Education.

- Concienciar sobre la importancia de la privacidad y enseñar a los estudiantes a gestionar sus datos de forma segura en entornos digitales.

- Cumplimiento de normativas de protección de datos, como el Reglamento General de Protección de Datos (RGPD) en Europa.

Conclusiones

La inteligencia artificial está revolucionando la educación, ya que ofrece nuevas posibilidades para mejorar la enseñanza y el aprendizaje. Sin embargo, su implementación debe realizarse de manera responsable, garantizando el papel central del docente y promoviendo el uso ético de la tecnología.

Para maximizar sus beneficios, es esencial que los educadores se mantengan actualizados sobre las últimas tendencias en IA y adopten herramientas que complementen sus metodologías de enseñanza. La combinación de innovación tecnológica con estrategias pedagógicas efectivas transformará la educación y preparará a los estudiantes para los desafíos del futuro.

Os dejo un documento de la Universidad de Burgos que profundiza en el tema. Espero que os resulte de interés.