Introducción: El gigante con pies de barro.

Los rascacielos son monumentos a la permanencia. Se elevan sobre nuestras ciudades como símbolos de ingenio, poder y estabilidad estructural. Sin embargo, en 1978, el Citigroup Center, uno de los edificios más innovadores y reconocibles de Nueva York, ocultaba un secreto aterrador. Inaugurado con gran fanfarria en 1977, este hito de la ingeniería estaba, de hecho, peligrosamente cerca del colapso.

La ironía central de esta historia es casi cinematográfica: el fallo catastrófico se descubrió gracias a la pregunta de una estudiante universitaria, y la persona que cometió el error de cálculo que puso en peligro a miles de personas fue la misma que se convirtió en el héroe que los salvó. Esta es la historia de cómo una combinación de error humano, ética profesional y una suerte increíble evitó uno de los mayores desastres arquitectónicos de la historia moderna.

1. No bastó con un solo error; se necesitaron dos para poner en jaque al gigante.

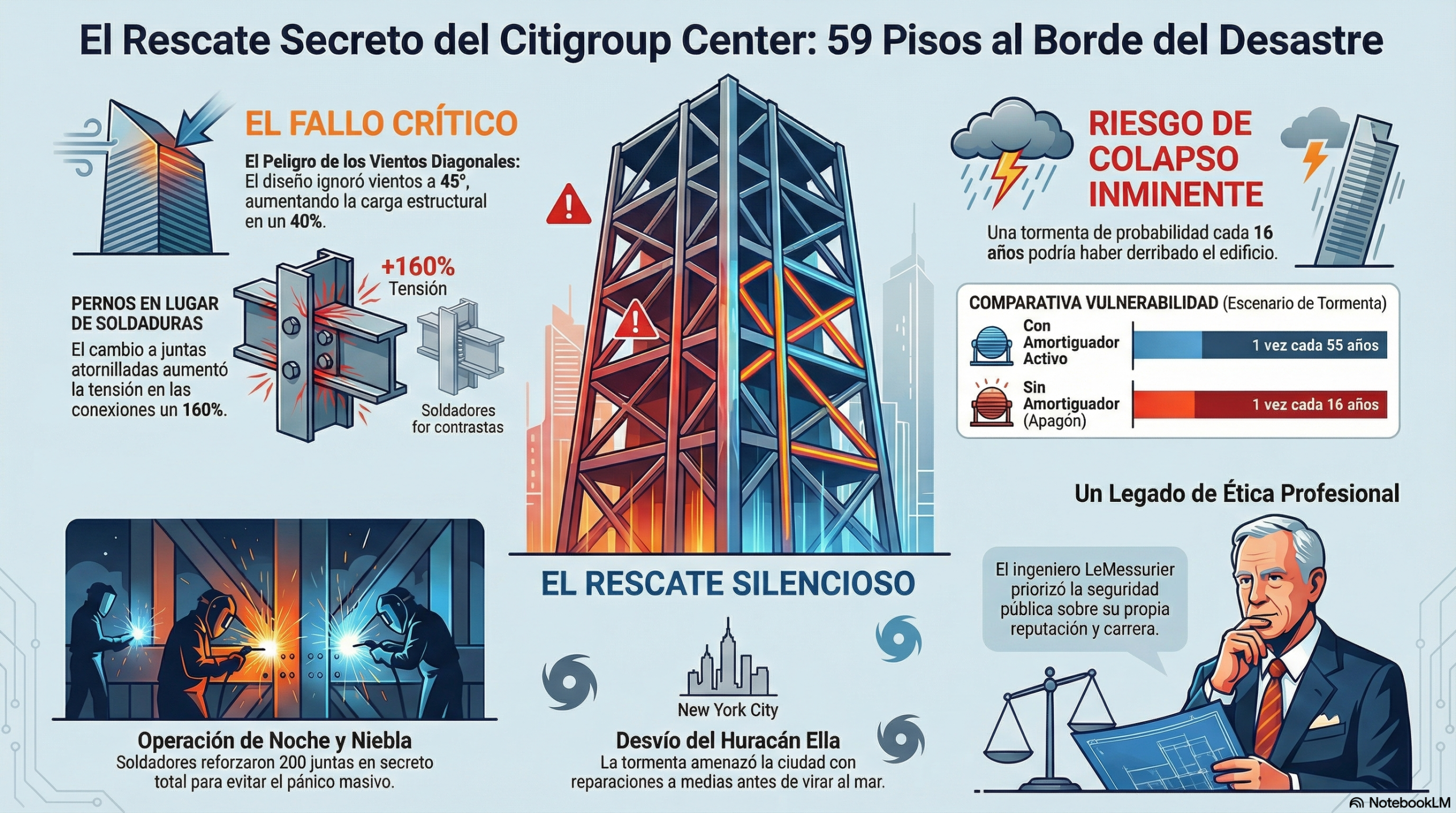

El fallo que puso en jaque al Citigroup Center no fue un simple descuido, sino la combinación de dos errores críticos que se multiplicaron entre sí.

El primero fue un error de cálculo cometido por William LeMessurier, el ingeniero jefe. Siguiendo el código de construcción de la época, calculó las cargas de viento que incidían perpendicularmente en las caras del edificio. Sin embargo, debido al diseño único de la torre, que estaba apoyada sobre cuatro enormes pilares situados en el centro de cada lado en lugar de en las esquinas, pasó por alto que los vientos diagonales (conocidos como quartering winds) ejercían una tensión mucho mayor. Este descuido incrementó la carga en las uniones estructurales clave en un 40 %.

El segundo error agravó fatalmente el primero. Durante la construcción, la empresa constructora Bethlehem Steel propuso sustituir las uniones soldadas, que eran más resistentes pero también más costosas, por uniones atornilladas, más económicas. Basándose en los cálculos originales de vientos perpendiculares, este cambio parecía una modificación rutinaria y segura, por lo que la oficina de LeMessurier lo aprobó sin que él revisara personalmente las implicaciones. En aquel momento, fue una decisión técnicamente sólida, pero con el paso del tiempo se consideró fatal.

La combinación de un error oculto y una decisión que parecía segura resultó devastadora. La carga adicional del 40 % de los vientos diagonales aplicada a las uniones atornilladas más débiles provocó un aumento catastrófico del 160 % en la tensión de las conexiones. Esto significaba que una tormenta que ocurre cada 55 años podría ser desastrosa. Sin embargo, el peligro real era aún mayor: si el amortiguador de masa sintonizado del edificio, que dependía de la electricidad, fallaba durante un apagón —algo muy probable durante un huracán—, una tormenta mucho más común, de las que golpean Nueva York cada dieciséis años, podría derribarlo.

2. El «héroe» de la historia fue el ingeniero que cometió el error.

Tras descubrir el fallo, William LeMessurier se enfrentó a un dilema ético devastador. Años después, relataría que consideró todas las opciones, desde guardar silencio y arriesgar miles de vidas hasta el suicidio para escapar de la desgracia profesional.

Sin embargo, LeMessurier tomó la decisión más honorable: asumir toda la responsabilidad. Consciente de que esto podría significar el fin de su carrera, la bancarrota y la humillación pública, se puso en contacto con los directivos de Citicorp para informarles de que su flamante rascacielos de 175 millones de dólares era fundamentalmente inseguro. En ese momento, su mentalidad no se limitaba al deber, sino que también reflejaba un profundo sentido de su posición única, como él mismo describió:

«Tenía información que nadie más en el mundo poseía. Tenía en mis manos el poder de influir en eventos extraordinarios que solo yo podía iniciar».

Para su sorpresa, la reacción de los ejecutivos de Citicorp, liderados por el presidente Walter Wriston, no fue de ira, sino de una calma pragmática. En lugar de buscar culpables, Wriston se centró de inmediato en la solución. Pidió un bloc de notas amarillo, empezó a redactar un comunicado de prensa y bromeó: «Todas las guerras se ganan con generales que escriben en blocs amarillos». Este gesto de liderazgo, enfocado y sereno, sentó las bases para la increíble operación de rescate que estaba a punto de comenzar.

3. Una llamada casual de una estudiante lo desencadenó todo.

Toda esta crisis existencial y de ingeniería se desencadenó en junio de 1978 por un hecho tan improbable como una simple llamada telefónica. Al otro lado de la línea estaba Diane Hartley, una estudiante de ingeniería de la Universidad de Princeton que analizaba la estructura del Citigroup Center para su tesis.

Hartley llamó a LeMessurier con preguntas sobre la estabilidad del edificio frente a vientos diagonales. Confiado en su diseño, LeMessurier le explicó pacientemente por qué la estructura era sólida. Sin embargo, la llamada de Hartley sembró una semilla. No porque tuviera una preocupación inmediata, sino porque la conversación lo inspiró, LeMessurier decidió que el tema sería un excelente ejercicio académico para la conferencia que preparaba para sus propios estudiantes de Harvard.

Fue durante este recálculo, realizado por pura curiosidad intelectual, cuando descubrió con horror su error original. La llamada casual de Hartley no le dio la respuesta, pero le hizo la pregunta correcta en el momento adecuado, lo que supuso el golpe de suerte que reveló una vulnerabilidad mortal y activó la carrera contrarreloj para evitar una catástrofe inimaginable.

4. Una operación secreta, un huracán y una huelga de prensa lo mantuvieron en secreto.

La reparación del Citigroup Center fue una operación clandestina de alta tensión. Bajo el nombre en clave «Proyecto SERENE», los equipos trabajaban con una precisión coreografiada. Cada noche, los carpinteros llegaban a las 17:00 h para construir recintos de madera contrachapada alrededor de las juntas que había que reparar. Entre las 20:00 y las 04:00, con el sistema de alarma contra incendios desactivado, los soldadores trabajaban para reforzar más de doscientas uniones atornilladas con placas de acero de dos pulgadas de espesor. Finalmente, un equipo de limpieza eliminaba todo rastro del trabajo antes de la llegada de los primeros empleados a las 8 a. m., ajenos al peligro que se cernía sobre ellos.

El drama alcanzó su punto álgido a principios de septiembre de 1978, cuando el huracán Ella, una tormenta muy intensa, se dirigía directamente hacia la ciudad de Nueva York. Con las reparaciones a medio terminar, el edificio seguía siendo vulnerable. En secreto, las autoridades elaboraron planes para evacuar la torre y una zona de diez manzanas a su alrededor.

Entonces, la suerte intervino de nuevo. A pocas horas de la posible catástrofe, el huracán Ella viró inesperadamente hacia el Atlántico, salvando a la ciudad. El suspiro de alivio fue inmenso. Y, como si esto no fuera suficiente, un último golpe de fortuna mantuvo todo en secreto: justo cuando la historia estaba a punto de filtrarse, comenzó una huelga de periódicos en toda la ciudad que duró varios meses. La huelga enterró la noticia por completo y el casi desastre permaneció oculto al público durante casi veinte años, hasta que fue revelado en un artículo de The New Yorker en 1995.

Conclusión: la delgada línea entre el desastre y la ética.

La historia del Citigroup Center es un poderoso recordatorio de la fragilidad que puede esconderse tras una apariencia de fortaleza. Una combinación de error humano, profunda ética profesional, liderazgo decisivo y una buena dosis de suerte evitó lo que podría haber sido uno de los peores desastres arquitectónicos de la historia. El ingeniero que cometió el error lo afrontó con una valentía que salvó incontables vidas y, paradójicamente, reforzó su reputación.

La historia del Citigroup Center nos recuerda que incluso los símbolos de la permanencia pueden ser frágiles. Nos deja con una pregunta: ¿cuántos otros secretos se esconden en las estructuras que nos rodean, esperando a que una simple pregunta los saque a la luz?

En esta conversación puedes escuchar las ideas más interesantes sobre este asunto.

Aquí puedes ver un vídeo que resume bien el contenido del artículo.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.