La unidad experimental (UE) es el elemento central en el diseño y el análisis de experimentos comparativos. Se define como la entidad a la que se le puede asignar un tratamiento de forma independiente y sobre la cual se realizan las mediciones. La identificación correcta de la UE es fundamental, ya que la estimación de la variabilidad natural, conocida como error experimental, depende exclusivamente de la comparación entre unidades experimentales idénticas que reciben el mismo tratamiento.

La unidad experimental (UE) es el elemento central en el diseño y el análisis de experimentos comparativos. Se define como la entidad a la que se le puede asignar un tratamiento de forma independiente y sobre la cual se realizan las mediciones. La identificación correcta de la UE es fundamental, ya que la estimación de la variabilidad natural, conocida como error experimental, depende exclusivamente de la comparación entre unidades experimentales idénticas que reciben el mismo tratamiento.

Una unidad experimental puede contener múltiples unidades muestrales, subelementos que reciben obligatoriamente el mismo tratamiento que la UE a la que pertenecen. Por esta razón, la variabilidad entre estas unidades muestrales internas no resulta útil para estimar el efecto del tratamiento. Un diseño experimental sólido se basa en la capacidad de distinguir los efectos reales de los tratamientos del «ruido» natural del sistema, una distinción que solo es posible mediante la correcta cuantificación de la variabilidad entre las unidades experimentales completas.

Definiciones fundamentales

El marco de un experimento se define a través de sus componentes básicos, en los que la unidad experimental y la unidad muestral desempeñan funciones distintas, aunque interconectadas.

1. La unidad experimental (UE)

La unidad experimental es el pilar de cualquier ensayo comparativo. Su definición formal es la siguiente:

«El elemento sobre el que se realizan las mediciones y al que se puede asignar un tratamiento de forma independiente».

El conjunto de todas las unidades experimentales disponibles para un estudio se denomina material experimental. La definición de una UE es flexible y se adapta a los objetivos de la investigación.

Ejemplos prácticos:

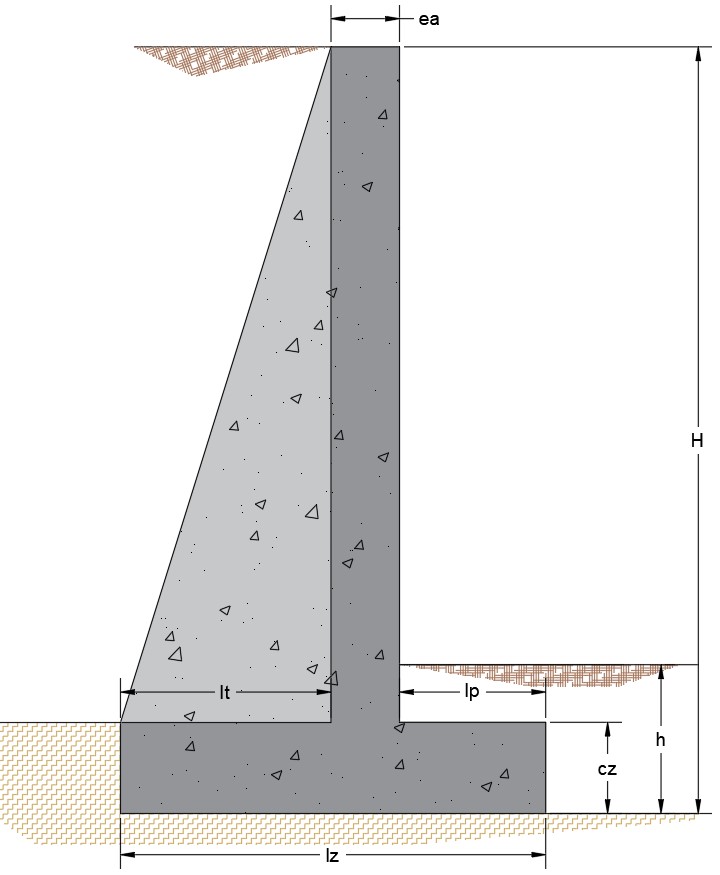

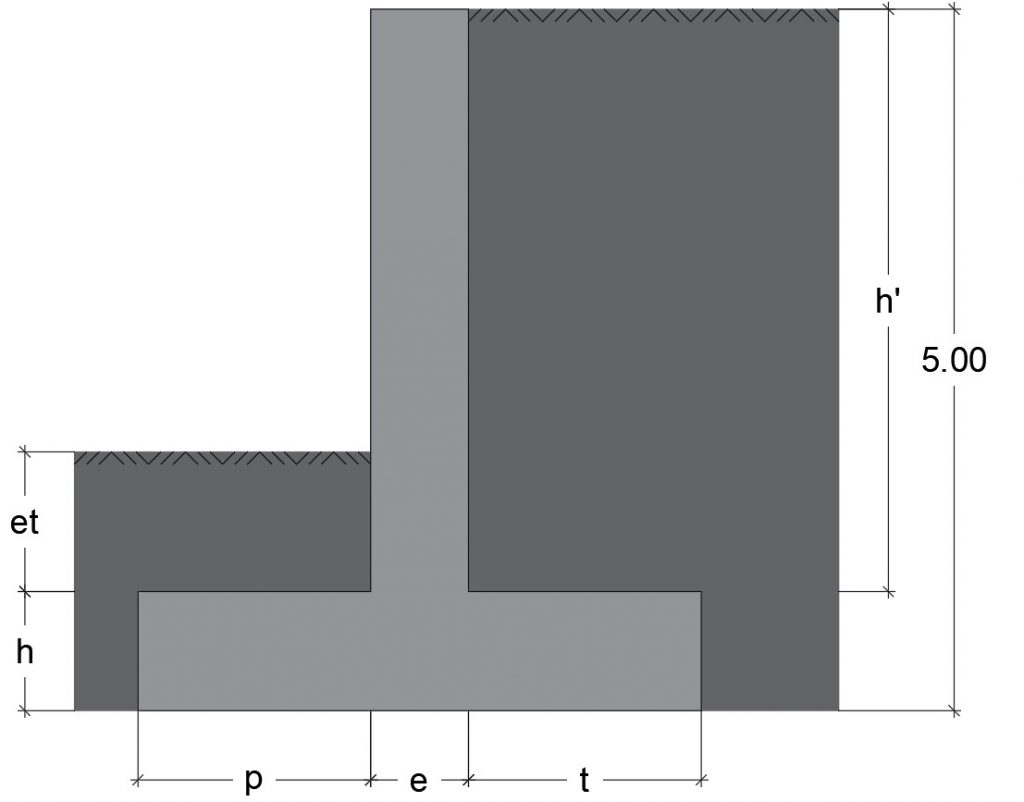

- Ensayo de resistencia del hormigón: la unidad experimental puede ser un bloque o un cilindro de hormigón elaborado con una mezcla específica. Las unidades muestrales serían las probetas o las muestras extraídas del mismo bloque para realizar ensayos de compresión o de flexión.

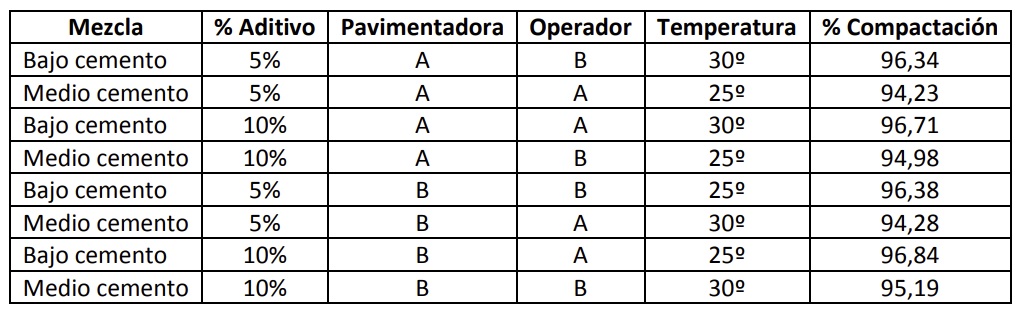

- Prueba de rendimiento de pavimentos: la unidad experimental puede ser un tramo de vía construido con un diseño o material específico (por ejemplo, un segmento de 50 metros). Las unidades muestrales serían los puntos de medición dentro del tramo, por ejemplo, las deflexiones o la rugosidad.

- Ensayo de estructuras a escala en laboratorio: la unidad experimental puede ser una viga o una columna, construida según un diseño específico. Las unidades muestrales serían los puntos de medición (deformaciones, desplazamientos o tensiones) registrados por sensores a lo largo de la estructura.

El criterio esencial para definir una UE es que sea capaz de recibir diferentes tratamientos de manera independiente de las demás unidades.

2. La unidad muestral.

Dentro de una unidad experimental pueden existir subelementos en los que se aplican las condiciones experimentales. A estos se les conoce como unidades muestrales.

La regla fundamental que las rige es que todas las unidades muestrales de una misma unidad experimental deben recibir el mismo tratamiento. Como consecuencia directa, la asignación del tratamiento a estas subunidades no es independiente entre sí, lo que tiene implicaciones críticas para el análisis estadístico.

El papel de la estimación en la variabilidad.

La distinción entre unidades experimentales y muestrales es crucial para inferir correctamente los efectos de un tratamiento, ya que incide directamente en la medición de la variabilidad del sistema.

a. El error experimental

Para evaluar si un tratamiento tiene un efecto real, es necesario conocer la variabilidad natural del material experimental. Esta variabilidad inherente se conoce como error experimental. Es la base contra la que se comparan las diferencias observadas entre los tratamientos.

b. Metodología de estimación

La estimación correcta del error experimental solo se logra a partir de las diferencias observadas entre unidades experimentales que, en principio, son idénticas y han recibido el mismo tratamiento.

- Fuente de estimación válida: la variación entre unidades experimentales es la única que permite estimar correctamente el error experimental.

- Fuente de estimación no válida: la variación entre las unidades muestrales dentro de una misma unidad experimental es, por lo general, muy pequeña y no proporciona información útil para estimar el efecto del tratamiento ni el error experimental.

La observación clave es que «solo la unidad experimental completa permite estimar correctamente el error experimental».

Tipología de variables en un experimento.

Los datos recopilados en un experimento se organizan en dos categorías principales de variables:

| Tipo de variable | Descripción |

| Variables de respuesta | Son las mediciones obtenidas de las unidades experimentales. Sus valores reflejan tanto los efectos de los tratamientos como la variabilidad natural del sistema. |

| Variables explicativas (factores) | Son las variables que se manipulan o controlan porque se cree que influyen en las variables de respuesta. Incluyen los factores de clasificación, que definen los niveles o categorías sobre los cuales se realizan las inferencias estadísticas. |

Conclusión: el fundamento de un diseño sólido.

La estructura de un diseño experimental robusto se basa en comparar unidades experimentales similares. Este enfoque permite a los investigadores distinguir de manera fiable el efecto real de los tratamientos aplicados del «ruido» o de la variabilidad natural inherente al sistema experimental. Por tanto, la identificación precisa y la gestión adecuada de la unidad experimental no son meros detalles técnicos, sino requisitos indispensables para que las conclusiones científicas derivadas del experimento sean válidas y fiables.

En este documento tenéis un resumen de las ideas más importantes.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.