Ayer estuve en un curso de creatividad organizado por nuestra Universitat Politècnica de València dirigida a sus profesores. Entre muchas de las herramientas que nos enseñaron quiero destacar la técnica de creatividad 6-3-5, que explicó la profesora Llanos Cuenca, muy útil para desarrollar la creatividad y enriquecer un problema, un proyecto o cualquier objetivo en el que tengamos que plantear nuevas perspectivas. Es una técnica basada en la “tormenta de ideas” (brainstroming), pero de forma organizada, por escrito y con un tiempo tasado, por lo que algunos describen el método como “brainwriting“. Este método lo creó el psicólogo alemán Bernd Rohrbach en 1968 y consiste en reunir a seis personas y sacar tres ideas cada una de ellas por turnos de cinco minutos. Se hacen rondas y se pasan las hojas al compañero de la derecha, que deberá rellenar, de forma concisa y breve, nuevas ideas sin repetir las que ya escribió y sin que coincidan con las que ya hay escritas. De esta forma se generan 18 ideas diferentes en cada hoja, que multiplicadas por 6 hojas, son un total de 108 ideas en media hora por cada grupo. Finalmente, se analizarán todas las ideas aportadas, eliminando las duplicadas, dedicándose para ello unos 30-40 minutos.

Ayer estuve en un curso de creatividad organizado por nuestra Universitat Politècnica de València dirigida a sus profesores. Entre muchas de las herramientas que nos enseñaron quiero destacar la técnica de creatividad 6-3-5, que explicó la profesora Llanos Cuenca, muy útil para desarrollar la creatividad y enriquecer un problema, un proyecto o cualquier objetivo en el que tengamos que plantear nuevas perspectivas. Es una técnica basada en la “tormenta de ideas” (brainstroming), pero de forma organizada, por escrito y con un tiempo tasado, por lo que algunos describen el método como “brainwriting“. Este método lo creó el psicólogo alemán Bernd Rohrbach en 1968 y consiste en reunir a seis personas y sacar tres ideas cada una de ellas por turnos de cinco minutos. Se hacen rondas y se pasan las hojas al compañero de la derecha, que deberá rellenar, de forma concisa y breve, nuevas ideas sin repetir las que ya escribió y sin que coincidan con las que ya hay escritas. De esta forma se generan 18 ideas diferentes en cada hoja, que multiplicadas por 6 hojas, son un total de 108 ideas en media hora por cada grupo. Finalmente, se analizarán todas las ideas aportadas, eliminando las duplicadas, dedicándose para ello unos 30-40 minutos.

Para que el método sea eficaz, previamente se habrán discutido los puntos principales del asunto para asegurarse de que cada integrante comprenda bien de qué se trata. El motor de la técnica es que, al leer las anotaciones anteriores, el cerebro descubre nuevas ideas. Al igual que ocurre con la lluvia de ideas, en este método 6-3-5 lo importante es la cantidad de ideas, más que su calidad. Luego se pueden aplicar otras técnicas para discutir, mejorar y filtrar las ideas hasta quedarse con unas pocas de mayor calidad.

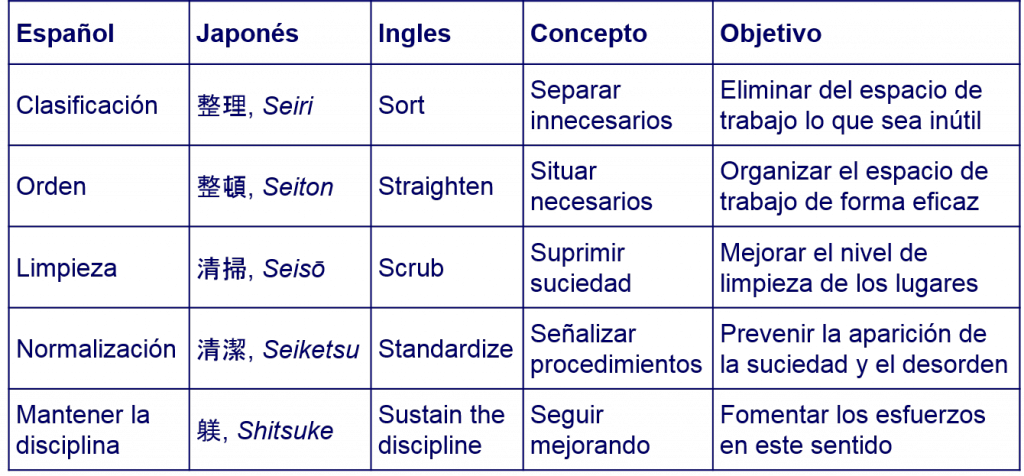

Os voy a poner un ejemplo donde creo que esta técnica va a ser muy interesante como herramienta de aprendizaje. Supongamos que queremos explicar a una clase de unos 30 alumnos los conceptos básicos de Lean Construction. La idea es hacer reflexionar sobre las pérdidas de todo tipo que existe en una obra de construcción por muy distintos motivos. Esas pérdidas influyen notablemente en la calidad, plazo y coste de la obra.