En un artículo anterior, «Jerga, falacias y encuestas electorales: Las hipótesis en la investigación científica«, expliqué lo que es una hipótesis de investigación y los errores estadísticos asociados. En aquel artículo se habló del nivel de significación α como la probabilidad de rechazar una hipótesis nula cuando es cierta. Por cierto, como curiosidad hay que decir que se llama «hipótesis nula» porque es la afirmación de una «ausencia de efecto» o de «no diferencia».

Para simplificar, supongamos un test de embarazo. En este caso, la hipótesis nula es no estar embarazada. Si el test da positivo, no estando embarazada, a este error se le denomina Tipo I o falso positivo. Este error también ocurriría cuando se realiza una operación quirúrgica a un individuo sano, se condena a un inocente o se suspende a un alumno que ha estudiado mucho. También se suele llamar a esta error el RIESGO DEL FABRICANTE, pues es la probabilidad de que el comprador le rechace un lote de producto correcto.

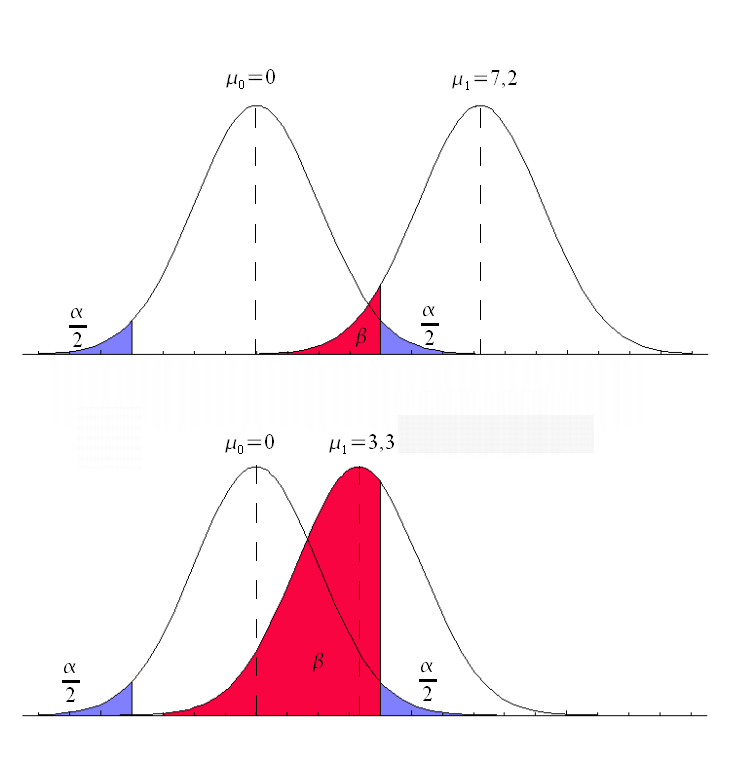

Normalmente se acepta un umbral de α=0,05 , por debajo del cual se puede decir que existe una diferencia entre los resultados del estudio y la hipótesis nula, cuando realmente no hay ninguna diferencia. No obstante, dependiendo del tipo de test y su finalidad, los umbrales pueden ser diferentes a 0,05. Para simplificar la decisión, se utiliza el concepto de significación muestra de la hipótesis nula o «p-valor«, que es la probabilidad de que un resultado sea correcto bajo una hipótesis nula. Así, si el p-valor obtenido es inferior al nivel de significación exigido, se rechazará la hipótesis nula.

Sin embargo, en este artículo me interesa centrarme en un aspecto a veces olvidado, o al menos al que se le da menor importancia que al nivel de significación. Este aspecto es la potencia de un test estadístico, muy relacionado con los falsos negativos. Supongamos, por ejemplo, que a una mujer embarazada el test le dice que no lo está, que se declara inocente a un asesino, que no se opera a un enfermo con metástasis o que se aprueba a alumnos que no han estudiado. Está claro que aquí el test no ha tenido la potencia suficiente como para detectar que ha habido un efecto. Dicho de otra forma, la potencia estadística de un test debe distinguir la señal del ruido. El gran problema que planteamos es que deberíamos distinguir si realmente ha habido un efecto determinado o bien el test no ha sido capaz de detectarlo.

Para ello debemos definir el error Tipo II, β o falso negativo. Se trata del error cometido al aceptar la hipótesis nula cuando ésta no es cierta. Pues bien, la potencia de la prueba se define como 1-β. También se le llama RIESGO DEL COMPRADOR, pues indica la probabilidad de aceptar un lote defectuoso de un fabricante. ¿Qué porcentaje delincuentes voy a declarar culpables en un juicio? ¿Qué probabilidad es aceptable para decir que un fármaco realmente es útil para una enfermedad? Vemos que esos porcentajes, es decir, la potencia del test, puede ser variable. Aunque es habitual exigir entre un 80 y 90%.

Como podemos ver, no tiene la misma importancia un falso positivo que un falso negativo. Imaginemos una prueba que detecta contaminación letal en un alimento. No es lo mismo decir que el alimento está contaminado, cuando no lo está, que afirmar que no hay contaminación, cuando sí que la hay. El resultado final es que el falso negativo puede provocar muertes, mientra que el falso positivo no.

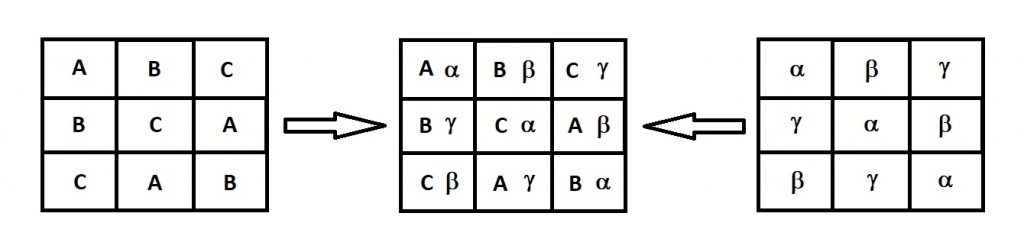

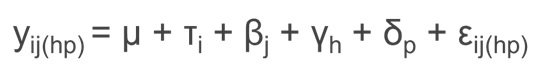

Pues bien, en una prueba estadística, el nivel de significación, la potencia y el tamaño muestral, se encuentran relacionados. La única forma de bajar los falsos positivos y falsos negativos es aumentar el tamaño muestral. No obstante, como la potencia de la prueba trata de distinguir el efecto del ruido, también se podría incrementar dicha potencia utilizando muestras lo más homogéneas posibles (disminuyendo su variabilidad), utilizando instrumentos de medida muy fiables o utilizando contrastes concretos, entre otros.

Eso explica que, en el caso de los exámenes a nuestros estudiantes, una forma de reducir los suspensos a los alumnos que han estudiado y de suspender al máximo de número de estudiantes que no han estudiado, consiste en aumentar el número de preguntas. Además, deberíamos diseñar el examen de forma que las preguntas permitan distinguir claramente si se conoce o no un concepto.

Os paso algunos vídeos que explican estos conceptos de potencia de una prueba. Espero que os sean útiles.

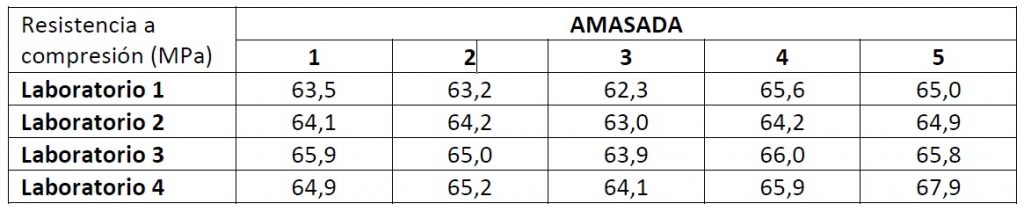

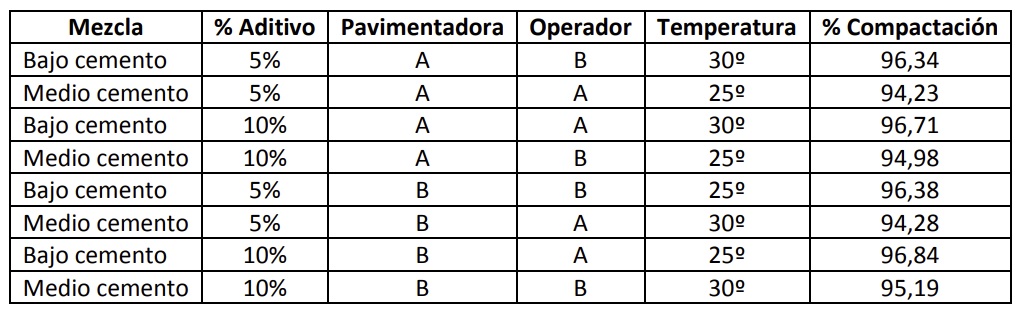

A continuación os resuelvo un pequeño problema con MINITAB al respecto. Se quiere saber qué tamaño de muestra deberemos elegir para detectar diferencias respecto a la media mayor de 2 MPa un 80% de las veces, suponiendo un nivel de confianza del 95%. Suponemos conocida la desviación típica, que es de 3 MPa.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.