Cuando pensamos en un experimento, solemos imaginar una prueba simple para ver qué opción es “mejor”. Sin embargo, esta visión apenas roza la superficie de una disciplina profunda y estratégica. Existen principios sorprendentes que rigen el diseño experimental y son cruciales no solo para la ciencia, sino también para cualquier toma de decisiones informada. A continuación, se describen brevemente los tipos de experimentos que pueden utilizarse en la investigación científica.

Cuando pensamos en un experimento, solemos imaginar una prueba simple para ver qué opción es “mejor”. Sin embargo, esta visión apenas roza la superficie de una disciplina profunda y estratégica. Existen principios sorprendentes que rigen el diseño experimental y son cruciales no solo para la ciencia, sino también para cualquier toma de decisiones informada. A continuación, se describen brevemente los tipos de experimentos que pueden utilizarse en la investigación científica.

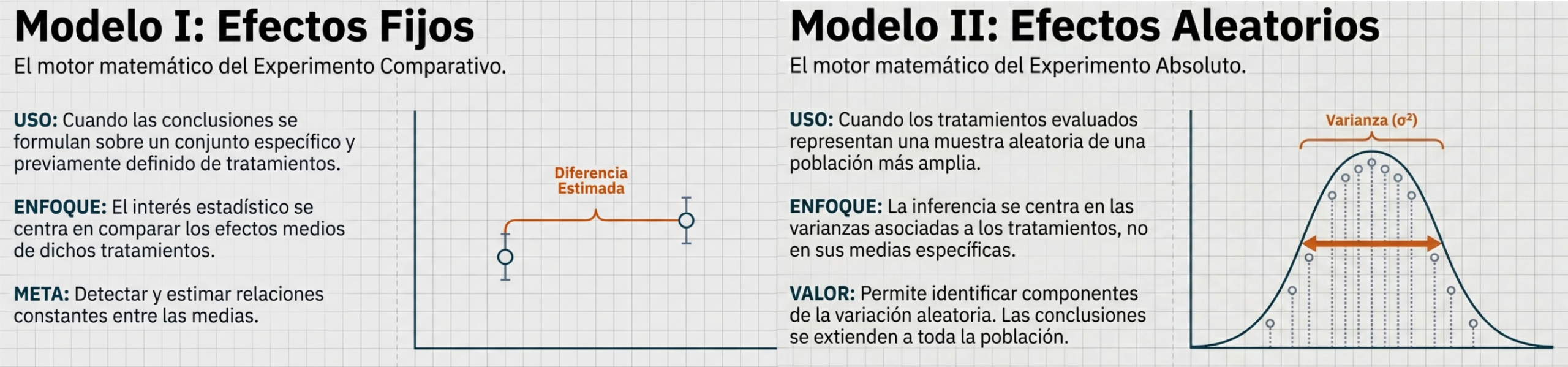

El diseño experimental se clasifica en dos categorías principales, según la propuesta de Anscombe (1947): el experimento absoluto y el experimento comparativo. El experimento absoluto se enfoca en la medición de propiedades físicas constantes para ampliar el conocimiento científico, utilizando un modelo estadístico de efectos aleatorios (Modelo II de Eisenhart), ya que los tratamientos se seleccionan al azar de una población más amplia. Por el contrario, el experimento comparativo está orientado a la toma de decisiones en ciencias aplicadas, con el fin de determinar cuál de varios tratamientos predefinidos es “mejor”. Este enfoque utiliza un modelo de efectos fijos (Modelo I de Eisenhart) y exige una definición precisa del problema para garantizar su validez.

El éxito de un experimento, especialmente el comparativo, depende del cumplimiento de cinco principios fundamentales: simplicidad, nivel de precisión adecuado, ausencia de error sistemático, amplio rango de validez de las conclusiones y una correcta cuantificación de la incertidumbre. La elección del diseño y el modelo estadístico asociado (fijo, aleatorio o mixto) determinan directamente el alcance y la naturaleza de las inferencias que pueden extraerse, vinculando de manera inseparable la planificación experimental con las conclusiones científicas y las decisiones de gestión.

Uno de ellos es el llamado experimento absoluto. En este tipo de experimento, el interés principal es medir y conocer las propiedades físicas de una población. Se asume que dichas propiedades permanecen constantes, lo que justifica el uso del término absoluto. El objetivo no es comparar alternativas concretas, sino ampliar el conocimiento científico sobre el fenómeno estudiado.

Los experimentos absolutos suelen centrarse en un solo factor y consideran un número limitado de tratamientos o niveles de ese factor. Estos tratamientos suelen elegirse de forma aleatoria. Por esta razón, si el experimento se repite, no es obligatorio utilizar exactamente los mismos tratamientos en cada ocasión.

Debido a esta forma de selección, los tratamientos se consideran variables aleatorias. En consecuencia, el análisis se basa en un modelo de efectos aleatorios, también conocido como el Modelo II de Eisenhart (1947). Este tipo de modelo permite identificar y estimar los distintos componentes de la variación aleatoria presentes en una población compuesta, lo que constituye un enfoque especialmente útil para muchos problemas de ingeniería.

El experimento comparativo es el segundo tipo de experimento descrito por Anscombe. Este enfoque se utiliza cuando se analizan varios tratamientos y se observa que, aunque los valores absolutos de los resultados pueden fluctuar de forma irregular, las comparaciones relativas entre tratamientos suelen mantenerse estables. En este contexto, es posible concluir que, bajo condiciones similares, algunos tratamientos ofrecen resultados claramente mejores que otros.

Brownlee (1957) sitúa este tipo de experimentos en el ámbito de las ciencias aplicadas, y no es casualidad: la teoría estadística del diseño de experimentos se desarrolló originalmente para responder a las necesidades de este tipo de estudios.

En un experimento comparativo, los tratamientos se evalúan según su efecto promedio sobre una variable de respuesta, con el objetivo principal de determinar cuál es “mejor” según un criterio definido. A diferencia de los experimentos orientados al conocimiento fundamental, aquí el propósito central es apoyar la toma de decisiones prácticas, especialmente las administrativas o de gestión.

Una característica fundamental de los experimentos comparativos es que todos los tratamientos de interés están incluidos explícitamente en el estudio. Por esta razón, el análisis se basa en un modelo de efectos fijos, también conocido como el Modelo I de Eisenhart (1947). Si el experimento se repite, se utilizan exactamente los mismos tratamientos, ya que no se considera una muestra aleatoria. El interés principal radica en detectar y estimar relaciones constantes entre las medias de los tratamientos, lo que conduce naturalmente a la evaluación de hipótesis estadísticas sobre dichas medias.

Para que un experimento comparativo sea válido, debe comenzar con una definición clara y precisa del problema. No basta con plantear de manera general la idea de “comparar tratamientos”. Es imprescindible especificar con detalle los objetivos del estudio y formular con precisión las hipótesis que se probarán. Esta definición inicial determina la población a la que se aplicarán las conclusiones, identifica los factores, los tratamientos y sus niveles, establece las variables de respuesta que se medirán y define qué diferencias entre tratamientos se consideran relevantes. Sin estas especificaciones, no es posible diseñar un experimento adecuado.

Finalmente, una consecuencia natural de los experimentos comparativos es que casi siempre conducen a decisiones concretas. Dado un nivel suficiente de recursos, la hipótesis nula de igualdad entre tratamientos puede rechazarse, lo que obliga a actuar: mantener la situación actual o cambiar a un nuevo tratamiento. Este proceso de decisión consta de dos etapas bien definidas:

- Análisis estadístico de los datos, en el que se evalúan las probabilidades asociadas a los resultados y se extraen conclusiones técnicas.

- Decisión de gestión en la que, con base en esas conclusiones, se define la acción a realizar.

Esta conexión directa entre el análisis estadístico y la toma de decisiones explica por qué los experimentos comparativos son una herramienta central en la divulgación y la práctica de la ingeniería y de las ciencias aplicadas.

El estadístico cumple un rol clave en el proceso experimental: su responsabilidad es presentar, con la mayor precisión posible, las probabilidades obtenidas en la etapa de análisis, de manera que se reduzca al mínimo la posibilidad de tomar decisiones equivocadas cuando llegue el momento de actuar.

Dado que las decisiones sobre las hipótesis dependen directamente de experimentos cuidadosamente planificados, es esencial que dichos ensayos cumplan con una serie de principios básicos. A continuación se resumen los más importantes, con un enfoque práctico para la ingeniería:

- Simplicidad: Tanto la selección de los tratamientos como la organización del experimento deben ser lo más simples posible. Un diseño sencillo facilita el análisis estadístico y la interpretación de los resultados y reduce el riesgo de errores innecesarios.

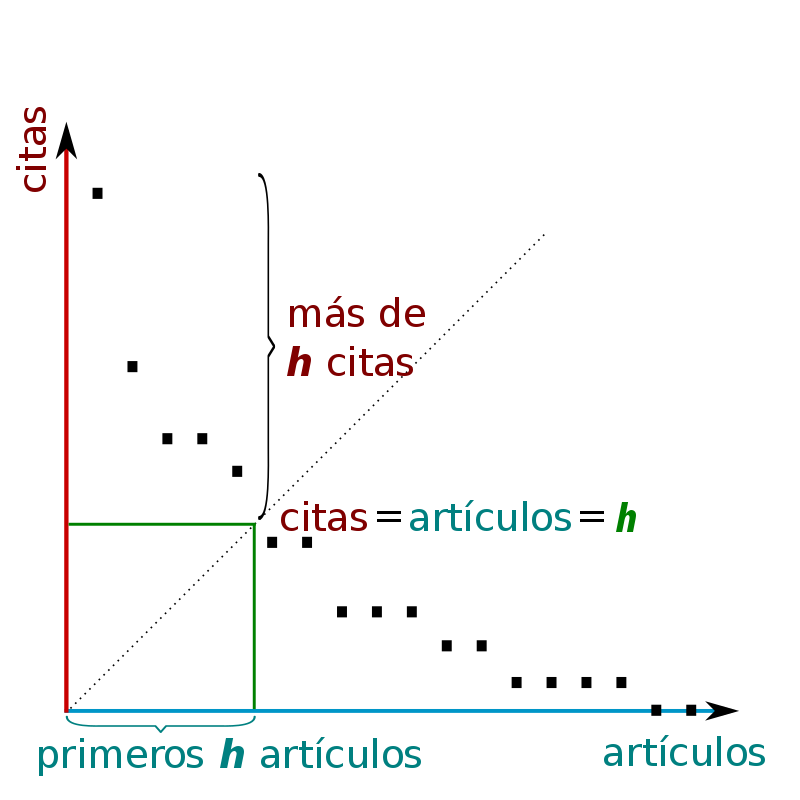

- Nivel de precisión: El experimento debe permitir detectar diferencias entre tratamientos con el grado de precisión que el investigador considere relevante. Para lograrlo, se requiere un diseño experimental adecuado y un número suficiente de repeticiones que garanticen mediciones confiables.

- Ausencia de error sistemático: El experimento debe planearse de modo que las unidades experimentales que reciben distintos tratamientos no difieran sistemáticamente entre sí antes de aplicarlos. Este cuidado es fundamental para obtener estimaciones insesgadas del efecto real de cada tratamiento, evitando que factores externos distorsionen los resultados.

- Rango de validez de las conclusiones: Las conclusiones del experimento deben ser aplicables a un rango de situaciones lo más amplio posible. Los experimentos replicados y los diseños factoriales ayudan a ampliar este rango de validez, ya que permiten evaluar la consistencia de los resultados bajo diferentes condiciones.

- Cuantificación de la incertidumbre: Todo experimento conlleva cierto grado de incertidumbre. Por ello, el diseño debe permitir calcular la probabilidad de que los resultados observados se deban únicamente al azar. Esta cuantificación es esencial para evaluar la solidez de las conclusiones.

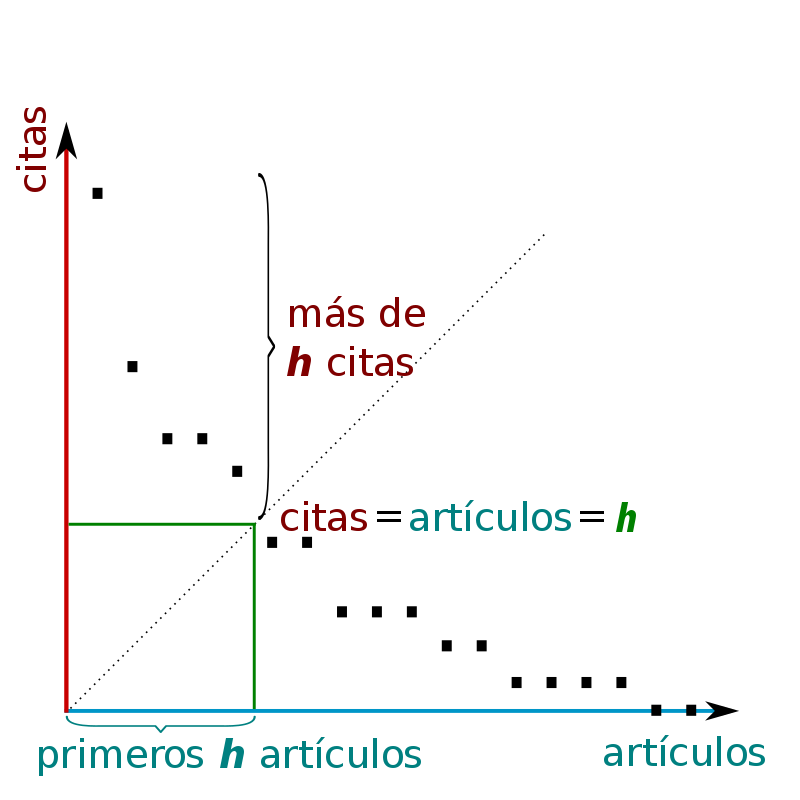

Estos principios conducen a una clasificación clásica de los modelos estadísticos, propuesta por Eisenhart (1947), que conecta el diseño del experimento con el tipo de inferencia que se desea realizar:

- Modelo de efectos fijos: se utiliza cuando las conclusiones se formulan sobre un conjunto específico y previamente definido de tratamientos. En este caso, el interés estadístico se centra en comparar los efectos medios de dichos tratamientos.

- Modelo de efectos aleatorios: se aplica cuando los tratamientos evaluados representan una muestra aleatoria de una población más amplia de tratamientos. Aquí, las conclusiones se extienden más allá de los tratamientos observados y la inferencia se centra en las varianzas asociadas a dichos tratamientos.

- Modelo de efectos mixtos: surge cuando el experimento combina tratamientos de efectos fijos y aleatorios en un mismo estudio.

Esta clasificación permite comprender cómo las decisiones sobre el diseño experimental influyen directamente en el tipo de conclusiones que pueden extraerse, un aspecto fundamental tanto en la práctica como en la divulgación de la ingeniería.

En este archivo de audio puedes escuchar una conversación sobre los tipos de experimentos.

En este vídeo se resumen las ideas más importantes sobre este tema.

Referencias:

Anscombe, F. J. (1947). The validity of comparative experiments. Journal of the Royal Statistical Society, 61, 181–211.

Brownlee, K. A. (1957). The principles of experimental design. Industrial Quality Control, 13, 1–9.

Eisenhart, C. (1947). The assumptions underlying the analysis of variance. Biometrics, 3, 1–21.

Melo, O. O., López, L. A., & Melo, S. E. (2007). Diseño de experimentos: métodos y aplicaciones. Universidad Nacional de Colombia. Facultad de Ciencias.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.