En este artículo tratamos aspectos relacionados con la precisión y la exactitud que deben tener las magnitudes que manejamos los ingenieros. A veces se confunden estos conceptos y, en otras, no tenemos claro qué es un error. Vamos, pues, a dar unas breves definiciones y enlaces que permitan divulgar estas ideas.

En este artículo tratamos aspectos relacionados con la precisión y la exactitud que deben tener las magnitudes que manejamos los ingenieros. A veces se confunden estos conceptos y, en otras, no tenemos claro qué es un error. Vamos, pues, a dar unas breves definiciones y enlaces que permitan divulgar estas ideas.

Se puede definir la Metrología como la ciencia de la medida. Esta ciencia comprende la totalidad de los métodos sistemáticos que utilizamos para cuantificar características de calidad.

Medir es comparar una cantidad con su unidad correspondiente, con el fin de determinar cuántas veces la primera contiene a la segunda.

Los procedimientos de medición de una magnitud física consisten en la caracterización del estado o la intensidad de la misma, de manera repetible y suficientemente precisa, mediante un valor que la eleve por encima de la mera percepción subjetiva.

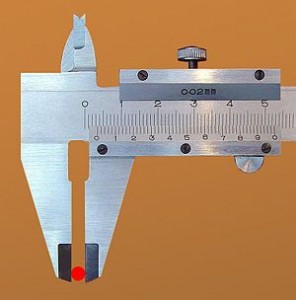

Un aparato de medida es cualquier instrumento capaz de facilitar indicaciones dentro de su campo de medida y división de escala, cuando se aplica sobre mesurando concretos.

Pero ¿qué es el error de medición?

Cualquier medición de una magnitud difiere del valor real, lo que produce una serie de errores que pueden clasificarse según las distintas fuentes de origen. El error experimental siempre existirá y depende básicamente del procedimiento elegido y de la tecnología disponible para realizar la medición.

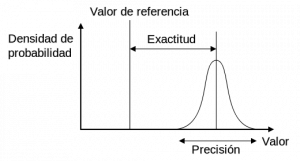

El error de exactitud es la desviación entre la media de los valores observados y el valor real. Es un error sistemático que puede ser positivo o negativo, equivalente al valor que hay que corregir para calibrar el equipo, o sea, ajustarlo a su valor verdadero.

El error de precisión se calcula a partir de la realización de un número de mediciones en una misma pieza o patrón, las cuales variarán entre sí, por lo que este error es de tipo aleatorio. Esta dispersión es inherente a todos los equipos de medida, debido a las holguras de sus mecanismos, variaciones en la fuente de alimentación de un circuito eléctrico, etc. Se suele dar en función de la desviación típica, por lo que se necesita efectuar un mínimo de mediciones para que tenga un nivel de confianza.

Una vez efectuadas las correcciones de exactitud, las medidas deben presentarse con su incertidumbre, es decir, con el margen probable de error dentro del cual se estima que se encuentra el valor exacto. Según el acuerdo adoptado por EAL (European Cooperation for Accreditation of Laboratories), se ha decidido emplear un intervalo de incertidumbre de dos desviaciones típicas, que, en el caso de una distribución normal, corresponde a un nivel de confianza del 95,44%.

Los errores pueden tener diversas fuentes conocidas, tales como la influencia del operador, la variación entre operadores, las diferencias entre las piezas a medir, la variación del equipo de medición y del método seguido, e incluso la variación entre laboratorios. Las medidas observadas son el resultado de todas las variaciones.

El error total puede calcularse en función de los tipos de error que influyen en la medición. Si los errores son independientes entre sí, la varianza del error combinado será la suma de las varianzas de los errores parciales. Si hay influencia entre ellos, habría que añadir sumandos teniendo en cuenta los coeficientes de correlación correspondientes.

Para entender estos conceptos y otros relacionados, como el de fiabilidad y validez de los datos, os dejo el siguiente vídeo de la Universidad de Murcia. Espero que os guste.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.