Resolver problemas en el ámbito universitario o profesional, en áreas tecnológicas, de ingeniería y ciencias, puede plantear una serie de desafíos que pueden conducir a errores. Estos fallos pueden surgir por diversas razones que van desde no comprender el concepto subyacente hasta confiar demasiado en la tecnología.

Resolver problemas en el ámbito universitario o profesional, en áreas tecnológicas, de ingeniería y ciencias, puede plantear una serie de desafíos que pueden conducir a errores. Estos fallos pueden surgir por diversas razones que van desde no comprender el concepto subyacente hasta confiar demasiado en la tecnología.

En un artículo anterior mencioné algunos ejemplos de problemas teóricamente sencillos, pero que marean a nuestros estudiantes. Ahora vamos a analizar detalladamente algunas de estas razones y cómo se relacionan entre sí. También he incluido enlaces a otros artículos del blog donde reflexiono sobre este tipo de cuestiones.

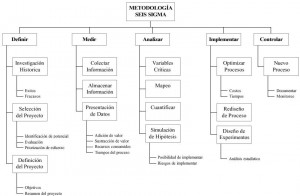

La falta de comprensión del concepto que subyace a un problema es una preocupación fundamental. Esto puede manifestarse de diversas formas, ya sea a través de errores conceptuales, una aplicación incorrecta del concepto o una interpretación errónea del mismo. Esta falta de entendimiento puede empeorar si se carece de experiencia o conocimientos específicos en el campo correspondiente. Cuando un estudiante o profesional se encuentra con un problema al que no se ha enfrentado antes, puede tener dificultades para aplicar correctamente los principios necesarios para resolverlo.

Los datos son fundamentales para encontrar soluciones, sin embargo, su calidad y disponibilidad pueden ser problemáticos. La falta de datos adecuados, la presencia de información contradictoria o sesgada pueden conducir a conclusiones incorrectas. Asimismo, enfocarse excesivamente en utilizar todos los datos disponibles puede distraer de la información realmente importante, al tiempo que validar datos sesgado o inventados puede conducir a conclusiones incorrectas.

El manejo inadecuado de las bases matemáticas también puede ser una fuente de errores (geometría, trigonometría, cálculo o álgebra). Esto puede incluir errores en el cálculo, así como el uso inadecuado de fórmulas o modelos matemáticos. Los problemas reales rara vez tienen una sola solución, lo que requiere habilidades para evaluar y decidir entre múltiples enfoques posibles. Además, la dependencia excesiva de la memoria en lugar de comprender los principios subyacentes puede llevar a errores conceptuales y de selección de modelos de cálculo.

Los aspectos psicológicos también desempeñan un papel importante. El estrés, la falta de confianza en uno mismo, la presión por terminar a tiempo y la falta de concentración pueden afectar la capacidad de resolver problemas de manera efectiva. La falta de atención a los detalles, la fatiga y el agotamiento también pueden contribuir a errores en la resolución de problemas.

Es crucial comprender que los problemas reales pueden ser complejos y no necesariamente tienen una solución única. Esto implica la necesidad de tomar decisiones informadas y comprender las limitaciones de los modelos o fórmulas utilizados. Además, la propagación de errores en las operaciones y la utilización incorrecta de datos, fórmulas o software pueden llevar a resultados incorrectos.

La falta de retroalimentación o revisión de los errores cometidos puede perpetuar la repetición de los mismos errores una y otra vez. La falta de comunicación o colaboración en entornos de trabajo entre profesionales también puede contribuir a errores en la resolución de problemas. La confianza excesiva en la tecnología o herramientas automatizadas sin una comprensión sólida de los principios subyacentes puede ser problemática.

En resumen, resolver problemas en el ámbito universitario o profesional de ingeniería y ciencias puede ser un proceso complejo y propenso a errores debido a una variedad de factores interrelacionados. Desde la comprensión del concepto hasta la calidad y disponibilidad de los datos, así como los aspectos psicológicos y técnicos relacionados con la resolución de problemas, es crucial abordar estos desafíos con atención y comprensión para lograr soluciones precisas y efectivas. Desde las universidades debe hacerse todo lo posible para superar este tipo de dificultades y conseguir que nuestros estudiantes adquieran las competencias necesarias para su posterior desarrollo profesional.

Sin querer ser exhaustivo, y sin que estén ordenadas por importancia, aquí os dejo una lista de 30 posibles causas por las cuales nuestros estudiantes en los exámenes o los técnicos en su ámbito profesional, suelen cometer errores al resolver los problemas. Estoy convencido de que hay más causas, pero esto puede ser un buen punto de partida para el debate y la reflexión. En el vídeo que he grabado me extiendo y explico algo más lo que aquí recogo como una simple lista.

- La falta de comprensión del concepto subyacente en un problema puede conducir a errores conceptuales al aplicarlo incorrectamente o interpretarlo de manera errónea.

- La inexperiencia o la falta de conocimientos específicos pueden surgir cuando una persona afronta un tipo de problema por primera vez, ya sea durante un examen o en la práctica profesional.

- Los problemas relacionados con la disponibilidad de datos pueden presentarse de varias formas, como datos insuficientes, necesarios, innecesarios o contradictorios. A menudo, existe una obsesión por utilizar todos los datos disponibles en el enunciado del problema.

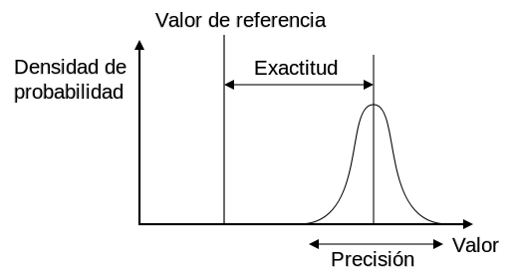

- La calidad de los datos también es un factor importante, con la posibilidad de incertidumbre o error en los datos disponibles. Además, dar por válidos datos sesgados, interesados o inventados puede llevar a conclusiones incorrectas. Es necesario un control de calidad de los datos.

- Intentar resolver un problema utilizando el enfoque típico visto en clase puede marear a nuestros estudiantes. Los alumnos prefieren resolver un problema típico explicado en clase, a ser posible, con datos parecidos.

- El manejo inadecuado de las bases matemáticas, que incluye errores en el cálculo, el uso incorrecto de fórmulas o modelos matemáticos, y la falta de comprensión de los principios subyacentes, puede ser una fuente común de errores. La falta de conocimientos básicos de geometría, trigonometría, álgebra o cálculo básicos son, en ocasiones, escollos. A veces hay dificultades en saber dibujar un esquema para resolver el problema.

- Los problemas reales generalmente no tienen una sola solución, lo que requiere habilidades para evaluar y decidir entre múltiples enfoques posibles. Esta distinción, que se da claramente entre los estudios de grado y los de máster, es importante tenerla en cuenta.

- Los aspectos psicológicos, como el estrés, la falta de confianza en uno mismo, la presión por terminar a tiempo y la falta de concentración, pueden afectar negativamente la capacidad para resolver problemas de manera efectiva.

- La falta de atención o interés, así como la fatiga o el agotamiento, pueden contribuir a errores en la resolución de problemas, al igual que la prisa por resolver el problema.

- La complejidad de los problemas puede aumentar cuando se trata de situaciones poco comunes o rebuscadas, lo que requiere un enfoque cuidadoso y creativo para su resolución.

- Es crucial comprender la diferencia entre una ley general y una fórmula particular al aplicar normas técnicas que pueden estar basadas en hipótesis o casos específicos.

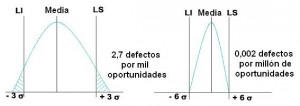

- Utilizar modelos de cálculo inadecuados, ya sean demasiado refinados o demasiado simples para los datos disponibles, puede conducir a soluciones incorrectas.

- Carecer de números estimativos para prever el resultado final puede resultar en una falta de comprensión del orden de magnitud del resultado. En este sentido, el uso de nomogramas en la docencia facilita la adquisición de este tipo de habilidad en los estudiantes. Los estudiantes y los profesionales deberían tener un conocimiento del “número gordo” y saber predimensionar.

- Es importante ser consciente de la propagación de errores en las operaciones, ya que incluso pequeños errores pueden magnificarse y llevar a resultados incorrectos.

- Utilizar fórmulas, datos o tablas en un contexto diferente al que dieron origen puede llevar a interpretaciones incorrectas o a soluciones erróneas.

- La extrapolación de resultados a límites no contemplados puede conducir a conclusiones incorrectas o poco realistas.

- Utilizar fórmulas empíricas con datos expresados en unidades diferentes a las que funcionan puede generar resultados inconsistentes o incorrectos.

- La dependencia excesiva de la memoria en lugar de comprender los principios subyacentes puede conducir a errores en la selección de modelos o fórmulas de cálculo.

- Errores conceptuales pueden llevar a la selección incorrecta de modelos o fórmulas de cálculo, lo que resulta en soluciones erróneas.

- El uso de software defectuoso o poco contrastado, así como la falta de habilidades para calcular manualmente un problema, pueden resultar en resultados incorrectos. A esto se une un uso inapropiado de la inteligencia artificial.

- El mal uso de ecuaciones o fórmulas, como cambiar el nombre de una variable sin entender el concepto subyacente, puede conducir a errores en la resolución de problemas.

- La falta de competencia o experiencia en una materia determinada puede resultar en una resolución incorrecta del problema.

- Repetir la resolución de problemas de un contexto a otro sin pensar en su validez puede conducir a soluciones inapropiadas.

- La falta de comprensión del problema, la pregunta o el tipo de resultado esperado puede resultar en soluciones incorrectas debido a la falta de comprensión lectora, capacidad analítica o de síntesis.

- La utilización de unidades defectuosas, notaciones o convenciones específicas puede llevar a interpretaciones erróneas o a soluciones incorrectas.

- La falta de retroalimentación o revisión de los errores cometidos puede perpetuar la repetición de los mismos errores una y otra vez.

- La falta de comunicación o colaboración en entornos de trabajo entre profesionales puede contribuir a errores en la resolución de problemas.

- La confianza excesiva en la tecnología o herramientas automatizadas puede llevar a la falta de comprensión de los principios subyacentes y a la comisión de errores.

- La falta de revisión o verificación de los cálculos realizados por parte de un tercero independiente puede resultar en soluciones incorrectas.

- La falta de conocimiento del contexto del problema, incluyendo las restricciones, puede conducir a soluciones subóptimas o incorrectas.

Os paso un vídeo donde he desarrollado las ideas anteriores, con ejemplos, y he dejado algunas de mis reflexiones al respecto. Espero que os guste.

Artículos relacionados en el blog:

De la regla de cálculo al ordenador: olvidarse de cómo se calculaba antes

Problemas teóricamente sencillos pero que marean a nuestros estudiantes

Referencias de libros de problemas:

MARTÍNEZ-PAGÁN, P.; YEPES, V.; MARTÍNEZ-SEGURA, M.A. (2023). Ejercicios resueltos de sistemas de transporte continuo: bombas y cintas transportadoras. Ediciones UPCT. Universidad Politécnica de Cartagena, 284 pp. ISBN: 978-84-17853-62-4

YEPES, V. (1997). Equipos de movimiento de tierras y compactación. Problemas resueltos. Colección Libro Docente nº 97.439. Ed. Universitat Politècnica de València. 253 pág. Depósito Legal: V-4598-1997. ISBN: 84-7721-551-0.

YEPES, V. (2023). Maquinaria y procedimientos de construcción. Problemas resueltos. Colección Académica. Editorial Universitat Politècnica de València, 562 pp. Ref. 376. ISBN 978-84-1396-174-3

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.