A pesar de los esfuerzos por realizar un presupuesto preciso, sigue siendo una estimación en condiciones de incertidumbre. Los proyectos únicos están expuestos a riesgos en múltiples aspectos, como su programación y costos.

A pesar de los esfuerzos por realizar un presupuesto preciso, sigue siendo una estimación en condiciones de incertidumbre. Los proyectos únicos están expuestos a riesgos en múltiples aspectos, como su programación y costos.

Las causas de la incertidumbre en los costos del proyecto son diversas e incluyen problemas de escala de precios, discrepancias entre los recursos necesarios y los proyectados, variaciones en las estimaciones de tiempo para actividades y cambios en los requisitos del proyecto.

Estos cambios pueden tener diversas causas, como suposiciones incorrectas del estimador, un mayor conocimiento del comportamiento del proyecto por parte del estimador o el promotor, o modificaciones en las bases legales en las que se realizó la estimación.

Para afrontar esta situación, un gestor de proyectos competente debe anticiparse y tomar medidas adecuadas, incluyendo planes de contingencia en caso de que algunos supuestos del proyecto no se cumplan. Una estrategia eficaz es implementar un enfoque para gestionar el riesgo.

En general, la gestión del riesgo abarca tres áreas: identificación, análisis y respuesta. La identificación implica examinar todas las posibles fuentes de riesgo en el proyecto. El análisis consiste en evaluar el impacto de decisiones mediante la asignación de distribuciones probabilísticas a los resultados. La respuesta implica decidir qué riesgos prepararse, cuáles ignorar y cuáles mantener como potenciales.

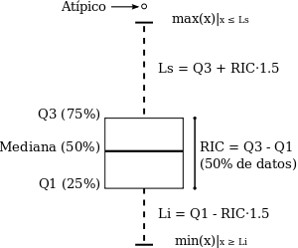

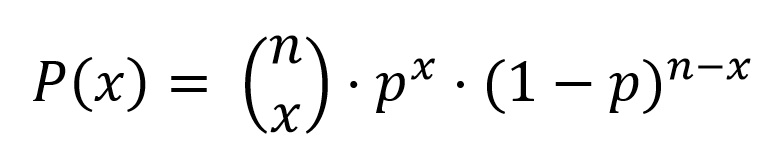

Existen diversas metodologías para estimar la probabilidad de cumplir un presupuesto específico. Una de ellas es la simulación, que proporciona información sobre el rango y la distribución de los costos del proyecto. Para ello, es necesario establecer valores pesimistas, optimistas y más probables para cada partida. El valor optimista se alcanza o se supera solo en el 1% o menos de los casos. El valor pesimista se alcanza o se supera solo en el 1% o menos de los casos. Por último, el valor más probable o realista representa la moda de la distribución de los datos.

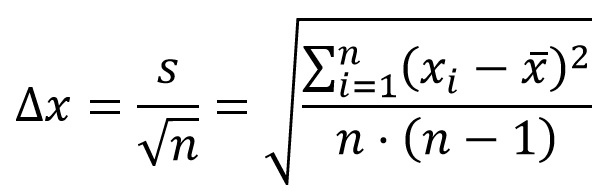

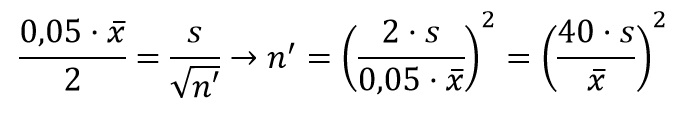

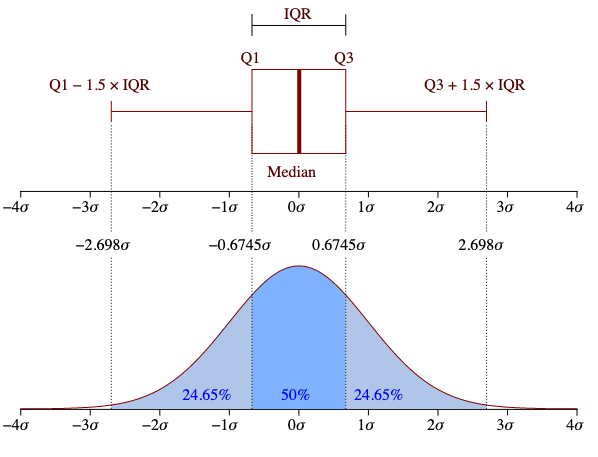

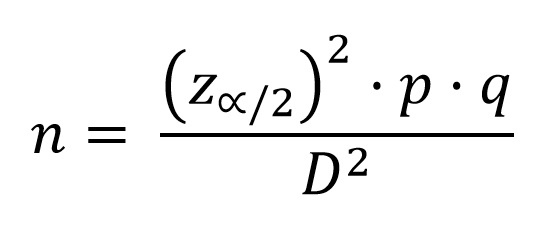

De esta forma, al igual que se haría en el caso del uso de la distribución Beta para el caso del PERT en la programación de proyectos. Concretamente, el coste medio se obtiene como la sexta parte de la suma del valor optimista, el pesimista y cuatro veces el más probable. De manera análoga, la desviación típica del coste de la partida correspondería a la sexta parte de la diferencia entre el coste pesimista y el optimista. El valor utilizado como cociente en este cálculo de la desviación típica está determinado por el intervalo de confianza deseado.

Las ponderaciones empleadas se fundamentan en una aproximación de la distribución de probabilidades denominada Beta. La elección de esta distribución es arbitraria y no se basa en datos empíricos. Se opta por ella debido a que es una distribución unimodal, no necesariamente simétrica, con extremos finitos y no negativos.

Si se cuenta con un número suficiente de partidas y se asume que el coste de cada una es estadísticamente independiente de las demás, se puede aplicar el Teorema Central del Límite. Esto permite aproximar la distribución del coste total del proyecto a una distribución normal, con la suma de las medias de los costes de cada partida como su media y la suma de las varianzas de cada partida como su varianza. Con la media y la desviación típica de la distribución normal, es posible calcular la probabilidad de cumplir con un presupuesto determinado.

Esta metodología se aplica con el propósito de superar la imprecisión de un problema estocástico, simplificándolo a uno determinístico mediante un cálculo simplificado. En lugar de considerar el coste total de la obra, se sustituye por la suma de las medias de todos los costes. Así, el coste se trata como una variable aleatoria y se introduce un enfoque probabilístico para su determinación, lo cual refleja mejor la realidad. Sin embargo, para que este enfoque sea válido, deben cumplirse las condiciones necesarias para aplicar el teorema central del límite.

A continuación os dejo un ejercicio completamente resuelto que, espero, os sea de interés. Este tipo de problemas forma parte del Curso de gestión de costes y producción de la maquinaria empleada en la construcción. Para los interesados, os dejo este enlace: https://ingeoexpert.com/cursos/curso-de-gestion-de-costes-y-produccion-de-la-maquinaria-empleada-en-la-construccion/

Referencias:

YEPES, V.; MARTÍ, J.V.; GONZÁLEZ-VIDOSA, F.; ALCALÁ, J. (2012). Técnicas de planificación y control de obras. Editorial de la Universitat Politècnica de València. Ref. 189. Valencia, 94 pp.

YEPES, V. (1997). Equipos de movimiento de tierras y compactación. Problemas resueltos. Colección Libro Docente n.º 97.439. Ed. Universitat Politècnica de València. 253 pág. Depósito Legal: V-4598-1997. ISBN: 84-7721-551-0.

YEPES, V. (2022). Gestión de costes y producción de maquinaria de construcción. Colección Manual de Referencia, serie Ingeniería Civil. Editorial Universitat Politècnica de València, 243 pp. Ref. 442.

YEPES, V. (2023). Maquinaria y procedimientos de construcción. Problemas resueltos. Colección Académica. Editorial Universitat Politècnica de València, 562 pp. Ref. 376. ISBN 978-84-1396-174-3

Cursos:

Curso de gestión de costes y producción de la maquinaria empleada en la construcción.

Esta obra está bajo una licencia de Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0 Internacional.